Snowflake ML : machine learning de bout en bout¶

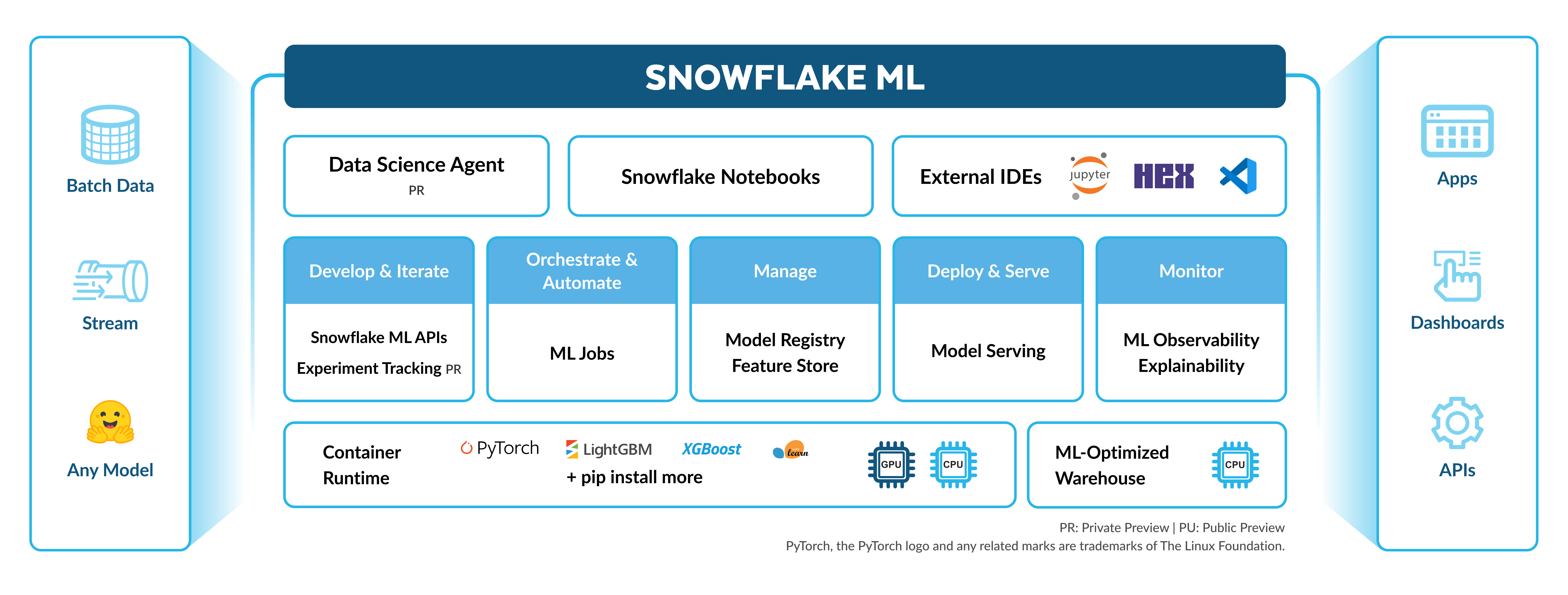

Snowflake ML est un ensemble intégré de capacités pour le machine learning de bout en bout dans une plateforme unique au-dessus de vos données gouvernées. Il s’agit d’un environnement unifié pour le développement et la production ML qui est optimisé pour l’ingénierie des fonctions distribuées à grande échelle, l’entraînement et l’inférence de modèles sur CPU et GPU Compute sans réglage ou configuration manuelle.

La mise à l’échelle des flux de travail ML de bout en bout dans Snowflake est transparente. Vous pouvez procéder comme suit :

Préparez les données.

Créez et utilisez des fonctions avec le Snowflake Feature Store.

Entraînez des modèles avec des CPUs ou des GPUs utilisant n’importe quel paquet open source de Snowflake Notebooks sur Container Runtime.

Créez des expériences pour évaluer vos modèles entraînés par rapport aux métriques définies.

Opérationnalisez vos pipelines à l’aide de Snowflake ML Jobs.

Déployez votre modèle pour l’inférence à l’échelle avec le Snowflake Model Registry

Contrôlez vos modèles de production avec ML Observability et Explainability.

Utilisez ML Lineage pour suivre les données sources vers les fonctionnalités, ensembles de données et modèles dans l’ensemble de votre pipeline ML.

Snowflake ML est également flexible et modulaire. Vous pouvez déployer les modèles que vous avez développés dans Snowflake en dehors de Snowflake et les modèles entraînés en externe peuvent facilement être introduits dans Snowflake pour l’inférence.

Fonctionnalités pour les scientifiques des données et les ingénieurs ML¶

Snowflake Notebooks sur Container Runtime¶

Snowflake Notebooks sur Container Runtime fournit un environnement de type Jupyter pour l’entraînement et la mise au point de modèles à grande échelle dans Snowflake, sans gestion de l’infrastructure. Commencez l’entraînement avec des paquets préinstallés tels que PyTorch, XGBoost, ou Scikit-learn, ou installez n’importe quel paquet à partir de référentiels open-source tels que HuggingFace ou PyPI. Container Runtime est optimisé pour s’exécuter sur l’infrastructure de Snowflake afin de vous fournir un chargement de données, un entraînement de modèle distribué et un réglage des hyperparamètres très efficaces.

Snowflake Feature Store¶

Snowflake Feature Store est une solution intégrée pour définir, gérer, stocker et découvrir les fonctions ML dérivées de vos données. Snowflake Feature Store prend en charge l’actualisation automatisée et incrémentielle à partir de sources de données par lots et en continu, de sorte que les pipelines de fonctions n’ont besoin d’être définis qu’une seule fois pour être continuellement mis à jour avec de nouvelles données.

Jobs ML¶

Utilisez Tâches Snowflake ML pour développer et automatiser des pipelines ML. Les tâches ML permettent également aux équipes qui préfèrent travailler à partir d’un IDE externe (Code VS, PyCharm, SageMaker Notebooks) pour distribuer des fonctions, des fichiers ou des modules vers Container Runtime de Snowflake.

Expériences¶

Utilisez les expériences pour enregistrer les résultats de votre entraînement de modèles et évaluer une collection de modèles de manière organisée. Les expériences vous aident à sélectionner le meilleur modèle pour votre cas d’utilisation pour passer en production. L’entraînement peut être enregistré dans une expérience pendant l’entraînement du modèle sur Snowflake, ou vous pouvez importer vos propres métadonnées et artefacts issus d’un entraînement antérieur. Après avoir terminé votre entraînement, consultez l’ensemble des résultats dans Snowsight et choisissez le modèle adapté à vos besoins.

Snowflake Model Registry et Model Serving¶

Registre des modèles de Snowflake permet de journaliser et de gérer tous vos modèles ML, qu’ils soient entraînés sur Snowflake ou sur d’autres plateformes. Vous pouvez utiliser Snowflake Model Registry pour effectuer une inférence à l’échelle. Vous pouvez utiliser Model Serving pour déployer les modèles vers Snowpark Container Service pour l’inférence.

Observabilité ML¶

L’observabilité ML fournit des outils pour surveiller les métriques de performance des modèles dans Snowflake. Vous pouvez suivre les modèles en production, surveiller les métriques de performance et de dérive, et définir des alertes pour les seuils de performance. En outre, utilisez la fonction d’explicabilité ML pour calculer les valeurs Shapley pour les modèles de Snowflake Model Registry, quel que soit l’endroit où ils ont été entraînés.

Lignée ML¶

ML Lineage est une fonctionnalité de traçage de bout en bout du lignage des artefacts ML depuis les données source jusqu’aux fonctions, aux ensembles de données et aux modèles. Cela permet la reproductibilité, la conformité et le débogage tout au long du cycle de vie des actifs ML.

Ensembles de données Snowflake¶

Les ensembles de données Snowflake fournissent un instantané immuable et versionné de vos données pouvant être ingéré par vos modèles de machine learning.

Fonctionnalités pour les analystes d’entreprise¶

Pour les analystes d’entreprise, utilisez Fonctions ML pour raccourcir le temps de développement de scénarios courants tels que la prévision et la détection d’anomalies dans votre organisation avec SQL.

Ressources supplémentaires¶

Consultez les ressources suivantes pour commencer à utiliser Snowflake ML :

Contactez votre représentant Snowflake pour un accès anticipé à la documentation sur les autres fonctionnalités en cours de développement.