A propos d’Openflow¶

Snowflake Openflow est un service d’intégration qui connecte n’importe quelle source de données et n’importe quelle destination avec des centaines de processeurs prenant en charge les données textuelles structurées et non structurées, les images, l’audio, la vidéo et les données de capteurs. Basé sur Apache NiFi, Openflow vous permet d’exploiter un service entièrement géré dans votre propre Cloud pour un contrôle total.

Note

La plateforme Openflow est actuellement disponible pour le déploiement dans les propres VPCs des clients, à la fois dans AWS et Snowpark Container Services.

Cette rubrique décrit les principales fonctionnalités d’Openflow, ses avantages, son architecture, son workflow et ses cas d’utilisation.

Fonctions clés et avantages¶

- Ouvert et extensible

Un service géré extensible alimenté par Apache NiFi, qui vous permet de créer et de développer des processeurs à partir de n’importe quelle source de données vers n’importe quelle destination.

- Plateforme unifiée d’intégration des données

Openflow permet aux ingénieurs de données de traiter des extractions et des chargements de données bidirectionnels complexes grâce à un service entièrement géré qui peut être déployé au sein de votre propre VPC ou au sein de votre déploiement Snowflake.

- Prêt pour l’entreprise

Openflow offre dès l’installation des mécanismes intégrés de sécurité, de conformité, d’observabilité et de maintenabilité pour l’intégration des données.

- Ingestion haute vitesse de tous les types de données

Une plateforme unifiée vous permet de gérer des données structurées et non structurées, en mode streaming et en lot, depuis votre source de données vers Snowflake, à quasiment toutes les échelles.

- Ingestion continue de données multimodales pour le traitement d’AI

Ingestion des données non structurées quasiment en temps réel pour vous permettre de discuter immédiatement avec vos données provenant de sources comme Sharepoint, Google Drive, etc.

Modèles Openflow - Snowflake Deployment¶

Openflow est pris en charge à la fois dans les versions Bring Your Own Cloud (BYOC) et Snowpark Container Services (SPCS).

Openflow - Snowflake Deployment (SPCS)

Openflow - Snowflake Deployment, en utilisant Snowpark Container Services (SPCS), fournit une solution rationalisée et intégrée pour la connexion. Étant donné que SPCS est un service entièrement autonome au sein de Snowflake, il est facile à déployer et à gérer, offrant un environnement pratique et rentable pour l’exécution de vos flux de données. Un avantage clé de Openflow - Snowflake Deployment est son intégration native au modèle de sécurité de Snowflake, qui permet une authentification, une autorisation et une sécurité réseau transparentes et des opérations simplifiées.

Lors de la configuration de Openflow - Snowflake Deployments, suivez le processus indiqué dans Configurer Openflow - Déploiement Snowflake.

Openflow BYOC

Openflow Bring Your Own Cloud (BYOC) fournit une solution de connexion que vous pouvez utiliser pour vous connecter en toute sécurité à des systèmes publics et privés et gérer le prétraitement des données sensibles localement, dans les limites sécurisées de l’environnement Cloud de votre entreprise. BYOC fait référence à une option de déploiement dans laquelle le moteur de traitement des données Openflow, ou le plan de données, s’exécute dans votre propre environnement Cloud, tandis que Snowflake gère l’ensemble du service Openflow et du plan de contrôle.

Lors de la configuration de déploiements BYOC, suivez le processus comme indiqué dans Configuration d’Openflow - BYOC.

Cas d’utilisation¶

Utilisez Openflow si vous souhaitez récupérer des données depuis n’importe quelle source et les envoyer vers n’importe quelle destination avec une gestion minimale, couplée à la sécurité et à la gouvernance des données intégrées de Snowflake.

Les cas d’utilisation d’Openflow incluent :

Ingérer des données à partir de sources de données non structurées, telles que Google Drive et Box, et les rendre prêtes pour le chat dans vos assistants AI avec Snowflake Cortex ou utiliser les données pour votre propre traitement personnalisé.

Répliquez la capture des données de changement (CDC) des tables de base de données dans Snowflake pour une réplication complète et centralisée.

Ingérer des événements en temps réel à partir de services de flux, tels qu’Apache Kafka, dans Snowflake pour des analyses en temps quasi réel.

Ingérer des données depuis des plateformes SaaS comme LinkedIn Ads vers Snowflake pour la création de rapports, les analyses et de les insights.

Créer un flux de données Openflow à l’aide de Snowflake et des processeurs et services de contrôleur<controllers/index> NiFi.

Sécurité¶

Snowflake utilise des fonctionnalités de sécurité de pointe qui vous assurent les plus hauts niveaux de sécurité pour votre compte, vos utilisateurs et toutes les données que vous stockez dans Snowflake. Voici quelques aspects clés :

- Authentification

Les exécutions utilisent l’OAuth2 pour l’authentification auprès de Snowflake.

- Autorisation

Openflow prend en charge des rôles à granularité fine pour RBAC

ACCOUNTADMIN pour accorder des privilèges pour pouvoir créer des déploiements et des environnements d’exécution

- Chiffrement en transit

Les connecteurs Openflow prennent en charge le protocole TLS, en utilisant des clients Snowflake standard pour l’ingestion des données.

Toutes les communications entre les déploiements Openflow et le plan de contrôle Openflow sont chiffrées à l’aide du protocole TLS.

- Gestion des secrets (BYOC)

Intégration avec AWS Secrets Manager ou Hashicorp Vault. Pour plus d’informations, voir Mots de passe chiffrés dans les fichiers de configuration.

- Support pour les liens privés

Les connecteurs Openflow sont compatibles avec la lecture et l’écriture de données dans Snowflake à l’aide d’une connexion PrivateLink AWS entrante.

- Tri-Secret Secure support

Le connecteur Openflow est compatible avec Tri-Secret Secure pour l’écriture des données sur Snowflake.

Architecture¶

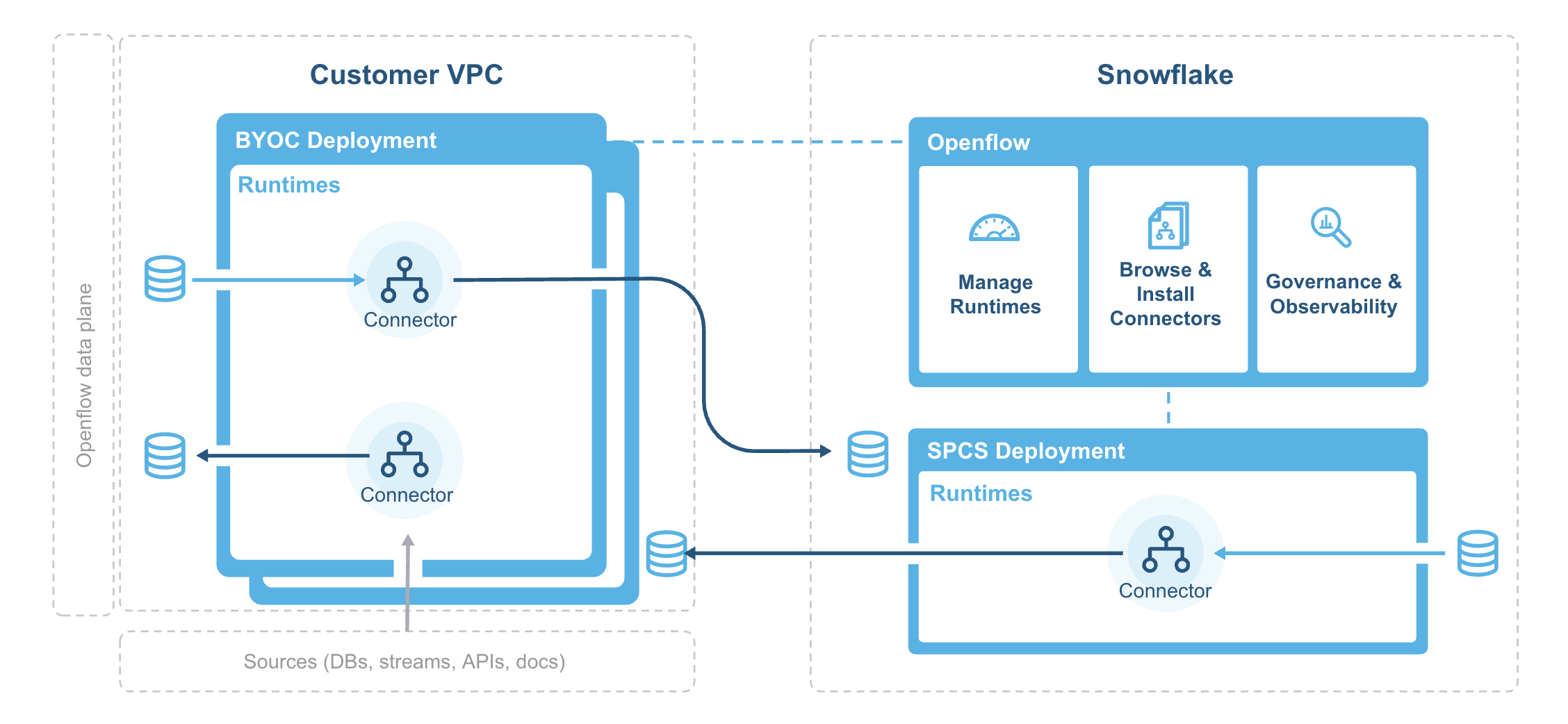

Le diagramme suivant illustre l’architecture Openflow :

L’agent de déploiement installe et démarre l’infrastructure de déploiement Openflow dans votre VPC et synchronise régulièrement les images de conteneurs à partir du registre d’images du système Snowflake.

Les composants Openflow comprennent :

- Déploiement

Un déploiement est l’endroit où vos flux de données s’exécutent, dans des exécutions individuelles. Vous aurez souvent plusieurs exécutions pour isoler différents projets et différentes équipes ou pour des raisons SDLC, le tout associé à un seul déploiement.

- Plan de contrôle

Le plan de contrôle est une couche de l’architecture contenant tous les composants utilisés pour gérer et observer, y compris le service et l’API Openflow, avec lesquels les utilisateurs interagissent via l’UI d’Openflow ou via une interaction directe avec les APIs Openflow. Sur les déploiements Openflow Snowflake, le plan de contrôle (CP) se compose d’une infrastructure ou de services Cloud publics appartenant à Snowflake et de l’application de plan de contrôle elle-même.

- Openflow - Snowflake Deployment

Les services Openflow - Snowflake Deployment sont déployés à l’aide d’un pool de calcul SPCS et sont soumis à des frais d’utilisation basés sur leur temps de fonctionnement et sur l’utilisation du calcul. Voir Considérations relatives aux coûts et à la mise à l’échelle des déploiements Openflow Snowflake pour plus d’informations.

Temps d’exécution

Les exécutions hébergent vos pipelines de données, le framework assurant sécurité, simplicité et évolutivité. Vous pouvez déployer des exécutions Openflow dans votre VPC à l’aide d’Openflow. Vous pouvez déployer des connecteurs Openflow dans vos exécutions, mais également créer des pipelines entièrement nouveaux en utilisant des processeurs et des services de contrôleur Openflow.

- Exécution Openflow - Snowflake Deployment

Une exécution Openflow - Snowflake Deployment est déployée sous la forme d’un service Openflow - Snowflake Deployment vers un déploiement Openflow - Snowflake Deployment, représenté par un pool de calcul sous-jacent. Les clients demandent une exécution Openflow - Snowflake Deployment par le biais du déploiement, qui exécute une requête pour le compte de l’utilisateur auprès du service. Une fois l’exécution créée, les clients y accèdent via un navigateur Web à l’adresse URL générée pour ce service Openflow - Snowflake Deployment en particulier.