pandas on Snowflake¶

O pandas no Snowpark permite que você execute seu código pandas diretamente em seus dados no Snowflake. Ao simplesmente alterar a instrução de importação e algumas linhas de código, é possível obter a experiência conhecida do pandas para desenvolver pipelines robustos, enquanto se beneficia perfeitamente do desempenho e da escalabilidade do Snowflake à medida que seus pipelines são dimensionados.

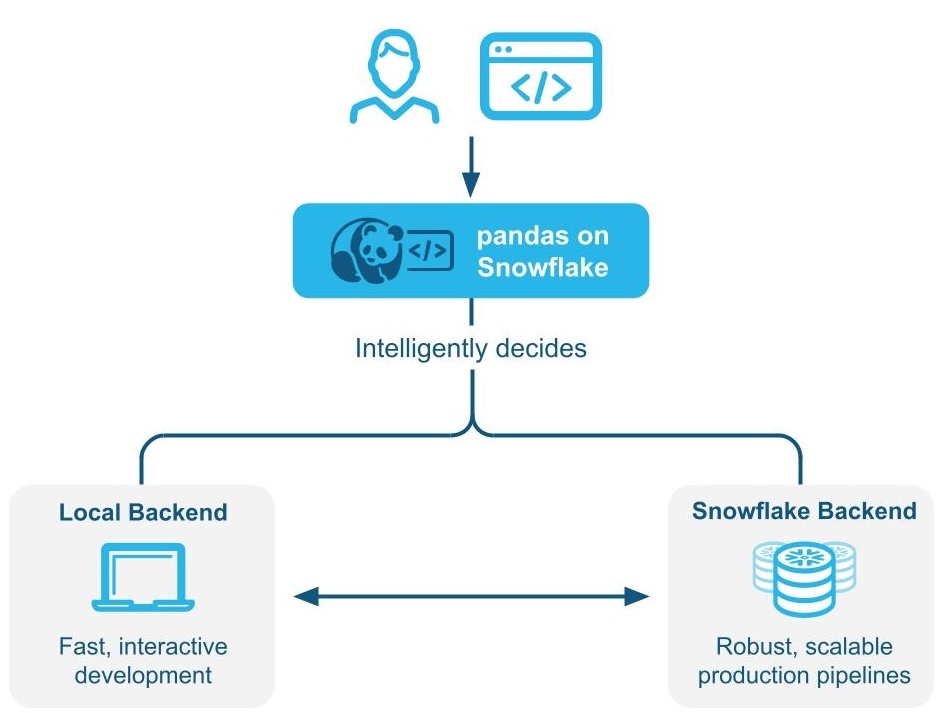

O pandas on Snowflake determina de forma inteligente se o código pandas deve ser executado localmente ou se deve-se usar o mecanismo Snowflake para dimensionar e melhorar o desempenho por meio de Execução híbrida. Ao trabalhar com grandes conjuntos de dados no Snowpark, ele executa cargas de trabalho nativamente no Snowflake por meio de transpilação para SQL, permitindo o aproveitamento da paralelização e os benefícios de governança e segurança de dados do Snowflake.

O pandas on Snowflake é fornecido pela API Snowpark pandas como parte da biblioteca Snowpark Python, que permite o processamento de dados escaláveis do código Python dentro da plataforma Snowflake.

Benefícios do uso de pandas on Snowflake¶

Alinhar-se com desenvolvedores Python em seu contexto: o pandas on Snowflake oferece uma interface familiar para desenvolvedores Python, fornecendo uma camada compatível com o pandas que pode ser executada nativamente no Snowflake.

Padas distribuído escalável: o pandas on Snowflake une a conveniência do pandas com a escalabilidade do Snowflake, aproveitando as técnicas de otimização de consulta existentes no Snowflake. São necessárias poucas reescritas de código, simplificando a jornada de migração para que você possa passar facilmente do protótipo à produção.

Nenhuma infraestrutura de computação adicional para gerenciar e ajustar: o pandas on Snowflake aproveita o poderoso mecanismo de computação do Snowflake, então você não precisa definir ou gerenciar nenhuma infraestrutura de computação adicional.

Como começar com o pandas on Snowflake¶

Nota

Para um exemplo prático de como usar pandas on Snowflake, verifique este Notebook e veja isto Vídeo.

Para instalar o pandas on Snowflake, é possível usar conda ou pip para instalar o pacote. Para obter instruções detalhadas, consulte Instalação.

pip install "snowflake-snowpark-python[modin]"

Depois que o pandas on Snowflake estiver instalado, em vez de importar o pandas como import pandas as pd, use as duas linhas a seguir:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

Aqui está um exemplo de como é possível começar a usar o pandas on Snowflake através da biblioteca pandas no Snowpark Python com o Modin:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

# Create a Snowpark session with a default connection.

from snowflake.snowpark.session import Session

session = Session.builder.create()

# Create a Snowpark pandas DataFrame from existing Snowflake table

df = pd.read_snowflake('SNOWFALL')

# Inspect the DataFrame

df

DAY LOCATION SNOWFALL

0 1 Big Bear 8.0

1 2 Big Bear 10.0

2 3 Big Bear NaN

3 1 Tahoe 3.0

4 2 Tahoe NaN

5 3 Tahoe 13.0

6 1 Whistler NaN

7 Friday Whistler 40.0

8 3 Whistler 25.0

# In-place point update to fix data error.

df.loc[df["DAY"]=="Friday","DAY"]=2

# Inspect the columns after update.

# Note how the data type is updated automatically after transformation.

df["DAY"]

0 1

1 2

2 3

3 1

4 2

5 3

6 1

7 2

8 3

Name: DAY, dtype: int64

# Drop rows with null values.

df.dropna()

DAY LOCATION SNOWFALL

0 1 Big Bear 8.0

1 2 Big Bear 10.0

3 1 Tahoe 3.0

5 3 Tahoe 13.0

7 2 Whistler 40.0

8 3 Whistler 25.0

# Compute the average daily snowfall across locations.

df.groupby("LOCATION").mean()["SNOWFALL"]

LOCATION

Big Bear 9.0

Tahoe 8.0

Whistler 32.5

Name: SNOWFALL, dtype: float64

read_snowflake oferece suporte à leitura de exibições Snowflake, tabelas dinâmicas, tabelas Iceberg e muito mais. Você também pode passar um SQL consulte diretamente e receba de volta um pandas on Snowflake DataFrame, facilitando a movimentação contínua entre SQL e pandas on Snowflake.

summary_df = pd.read_snowflake("SELECT LOCATION, AVG(SNOWFALL) AS avg_snowfall FROM SNOWFALL GROUP BY LOCATION")

summary_df

Como funciona a execução híbrida¶

Nota

Começando pela versão Snowpark Python 1.40.0, a execução híbrida é habilitada por padrão ao usar pandas on Snowflake.

O pandas on Snowflake usa execução híbrida para determinar se o código pandas deve ser executado localmente ou se deve-se usar o mecanismo Snowflake para dimensionar e aprimorar o desempenho. Isso permite que você continue escrevendo código pandas familiar para desenvolver pipelines robustos, sem ter que pensar na maneira mais ideal e eficiente de executar seu código, enquanto se beneficia perfeitamente do desempenho e da escalabilidade do Snowflake à medida que seus pipelines são dimensionados.

Exemplo 1: Crie uma pequena de 11 linhas DataFrame em linha. Com a execução híbrida, o Snowflake seleciona o backend pandas local e na memória para executar a operação:

# Create a basic dataframe with 11 rows

df = pd.DataFrame([

("New Year's Day", "2025-01-01"),

("Martin Luther King Jr. Day", "2025-01-20"),

("Presidents' Day", "2025-02-17"),

("Memorial Day", "2025-05-26"),

("Juneteenth National Independence Day", "2025-06-19"),

("Independence Day", "2025-07-04"),

("Labor Day", "2025-09-01"),

("Columbus Day", "2025-10-13"),

("Veterans Day", "2025-11-11"),

("Thanksgiving Day", "2025-11-27"),

("Christmas Day", "2025-12-25")

], columns=["Holiday", "Date"])

# Print out the backend used for this dataframe

df.get_backend()

# >> Output: 'Pandas'

Exemplo 2: Como criar uma tabela com 10 milhões de linhas de transações

# Create a 10M row table in Snowflake and populate with sythentic data

session.sql('''CREATE OR REPLACE TABLE revenue_transactions (Transaction_ID STRING, Date DATE, Revenue FLOAT);''').collect()

session.sql('''SET num_days = (SELECT DATEDIFF(DAY, '2024-01-01', CURRENT_DATE));''').collect()

session.sql('''INSERT INTO revenue_transactions (Transaction_ID, Date, Revenue) SELECT UUID_STRING() AS Transaction_ID, DATEADD(DAY, UNIFORM(0, $num_days, RANDOM()), '2024-01-01') AS Date, UNIFORM(10, 1000, RANDOM()) AS Revenue FROM TABLE(GENERATOR(ROWCOUNT => 10000000));''').collect()

# Read Snowflake table as Snowpark pandas dataframe

df_transactions = pd.read_snowflake("REVENUE_TRANSACTIONS")

Você pode ver que a tabela usa o Snowflake como backend, pois esta é uma tabela grande que reside no Snowflake.

print(f"The dataset size is {len(df_transactions)} and the data is located in {df_transactions.get_backend()}.")

# >> Output: The dataset size is 10000000 and the data is located in Snowflake.

#Perform some operations on 10M rows with Snowflake

df_transactions["DATE"] = pd.to_datetime(df_transactions["DATE"])

df_transactions.groupby("DATE").sum()["REVENUE"]

Exemplo 3: Filtragem de dados e execução de um groupby agregação resultando em 7 linhas de dados.

Quando os dados são filtrados, o Snowflake reconhece implicitamente a escolha de backend das alterações do mecanismo de Snowflake para pandas, já que a saída tem apenas 7 linhas de dados.

# Filter to data in last 7 days

df_transactions_filter1 = df_transactions[(df_transactions["DATE"] >= pd.Timestamp.today().date() - pd.Timedelta('7 days')) & (df_transactions["DATE"] < pd.Timestamp.today().date())]

# Since filter is not yet evaluated, data stays in Snowflake

assert df_transactions_filter1.get_backend() == "Snowflake"

# After groupby operation, result is transfered from Snowflake to Pandas

df_transactions_filter1.groupby("DATE").sum()["REVENUE"]

Observações e limitações¶

O tipo DataFrame sempre será

modin.pandas.DataFrame/Series/etcmesmo quando o backend muda, para garantir a interoperabilidade/compatibilidade com o código downstream.Para determinar qual backend usar, o Snowflake às vezes usa uma estimativa do tamanho da linha em vez de calcular o comprimento exato do DataFrame em cada etapa. Isso significa que o Snowflake pode nem sempre mudar para o back-end ideal imediatamente após uma operação quando o conjunto de dados fica maior/menor (por exemplo, filtro, agregação).

Quando há uma operação que combina duas ou mais DataFrames em diferentes backends, o Snowflake determina para onde mover os dados com base no menor custo de transferência de dados.

As operações de filtragem podem não resultar na movimentação de dados, porque o Snowflake pode não ser capaz de estimar o tamanho dos dados filtrados subjacentes.

Qualquer DataFrames composos de dados Python na memória usará o backend pandas, como o seguinte:

pd.DataFrame([1])

pd.DataFrame(pandas.DataFrame([1]))

pd.Series({'a': [4]})

An empty DataFrame: pd.DataFrame()

DataFrames passará automaticamente do mecanismo Snowflake para o mecanismo pandas em um conjunto limitado de operações. Essas operações incluem

df.apply,df.plot,df.iterrows,df.itertuples,series.items, e em operações de redução em que o tamanho dos dados é garantido ser menor. Nem todas as operações são pontos suportados onde a migração de dados pode ocorrer.A execução híbrida não move automaticamente uma DataFrame do pandas Engine de volta para o Snowflake, exceto nos casos em que uma operação como

pd.concatatua em vários DataFrames.O Snowflake não move automaticamente um DataFrame do pandas Engine de volta para o Snowflake, a menos que uma operação como

pd.concatatua em vários DataFrames.

Quando usar o pandas on Snowflake¶

Você deve usar pandas on Snowflake se alguma das seguintes condições for verdadeira:

Você está familiarizado com a API do pandas e o ecossistema PyData mais amplo.

Você trabalha em equipe com outras pessoas que estão familiarizadas com o pandas e querem colaborar na mesma base de código.

Você tem um código existente escrito em pandas.

Você prefere uma conclusão de código mais precisa em ferramentas de copiloto baseadas em AI.

Para obter mais informações, consulte DataFrames Snowpark vs. DataFrame Snowpark pandas: Qual devo escolher?

Como usar o pandas on Snowflake com Snowpark DataFrames¶

O pandas on Snowflake e DataFrame API é altamente interoperável, então você pode construir um pipeline que aproveite ambas as APIs. Para obter mais informações, consulte DataFrames Snowpark vs. DataFrame Snowpark pandas: Qual devo escolher?

Você pode usar as seguintes operações para fazer conversões entre Snowpark DataFrames e Snowpark pandas DataFrames:

Operação |

Entrada |

Saída |

|---|---|---|

Snowpark DataFrame |

DataFrame Snowpark pandas |

|

DataFrame Snowpark pandas ou série Snowpark Pandas |

Snowpark DataFrame |

Como o pandas on Snowflake se compara ao pandas nativo¶

O pandas on Snowflake e o pandas nativo têm DataFrame APIs com assinaturas correspondentes e semânticas semelhantes. O pandas on Snowflake fornece a mesma assinatura de API que o pandas nativo e fornece computação escalável com o Snowflake. O pandas on Snowflake respeita a semântica descrita na documentação do pandas nativo o máximo possível, mas usa o sistema de computação e tipo do Snowflake. No entanto, quando o pandas nativo é executado em uma máquina cliente, ele usa o sistema de computação e tipos Python. Para obter informações sobre o mapeamento de tipos entre pandas on Snowflake e Snowflake, consulte Tipos de dados.

A partir do Snowpark Python 1.40.0, o pandas on Snowflake é melhor utilizado com dados que já estão no Snowflake. Para converter entre o tipo nativo do pandas e o pandas on Snowflake, use as seguintes operações:

Operação |

Entrada |

Saída |

|---|---|---|

DataFrame Snowpark pandas |

DataFrame pandas nativo: materialize todos os dados para o ambiente local. Se o conjunto de dados for grande, isso poderá resultar em um erro de falta de memória. |

|

pandas DataFrame nativo, dados brutos, objeto Snowpark pandas |

DataFrame Snowpark pandas |

Ambiente de execução¶

pandas: opera em uma única máquina e processa dados na memória.pandas on Snowflake: integra-se ao Snowflake, o que permite computação distribuída em um cluster de máquinas para grandes conjuntos de dados, enquanto aproveita o em memória pandas para processar pequenos conjuntos de dados. Essa integração permite o manuseio de conjuntos de dados muito maiores que excedem a capacidade de memória de uma única máquina. Observe que usar a do Snowpark pandas API requer uma conexão com o Snowflake.

Avaliação lenta e adiantada¶

pandas: executa as operações imediatamente e materializa os resultados completamente na memória após cada operação. Essa avaliação imediata das operações pode levar a um aumento da pressão sobre a memória, pois os dados precisam ser movidos extensivamente dentro da máquina.pandas on Snowflake: fornece a mesma experiência de API que o pandas. Ele imita o modelo de avaliação adiantada do pandas, mas cria internamente um gráfico de consulta avaliado lentamente para permitir a otimização entre as operações.As operações de fusão e transpilação por meio de um gráfico de consulta permitem oportunidades adicionais de otimização para o mecanismo de computação distribuído subjacente do Snowflake, o que diminui o custo e o tempo de execução do pipeline de ponta a ponta em comparação à execução do pandas diretamente no Snowflake.

Nota

APIs e APIs relacionadas a E/S cujo valor de retorno não é um objeto Snowpark pandas (ou seja,

DataFrame,SeriesouIndex) sempre avaliam de forma adiantada. Por exemplo:read_snowflaketo_snowflaketo_pandasto_dictto_list__repr__O método dunder,

__array__, que pode ser chamado automaticamente por algumas bibliotecas de terceiros, como o scikit-learn. Chamadas para esse método materializarão resultados na máquina local.

Fonte e armazenamento de dados¶

pandas: oferece suporte a vários leitores e gravadores listados na documentação do pandas nas ferramentas IO (texto, CSV, HDF5, …).pandas on Snowflake: pode ler e escrever de tabelas Snowflake e ler arquivos locais ou preparados, CSV, JSON ou Parquet. Para obter mais informações, consulte IO (leitura e gravação).

Tipos de dados¶

pandas: possui um rico conjunto de tipos de dados, como inteiros, flutuantes, cadeias de caracteres, tiposdatetimee tipos categóricos. Também oferece suporte a tipos de dados definidos pelo usuário. Os tipos de dados no pandas geralmente são derivados dos dados subjacentes e são aplicados de forma rigorosa.pandas on Snowflake: é limitado pelo sistema do tipo Snowflake, que mapeia objetos pandas para SQL traduzindo os tipos de dados do pandas para os tipos SQL no Snowflake. A maioria dos tipos de pandas tem um equivalente natural no Snowflake, mas o mapeamento nem sempre é um para um. Em alguns casos, vários tipos de pandas são mapeados para o mesmo tipo SQL.

A tabela a seguir lista os mapeamentos de tipos entre pandas e Snowflake SQL:

Tipo pandas |

Tipo de dados Snowflake |

|---|---|

Todos os tipos inteiros assinados/não assinados, incluindo tipos inteiros estendidos do pandas |

NUMBER(38, 0) |

Todos os tipos de float, incluindo os tipos de dados float estendidos do pandas |

FLOAT |

|

BOOLEAN |

|

STRING |

|

TIME |

|

DATE |

Todos os tipos |

TIMESTAMP_NTZ |

Todos os tipos |

TIMESTAMP_TZ |

|

ARRAY |

|

MAP |

Coluna de objeto com tipos de dados mistos |

VARIANT |

Timedelta64[ns] |

NUMBER(38, 0) |

Nota

Tipos de dados categóricos, de período, de intervalo, esparsos e definidos pelo usuário não são suportados. Atualmente, o Timedelta só é compatível com o cliente pandas no Snowpark. Ao escrever Timedelta de volta no Snowflake, ele será armazenado como tipo Number.

A tabela a seguir fornece o mapeamento dos tipos SQL Snowflake de volta para os tipos pandas on Snowflake usando df.dtypes:

Tipo de dados Snowflake |

Tipo pandas on Snowflake ( |

|---|---|

NUMBER ( |

|

NUMBER ( |

|

BOOLEAN |

|

STRING, TEXT |

|

VARIANT, BINARY, GEOMETRY, GEOGRAPHY |

|

ARRAY |

|

OBJECT |

|

TIME |

|

TIMESTAMP, TIMESTAMP_NTZ, TIMESTAMP_LTZ, TIMESTAMP_TZ |

|

DATE |

|

Ao converter um DataFrame do pandas Snowpark para um DataFrame do pandas nativo com to_pandas(), o DataFrame do pandas nativo terá tipos de dados refinados em comparação com os tipos do pandas on Snowflake, que são compatíveis com os Mapeamentos de tipos de dados SQL-Python para funções e procedimentos.

Conversão e inferência de tipos¶

pandas: depende de NumPy e por padrão segue o NumPy e sistema de tipos Python para conversão de tipos implícita e inferência. Por exemplo, ele trata boolianos como tipos inteiros, então1 + Trueretorna2.pandas on Snowflake: mapeia os tipos NumPy e Python para tipos Snowflake de acordo com a tabela anterior e usa o sistema de tipos Snowflake subjacente para conversão de tipos e inferência implícitos. Por exemplo, de acordo com Tipos de dados lógicos, ele não converte implicitamente boolianos em tipos inteiros, então1 + Trueresulta em um erro de conversão de tipo.

Tratamento de valor nulo¶

pandas: nas versões 1.x do pandas, o pandas era flexível ao manipular dados ausentes, então tratou todo o PythonNone,np.nan,pd.NaN,pd.NAepd.NaTcomo valores ausentes. Em versões posteriores do pandas (2.2.x), esses valores são tratados como valores diferentes.pandas on Snowflake: adota uma abordagem semelhante às versões anteriores do pandas que trata todos os valores anteriores listados como valores ausentes. O Snowpark reutilizaNaN,NAeNaTdo pandas. Mas observe que todos esses valores ausentes são tratados de forma intercambiável e armazenados como SQL NULL na tabela Snowflake.

Aliases de offset/frequência¶

pandas: os offsets de data no pandas foram alterados na versão 2.2.1. Os aliases de uma única letra'M','Q','Y'e outros foram descontinuados em favor de offsets de duas letras.pandas on Snowflake: usa exclusivamente os novos offsets descritos ao documentação da série temporal dos pandas.

Instalar a biblioteca do pandas on Snowflake¶

Pré-requisitos

As seguintes versões do pacote são necessárias:

Python 3.9 (obsoleto), 3.10, 3.11, 3.12 ou 3.13

Modin versão 0.32.0

pandas versão 2.2.*

Dica

Para usar pandas on Snowflake em Snowflake Notebooks, consulte as instruções de configuração em pandas on Snowflake no notebooks.

Para instalar o pandas on Snowflake em seu ambiente de desenvolvimento, siga estas etapas:

Mude para o diretório do seu projeto e ative seu ambiente virtual Python.

Nota

A API está em desenvolvimento ativo, então recomendamos instalá-la em um ambiente virtual Python em vez de em todo o sistema. Essa prática permite que cada projeto criado use uma versão específica, protegendo você de alterações em versões futuras.

Você pode criar um ambiente virtual Python para uma versão específica do Python usando ferramentas como Anaconda, Miniconda ou virtualenv.

Por exemplo, para usar o conda para criar um ambiente virtual Python 3.12, execute estes comandos:

conda create --name snowpark_pandas python=3.12 conda activate snowpark_pandas

Nota

Se você instalou anteriormente uma versão mais antiga do pandas on Snowflake usando o Python 3.9 e o pandas 1.5.3, será necessário atualizar suas versões do Python e do pandas conforme descrito acima. Siga as etapas para criar um ambiente com Python 3.10 ou 3.13.

Instale a biblioteca Snowpark Python com o Modin:

pip install "snowflake-snowpark-python[modin]"

ou

conda install snowflake-snowpark-python modin==0.28.1

Nota

Confirme se a versão 1.17.0 ou posterior do

snowflake-snowpark-pythonestá instalada.

Autenticação no Snowflake¶

Antes de usar o pandas on Snowflake, é necessário estabelecer uma sessão com o banco de dados Snowflake. Você pode usar um arquivo de configuração para escolher os parâmetros de conexão para sua sessão ou pode enumerá-los em seu código. Para obter mais informações, consulte Como criar uma sessão para o Snowpark Python. Se existir uma sessão Python ativa exclusiva do Snowpark, o pandas on Snowflake a utilizará automaticamente. Por exemplo:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from snowflake.snowpark import Session

CONNECTION_PARAMETERS = {

'account': '<myaccount>',

'user': '<myuser>',

'password': '<mypassword>',

'role': '<myrole>',

'database': '<mydatabase>',

'schema': '<myschema>',

'warehouse': '<mywarehouse>',

}

session = Session.builder.configs(CONNECTION_PARAMETERS).create()

# pandas on Snowflake will automatically pick up the Snowpark session created above.

# It will use that session to create new DataFrames.

df = pd.DataFrame([1, 2])

df2 = pd.read_snowflake('CUSTOMER')

O pd.session é uma sessão do Snowpark, então você pode fazer com ela tudo o que faria com qualquer outra sessão do Snowpark. Por exemplo, você pode usá-lo para executar uma consulta SQL arbitrária, que resulta em um DataFrame do Snowpark conforme a API da sessão, mas observe que o resultado é um DataFrame do Snowpark, não um DataFrame do Snowpark pandas.

# pd.session is the session that pandas on Snowflake is using for new DataFrames.

# In this case it is the same as the Snowpark session that we've created.

assert pd.session is session

# Run SQL query with returned result as Snowpark DataFrame

snowpark_df = pd.session.sql('select * from customer')

snowpark_df.show()

Como alternativa, você pode configurar os parâmetros de conexão do Snowpark em um arquivo de configuração. Isso elimina a necessidade de enumerar parâmetros de conexão em seu código, o que permite que você escreva seu código pandas on Snowflake quase como normalmente escreveria o código pandas.

Crie um arquivo de configuração localizado em

~/.snowflake/connections.tomlque se pareça com isto:default_connection_name = "default" [default] account = "<myaccount>" user = "<myuser>" password = "<mypassword>" role="<myrole>" database = "<mydatabase>" schema = "<myschema>" warehouse = "<mywarehouse>"

Para criar uma sessão usando essas credenciais, use

snowflake.snowpark.Session.builder.create():import modin.pandas as pd import snowflake.snowpark.modin.plugin from snowflake.snowpark import Session # Session.builder.create() will create a default Snowflake connection. Session.builder.create() # create a DataFrame. df = pd.DataFrame([[1, 2], [3, 4]])

Você também pode criar várias sessões do Snowpark e atribuir uma delas ao pandas on Snowflake. O pandas on Snowflake usa apenas uma sessão, então você precisa atribuir explicitamente uma das sessões ao pandas on Snowflake com pd.session = pandas_session:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from snowflake.snowpark import Session

pandas_session = Session.builder.configs({"user": "<user>", "password": "<password>", "account": "<account1>").create()

other_session = Session.builder.configs({"user": "<user>", "password": "<password>", "account": "<account2>").create()

pd.session = pandas_session

df = pd.DataFrame([1, 2, 3])

O exemplo a seguir mostra que tentar usar o pandas on Snowflake quando não há uma sessão ativa do Snowpark resultará em um SnowparkSessionException com um erro como «pandas on Snowflake requer uma sessão ativa do Snowpark, mas não há nenhuma». Depois de criar uma sessão, você poderá usar o pandas on Snowflake. Por exemplo:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

df = pd.DataFrame([1, 2, 3])

O exemplo a seguir mostra que tentar usar pandas on Snowflake quando há várias sessões ativas do Snowpark causará SnowparkSessionException com uma mensagem como: “Há várias sessões ativas do Snowpark, mas é preciso escolher uma para pandas on Snowflake.”

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from snowflake.snowpark import Session

pandas_session = Session.builder.configs({"user": "<user>", "password": "<password>", "account": "<account1>"}).create()

other_session = Session.builder.configs({"user": "<user>", "password": "<password>", "account": "<account2>"}).create()

df = pd.DataFrame([1, 2, 3])

Nota

É necessário definir a sessão usada para uma nova pandas on Snowflake DataFrame ou série via modin.pandas.session. No entanto, os DataFrames de junção ou mesclagem criados com diferentes sessões não são compatíveis, portanto, você deve evitar configurar repetidamente diferentes sessões e criar DataFrames com diferentes sessões em um fluxo de trabalho.

Referência de API¶

Veja a referência da API pandas on Snowflake para obter a lista completa de APIs atualmente implementadas e métodos disponíveis.

Para obter uma lista completa de operações compatíveis, consulte as seguintes tabelas na referência do pandas on Snowflake:

APIs Parâmetro de configuração e para execução híbrida¶

A execução híbrida usa uma combinação da estimativa de tamanho do conjunto de dados e as operações que estão sendo aplicadas ao DataFrame para determinar a escolha do backend. Em geral, conjuntos de dados com menos de 100 mil linhas tendem a usar pandas local; aqueles com mais de 100 mil linhas tendem a usar o Snowflake, a menos que o conjunto de dados seja carregado a partir de arquivos locais.

Configuração dos custos de transferência¶

Para alterar o limite de alternância padrão para outro valor de limite de linha, você pode modificar a variável de ambiente antes de inicializar um DataFrame:

# Change row transfer threshold to 500k

from modin.config.envvars import SnowflakePandasTransferThreshold

SnowflakePandasTransferThreshold.put(500_000)

Definir este valor vinculará a transferência de linhas do Snowflake.

Configuração de limites de execução local¶

Uma vez por DataFrame é local, geralmente permanecerá local, a menos que haja necessidade de movê-lo de volta para Snowflake para uma fusão, mas há um limite superior considerado para o tamanho máximo dos dados que podem ser processados localmente. Atualmente este limite é de 10 milhões de linhas.

Verificação e configuração do back-end¶

Para verificar o back-end atual de sua escolha, você pode usar o df.getbackend() Comando, que retorna Pandas para execução local, ou Snowflake para a execução do pushdown.

Para definir o backend atual de escolha com set_backend ou seu alias move_to:

df_local = df.set_backend('Pandas')

df_local = df.move_to('Pandas')

df_snow = df.set_backend('Snowflake')

Você também pode definir o back-end no lugar:

df.set_backend('Pandas', inplace=True)

Para inspecionar e exibir informações sobre por que os dados foram movidos:

pd.explain_switch()

Seleção de backend de substituição manual por meio de fixação de backend¶

Por padrão, o Snowflake escolhe automaticamente o melhor back-end para um determinado DataFrame Operações e. Se quiser substituir a seleção automática do mecanismo, é possível desativar a ativação automática de um objeto e todos os dados resultantes produzidos por ele, usando o pan_backend() Método:

pinned_df_snow = df.move_to('Snowflake').pin_backend()

Para reativar a troca automática de back-end, chame unfix_backend():

unpinned_df_snow = pinned_df_snow.unpin_backend()

Uso de Snowpark pandas em notebooks Snowflake¶

Para usar pandas on Snowflake em notebooks Snowflake, consulte pandas on Snowflake em notebooks.

Uso de Snowpark pandas em planilhas Python¶

Para usar Snowpark pandas, você precisa instalar o Modin selecionando modin em Packages no ambiente da planilha do Python.

Você pode selecionar o tipo de retorno da função Python em Settings > Return type. Por padrão, isso é definido como uma tabela Snowpark. Para exibir o Snowpark pandas DataFrame como resultado, você pode converter um Snowpark pandas DataFrame em um Snowpark DataFrame chamando to_snowpark(). Nenhum custo de E/S será incorrido nesta conversão.

Aqui está um exemplo de uso do Snowpark pandas com o planilhas Python:

import snowflake.snowpark as snowpark

def main(session: snowpark.Session):

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

df = pd.DataFrame([[1, 'Big Bear', 8],[2, 'Big Bear', 10],[3, 'Big Bear', None],

[1, 'Tahoe', 3],[2, 'Tahoe', None],[3, 'Tahoe', 13],

[1, 'Whistler', None],['Friday', 'Whistler', 40],[3, 'Whistler', 25]],

columns=["DAY", "LOCATION", "SNOWFALL"])

# Print a sample of the dataframe to standard output.

print(df)

snowpark_df = df.to_snowpark(index=None)

# Return value will appear in the Results tab.

return snowpark_df

Como usar o pandas on Snowflake em procedimentos armazenados¶

É possível usar o pandas on Snowflake em um procedimento armazenado para criar um pipeline de dados e agendar a execução do procedimento armazenado com tarefas.

Veja como você pode criar um procedimento armazenado usando o SQL:

CREATE OR REPLACE PROCEDURE run_data_transformation_pipeline_sp()

RETURNS VARCHAR

LANGUAGE PYTHON

RUNTIME_VERSION = 3.12

PACKAGES = ('snowflake-snowpark-python','modin')

HANDLER='data_transformation_pipeline'

AS $$

def data_transformation_pipeline(session):

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from datetime import datetime

# Create a Snowpark pandas DataFrame with sample data.

df = pd.DataFrame([[1, 'Big Bear', 8],[2, 'Big Bear', 10],[3, 'Big Bear', None],

[1, 'Tahoe', 3],[2, 'Tahoe', None],[3, 'Tahoe', 13],

[1, 'Whistler', None],['Friday', 'Whistler', 40],[3, 'Whistler', 25]],

columns=["DAY", "LOCATION", "SNOWFALL"])

# Drop rows with null values.

df = df.dropna()

# In-place point update to fix data error.

df.loc[df["DAY"]=="Friday","DAY"]=2

# Save Results as a Snowflake Table

timestamp = datetime.now().strftime("%Y_%m_%d_%H_%M")

save_path = f"OUTPUT_{timestamp}"

df.to_snowflake(name=save_path, if_exists="replace", index=False)

return f'Transformed DataFrame saved to {save_path}.'

$$;

Veja como você pode criar um procedimento armazenado usando a Snowflake Python API:

from snowflake.snowpark.context import get_active_session

session = get_active_session()

from snowflake.snowpark import Session

def data_transformation_pipeline(session: Session) -> str:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from datetime import datetime

# Create a Snowpark pandas DataFrame with sample data.

df = pd.DataFrame([[1, 'Big Bear', 8],[2, 'Big Bear', 10],[3, 'Big Bear', None],

[1, 'Tahoe', 3],[2, 'Tahoe', None],[3, 'Tahoe', 13],

[1, 'Whistler', None],['Friday', 'Whistler', 40],[3, 'Whistler', 25]],

columns=["DAY", "LOCATION", "SNOWFALL"])

# Drop rows with null values.

df = df.dropna()

# In-place point update to fix data error.

df.loc[df["DAY"]=="Friday","DAY"]=2

# Save Results as a Snowflake Table

timestamp = datetime.now().strftime("%Y_%m_%d_%H_%M")

save_path = f"OUTPUT_{timestamp}"

df.to_snowflake(name=save_path, if_exists="replace", index=False)

return f'Transformed DataFrame saved to {save_path}.'

dt_pipeline_sproc = session.sproc.register(name="run_data_transformation_pipeline_sp",

func=data_transformation_pipeline,

replace=True,

packages=['modin', 'snowflake-snowpark-python'])

Para chamar o procedimento armazenado, é possível executar dt_pipeline_sproc() em Python ou CALL run_data_transformation_pipeline_sp() em SQL.

Como usar o pandas on Snowflake com bibliotecas de terceiros¶

O pandas é comumente usado com APIs de bibliotecas de terceiros para aplicativos de visualização e aprendizado de máquina. O pandas on Snowflake é interoperável com a maioria dessas bibliotecas, de modo que elas podem ser usadas sem a conversão explícita para o pandas DataFrames. No entanto, observe que a execução distribuída não costuma ser compatível com a maioria das bibliotecas de terceiros, exceto em casos de uso limitado. Portanto, isso pode levar a um desempenho mais lento em grandes conjuntos de dados.

Bibliotecas de terceiros compatíveis¶

As bibliotecas listadas abaixo aceitam pandas on Snowflake DataFrames como entrada, mas nem todos os seus métodos foram testados. Para obter um status detalhado da interoperabilidade em um nível de API, consulte Interoperabilidade com bibliotecas de terceiros.

Plotly

Altair

Seaborn

Matplotlib

Numpy

Scikit-learn

XGBoost

NLTK

Streamlit

O pandas on Snowflake atualmente tem compatibilidade limitada para certas APIs NumPy e Matplotlib, como implementação distribuída para np.where e interoperabilidade com df.plot. Converter o DataFrames pandas Snowpark via to_pandas() ao trabalhar com essas bibliotecas de terceiros evitará múltiplas chamadas de E/S.

Aqui está um exemplo com Altair para visualização e scikit-learn para aprendizado de máquina.

# Create a Snowpark session with a default connection.

session = Session.builder.create()

train = pd.read_snowflake('TITANIC')

train[['Pclass', 'Parch', 'Sex', 'Survived']].head()

Pclass Parch Sex Survived

0 3 0 male 0

1 1 0 female 1

2 3 0 female 1

3 1 0 female 1

4 3 0 male 0

import altair as alt

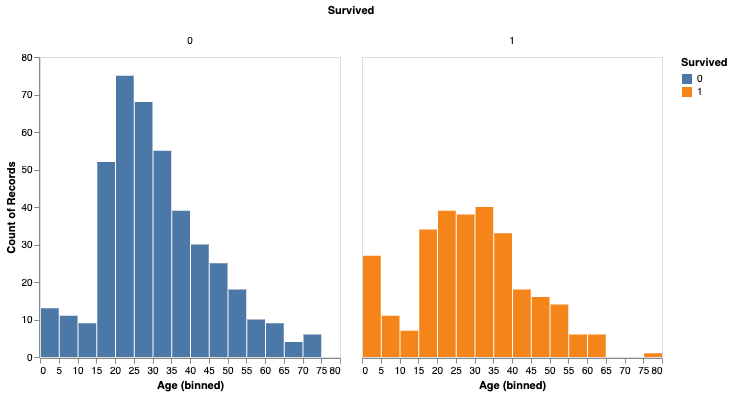

survived_per_age_plot = alt.Chart(train).mark_bar(

).encode(

x=alt.X('Age', bin=alt.Bin(maxbins=25)),

y='count()',

column='Survived:N',

color='Survived:N',

).properties(

width=300,

height=300

).configure_axis(

grid=False

)

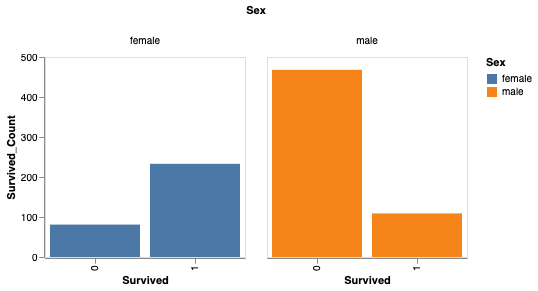

Você também pode analisar a sobrevivência com base no gênero.

# Perform groupby aggregation with Snowpark pandas

survived_per_gender = train.groupby(['Sex','Survived']).agg(count_survived=('Survived', 'count')).reset_index()

survived_per_gender_pandas = survived_per_gender

survived_per_gender_plot = alt.Chart(survived_per_gender).mark_bar().encode(

x='Survived:N',

y='Survived_Count',

color='Sex',

column='Sex'

).properties(

width=200,

height=200

).configure_axis(

grid=False

)

Agora você pode usar o scikit-learn para treinar um modelo simples.

feature_cols = ['Pclass', 'Parch']

X_pandas = train.loc[:, feature_cols]

y_pandas = train["Survived"]

from sklearn.linear_model import LogisticRegression

logreg = LogisticRegression()

logreg.fit(X_pandas, y_pandas)

y_pred_pandas = logreg.predict(X_pandas)

acc_eval = accuracy_score(y_pandas, y_pred_pandas)

Nota

Para obter um melhor desempenho, recomendamos a conversão para pandas DataFrames via to_pandas(), principalmente quando você estiver usando bibliotecas de aprendizado de máquina, como scikit-learn. No entanto, a função to_pandas() coleta todas as linhas, portanto, talvez seja melhor reduzir o tamanho do dataframe primeiro com sample(frac=0.1) ou head(10).

Bibliotecas não compatíveis¶

Ao usar bibliotecas de terceiros não compatíveis com um pandas on Snowflake DataFrame, recomendamos converter o pandas on Snowflake DataFrame em um pandas DataFrame chamando to_pandas() antes de passar o DataFrame para o método da biblioteca de terceiros.

Nota

Chamar to_pandas() retira seus dados do Snowflake e os coloca na memória, portanto, considere isso para grandes conjuntos de dados e casos de uso confidenciais.

Usar as funções de LLM do Snowflake Cortex com o pandas Snowpark¶

Você pode usar as funções de LLM do Snowflake Cortex por meio da função de aplicação do Snowpark pandas.

Você aplica a função com argumentos de palavras-chave especiais. Atualmente, as seguintes funções do Cortex são compatíveis:

O exemplo a seguir usa a função TRANSLATE em vários registros em um pandas DataFrame do Snowpark:

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from snowflake.cortex import Translate

content_df = pd.DataFrame(["good morning","hello", "goodbye"], columns=["content"])

result = content_df.apply(Translate, from_language="en", to_language="de")

result["content"]

Saída:

Guten Morgen

Hallo

Auf Wiedersehen

Name: content, dtype: object

O exemplo a seguir usa a função SENTIMENT (SNOWFLAKE.CORTEX) em uma tabela Snowflake chamada reviews:

from snowflake.cortex import Sentiment

s = pd.read_snowflake("reviews")["content"]

result = s.apply(Sentiment)

result

O exemplo a seguir usa o EXTRACT_ANSWER (SNOWFLAKE.CORTEX) para responder a uma pergunta:

from snowflake.cortex import ExtractAnswer

content = "The Snowflake company was co-founded by Thierry Cruanes, Marcin Zukowski, and Benoit Dageville in 2012 and is headquartered in Bozeman, Montana."

df = pd.DataFrame([content])

result = df.apply(ExtractAnswer, question="When was Snowflake founded?")

result[0][0][0]["answer"]

Saída:

'2012'

Nota

O pacote snowflake-ml-python deve ser instalado para usar as funções LLM do Cortex.

Limitações¶

pandas on Snowflake tem as seguintes limitações:

O pandas on Snowflake não oferece nenhuma garantia de compatibilidade com bibliotecas de terceiros OSS. A partir da versão 1.14.0a1, no entanto, o Snowpark pandas introduz compatibilidade limitada para NumPy, especificamente para o uso de

np.where. Para obter mais informações, consulte Interoperabilidade do NumPy.Ao chamar APIs da biblioteca de terceiros com um DataFrame do Snowpark pandas, a Snowflake recomenda que você converta o DataFrame do Snowpark pandas em um DataFrame do pandas chamando

to_pandas()antes de passar o DataFrame para a chamada de biblioteca de terceiros. Para obter mais informações, consulte Como usar o pandas on Snowflake com bibliotecas de terceiros.pandas on Snowflake não está integrado ao Snowpark ML. Ao usar o Snowpark ML, recomendamos que você converta o DataFrame do Snowpark pandas em um DataFrame do Snowpark usando to_snowpark() antes de chamar o Snowpark ML.

Os objetos

MultiIndexlentos não são suportados. QuandoMultiIndexé usado, ele retorna um objetoMultiIndexpandas nativo, que requer a extração de todos os dados para o lado do cliente.Nem todas as APIs do pandas têm uma implementação distribuída no pandas on Snowflake, embora algumas estejam sendo adicionadas. Para APIs não suportadas,

NotImplementedErroré lançado. Para obter informações sobre as APIs compatíveis, consulte a documentação de referência da API.O pandas on Snowflake oferece compatibilidade com qualquer versão de correção do pandas 2.2.

O Snowpark pandas não pode ser referenciado dentro da função:code:

applydo Snowpark pandas. Somente é possível usar pandas nativo dentro deapply.Veja a seguir um exemplo:

import modin.pandas as pd import pandas df.apply(lambda row: pandas.to_datetime(f"{row.date} {row.time}"), axis=1)

Solução de problemas¶

Esta seção descreve dicas de solução de problemas para usar o pandas on Snowflake.

Ao solucionar problemas, tente executar a mesma operação em um DataFrame do pandas nativo (ou uma amostra) para verificar se o mesmo erro persiste. Essa abordagem pode fornecer dicas sobre como corrigir sua consulta. Por exemplo:

df = pd.DataFrame({"a": [1,2,3], "b": ["x", "y", "z"]}) # Running this in Snowpark pandas throws an error df["A"].sum() # Convert a small sample of 10 rows to pandas DataFrame for testing pandas_df = df.head(10).to_pandas() # Run the same operation. KeyError indicates that the column reference is incorrect pandas_df["A"].sum() # Fix the column reference to get the Snowpark pandas query working df["a"].sum()

Se você tiver um notebook de longa execução aberto, observe que, por padrão, as sessões do Snowflake atingem o tempo limite após ficarem ociosas por 240 minutos (4 horas). Quando a sessão expira, se você executar consultas adicionais do pandas on Snowflake, a seguinte mensagem será exibida: «O token de autenticação expirou. O usuário deve se autenticar novamente». Neste ponto, você deve restabelecer a conexão com o Snowflake. Isso pode causar a perda de quaisquer variáveis de sessão não persistidas. Para obter mais informações sobre como configurar o parâmetro de tempo limite de inatividade da sessão, consulte Políticas de sessão.

Práticas recomendadas¶

Esta seção descreve as melhores práticas a serem seguidas ao usar o pandas on Snowflake.

Evite usar padrões de código iterativos, como loops

for,iterrowseiteritems. Padrões de código iterativos aumentam rapidamente a complexidade da consulta gerada. Deixe que o pandas on Snowflake, e não o código do cliente, realize a distribuição de dados e a paralelização de computação. Com relação a padrões de código iterativos, procure operações que possam ser realizadas em todo o DataFrame e use as operações correspondentes.

for i in np.arange(0, 50):

if i % 2 == 0:

data = pd.concat([data, pd.DataFrame({'A': i, 'B': i + 1}, index=[0])], ignore_index=True)

else:

data = pd.concat([data, pd.DataFrame({'A': i}, index=[0])], ignore_index=True)

# Instead of creating one DataFrame per row and concatenating them,

# try to directly create the DataFrame out of the data, like this:

data = pd.DataFrame(

{

"A": range(0, 50),

"B": [i + 1 if i % 2 == 0 else None for i in range(50)],

},

)

Evite chamar

apply,applymapetransform, que acabam sendo implementadas com UDFs ou UDTFs, que podem não ser tão eficientes quanto consultas SQL regulares. Se a função aplicada tiver uma operação equivalente em DataFrame ou série, use essa operação. Por exemplo, em vez dedf.groupby('col1').apply('sum'), chame diretamentedf.groupby('col1').sum().Chame

to_pandas()antes de passar o DataFrame ou série para uma biblioteca de terceiros. O pandas on Snowflake não fornece garantia de compatibilidade com bibliotecas de terceiros.Use uma tabela Snowflake regular materializada para evitar sobrecarga extra de E/S. O pandas on Snowflake funciona sobre um instantâneo de dados que funciona apenas para tabelas regulares. Para outros tipos, incluindo tabelas externas, exibições e tabelas Apache Iceberg™, uma tabela temporária é criada antes da captura do instantâneo, o que introduz uma sobrecarga extra de materialização.

O pandas on Snowflake fornece capacidade de clonagem rápida e zero-copy ao criar DataFrames de tabelas Snowflake usando

read_snowflake.Verifique novamente o tipo de resultado antes de prosseguir com outras operações e faça a conversão de tipo explícita com

astype, se necessário.Devido à capacidade limitada de inferência de tipo, se nenhuma dica de tipo for fornecida,

df.applyretornará resultados do tipo objeto (variante) mesmo que o resultado contenha todos os valores inteiros. Se outras operações exigirem que odtypesejaint, você pode fazer uma conversão de tipo explícita chamando o métodoastypepara corrigir o tipo de coluna antes de continuar.Evite chamar APIs que exijam avaliação e materialização, a menos que seja necessário.

APIs que não retornam

SeriesouDataframeexigem avaliação e materialização adiantadas para produzir o resultado no tipo correto. O mesmo vale para métodos de plotagem. Reduza as chamadas para aquelas APIs para minimizar avaliações e materializações desnecessárias.Evite chamar

np.where(<cond>, <escalar>, n)em grandes conjuntos de dados. O<escalar>será transmitido para um DataFrame do tamanho de<cond>, o que pode ser lento.Ao trabalhar com consultas construídas iterativamente,

df.cache_resultpode ser usado para materializar resultados intermediários e reduzir a avaliação repetida, melhorar a latência e reduzir a complexidade da consulta geral. Por exemplo:df = pd.read_snowflake('pandas_test') df2 = pd.pivot_table(df, index='index_col', columns='pivot_col') # expensive operation df3 = df.merge(df2) df4 = df3.where(df2 == True)

No exemplo acima, a consulta para produzir

df2é cara para computar e é reutilizada na criação dedf3edf4. Materializandodf2em uma tabela temporária (fazendo operações subsequentes envolvendo uma varredura de tabeladf2em vez de um pivô) pode reduzir a latência geral do bloco de código:df = pd.read_snowflake('pandas_test') df2 = pd.pivot_table(df, index='index_col', columns='pivot_col') # expensive operation df2.cache_result(inplace=True) df3 = df.merge(df2) df4 = df3.where(df2 == True)

Exemplos¶

Aqui está um exemplo de código com operações do pandas. Começamos com um DataFrame Snowpark pandas chamado pandas_test, que contém três colunas: COL_STR, COL_FLOAT e COL_INT. Para exibir o notebook associado a esses exemplos, consulte os exemplos do pandas on Snowflake no repositório Snowflake-Labs.

import modin.pandas as pd

import snowflake.snowpark.modin.plugin

from snowflake.snowpark import Session

CONNECTION_PARAMETERS = {

'account': '<myaccount>',

'user': '<myuser>',

'password': '<mypassword>',

'role': '<myrole>',

'database': '<mydatabase>',

'schema': '<myschema>',

'warehouse': '<mywarehouse>',

}

session = Session.builder.configs(CONNECTION_PARAMETERS).create()

df = pd.DataFrame([['a', 2.1, 1],['b', 4.2, 2],['c', 6.3, None]], columns=["COL_STR", "COL_FLOAT", "COL_INT"])

df

COL_STR COL_FLOAT COL_INT

0 a 2.1 1.0

1 b 4.2 2.0

2 c 6.3 NaN

Salvamos o DataFrame como uma tabela do Snowflake chamada pandas_test, que usaremos em todos os nossos exemplos.

df.to_snowflake("pandas_test", if_exists='replace',index=False)

Em seguida, criamos um DataFrame a partir da tabela Snowflake. Nós descartamos a coluna COL_INT e então salvamos o resultado de volta no Snowflake com uma coluna chamada row_position.

# Create a DataFrame out of a Snowflake table.

df = pd.read_snowflake('pandas_test')

df.shape

(3, 3)

df.head(2)

COL_STR COL_FLOAT COL_INT

0 a 2.1 1

1 b 4.2 2

df.dropna(subset=["COL_FLOAT"], inplace=True)

df

COL_STR COL_FLOAT COL_INT

0 a 2.1 1

1 c 6.3 2

df.shape

(2, 3)

df.dtypes

COL_STR object

COL_FLOAT float64

COL_INT int64

dtype: object

# Save the result back to Snowflake with a row_pos column.

df.reset_index(drop=True).to_snowflake('pandas_test2', if_exists='replace', index=True, index_label=['row_pos'])

O resultado é uma nova tabela, pandas_test2, que se parece com isto:

row_pos COL_STR COL_FLOAT COL_INT

0 1 a 2.0 1

1 2 b 4.0 2

IO (leitura e gravação)¶

# Reading and writing to Snowflake

df = pd.DataFrame({"fruit": ["apple", "orange"], "size": [3.4, 5.4], "weight": [1.4, 3.2]})

df.to_snowflake("test_table", if_exists="replace", index=False )

df_table = pd.read_snowflake("test_table")

# Generate sample CSV file

with open("data.csv", "w") as f:

f.write('fruit,size,weight\napple,3.4,1.4\norange,5.4,3.2')

# Read from local CSV file

df_csv = pd.read_csv("data.csv")

# Generate sample JSON file

with open("data.json", "w") as f:

f.write('{"fruit":"apple", "size":3.4, "weight":1.4},{"fruit":"orange", "size":5.4, "weight":3.2}')

# Read from local JSON file

df_json = pd.read_json('data.json')

# Upload data.json and data.csv to Snowflake stage named @TEST_STAGE

# Read CSV and JSON file from stage

df_csv = pd.read_csv('@TEST_STAGE/data.csv')

df_json = pd.read_json('@TEST_STAGE/data.json')

Para obter mais informações, consulte Entrada/Saída.

Indexação¶

df = pd.DataFrame({"a": [1,2,3], "b": ["x", "y", "z"]})

df.columns

Index(['a', 'b'], dtype='object')

df.index

Index([0, 1, 2], dtype='int8')

df["a"]

0 1

1 2

2 3

Name: a, dtype: int8

df["b"]

0 x

1 y

2 z

Name: b, dtype: object

df.iloc[0,1]

'x'

df.loc[df["a"] > 2]

a b

2 3 z

df.columns = ["c", "d"]

df

c d

0 1 x

1 2 y

2 3 z

df = df.set_index("c")

df

d

c

1 x

2 y

3 z

df.rename(columns={"d": "renamed"})

renamed

c

1 x

2 y

3 z

Valores ausentes¶

import numpy as np

df = pd.DataFrame([[np.nan, 2, np.nan, 0],

[3, 4, np.nan, 1],

[np.nan, np.nan, np.nan, np.nan],

[np.nan, 3, np.nan, 4]],

columns=list("ABCD"))

df

A B C D

0 NaN 2.0 NaN 0.0

1 3.0 4.0 NaN 1.0

2 NaN NaN NaN NaN

3 NaN 3.0 NaN 4.0

df.isna()

A B C D

0 True False True False

1 False False True False

2 True True True True

3 True False True False

df.fillna(0)

A B C D

0 0.0 2.0 0.0 0.0

1 3.0 4.0 0.0 1.0

2 0.0 0.0 0.0 0.0

3 0.0 3.0 0.0 4.0

df.dropna(how="all")

A B C D

0 NaN 2.0 NaN 0.0

1 3.0 4.0 NaN 1.0

3 NaN 3.0 NaN 4.0

Conversão de tipo¶

df = pd.DataFrame({"int": [1,2,3], "str": ["4", "5", "6"]})

df

int str

0 1 4

1 2 5

2 3 6

df_float = df.astype(float)

df_float

int str

0 1.0 4.0

1 2.0 5.0

2 3.0 6.0

df_float.dtypes

int float64

str float64

dtype: object

pd.to_numeric(df.str)

0 4.0

1 5.0

2 6.0

Name: str, dtype: float64

df = pd.DataFrame({'year': [2015, 2016],

'month': [2, 3],

'day': [4, 5]})

pd.to_datetime(df)

0 2015-02-04

1 2016-03-05

dtype: datetime64[ns]

Operações binárias¶

df_1 = pd.DataFrame([[1,2,3],[4,5,6]])

df_2 = pd.DataFrame([[6,7,8]])

df_1.add(df_2)

0 1 2

0 7.0 9.0 11.0

1 NaN NaN NaN

s1 = pd.Series([1, 2, 3])

s2 = pd.Series([2, 2, 2])

s1 + s2

0 3

1 4

2 5

dtype: int64

df = pd.DataFrame({"A": [1,2,3], "B": [4,5,6]})

df["A+B"] = df["A"] + df["B"]

df

A B A+B

0 1 4 5

1 2 5 7

2 3 6 9

Agregação¶

df = pd.DataFrame([[1, 2, 3],

[4, 5, 6],

[7, 8, 9],

[np.nan, np.nan, np.nan]],

columns=['A', 'B', 'C'])

df.agg(['sum', 'min'])

A B C

sum 12.0 15.0 18.0

min 1.0 2.0 3.0

df.median()

A 4.0

B 5.0

C 6.0

dtype: float64

Merge¶

df1 = pd.DataFrame({'lkey': ['foo', 'bar', 'baz', 'foo'],

'value': [1, 2, 3, 5]})

df1

lkey value

0 foo 1

1 bar 2

2 baz 3

3 foo 5

df2 = pd.DataFrame({'rkey': ['foo', 'bar', 'baz', 'foo'],

'value': [5, 6, 7, 8]})

df2

rkey value

0 foo 5

1 bar 6

2 baz 7

3 foo 8

df1.merge(df2, left_on='lkey', right_on='rkey')

lkey value_x rkey value_y

0 foo 1 foo 5

1 foo 1 foo 8

2 bar 2 bar 6

3 baz 3 baz 7

4 foo 5 foo 5

5 foo 5 foo 8

df = pd.DataFrame({'key': ['K0', 'K1', 'K2', 'K3', 'K4', 'K5'],

'A': ['A0', 'A1', 'A2', 'A3', 'A4', 'A5']})

df

key A

0 K0 A0

1 K1 A1

2 K2 A2

3 K3 A3

4 K4 A4

5 K5 A5

other = pd.DataFrame({'key': ['K0', 'K1', 'K2'],

'B': ['B0', 'B1', 'B2']})

df.join(other, lsuffix='_caller', rsuffix='_other')

key_caller A key_other B

0 K0 A0 K0 B0

1 K1 A1 K1 B1

2 K2 A2 K2 B2

3 K3 A3 None None

4 K4 A4 None None

5 K5 A5 None None

Groupby¶

df = pd.DataFrame({'Animal': ['Falcon', 'Falcon','Parrot', 'Parrot'],

'Max Speed': [380., 370., 24., 26.]})

df

Animal Max Speed

0 Falcon 380.0

1 Falcon 370.0

2 Parrot 24.0

3 Parrot 26.0

df.groupby(['Animal']).mean()

Max Speed

Animal

Falcon 375.0

Parrot 25.0

Para obter mais informações, consulte GroupBy.

Pivô¶

df = pd.DataFrame({"A": ["foo", "foo", "foo", "foo", "foo",

"bar", "bar", "bar", "bar"],

"B": ["one", "one", "one", "two", "two",

"one", "one", "two", "two"],

"C": ["small", "large", "large", "small",

"small", "large", "small", "small",

"large"],

"D": [1, 2, 2, 3, 3, 4, 5, 6, 7],

"E": [2, 4, 5, 5, 6, 6, 8, 9, 9]})

df

A B C D E

0 foo one small 1 2

1 foo one large 2 4

2 foo one large 2 5

3 foo two small 3 5

4 foo two small 3 6

5 bar one large 4 6

6 bar one small 5 8

7 bar two small 6 9

8 bar two large 7 9

pd.pivot_table(df, values='D', index=['A', 'B'],

columns=['C'], aggfunc="sum")

C large small

A B

bar one 4.0 5

two 7.0 6

foo one 4.0 1

two NaN 6

df = pd.DataFrame({'foo': ['one', 'one', 'one', 'two', 'two', 'two'],

'bar': ['A', 'B', 'C', 'A', 'B', 'C'],

'baz': [1, 2, 3, 4, 5, 6],

'zoo': ['x', 'y', 'z', 'q', 'w', 't']})

df

foo bar baz zoo

0 one A 1 x

1 one B 2 y

2 one C 3 z

3 two A 4 q

4 two B 5 w

5 two C 6 t