Actualiser automatiquement les tables externes pour Amazon S3¶

Vous pouvez créer des tables externes et actualiser automatiquement les métadonnées des tables externes à l’aide des notifications Amazon SQS (Service de file d’attente simple) pour un compartiment S3. Cette opération synchronise les métadonnées avec le dernier ensemble de fichiers associés de la zone de préparation et du chemin externes :

Les nouveaux fichiers dans le chemin sont ajoutés aux métadonnées de la table.

Les modifications apportées aux fichiers dans le chemin sont mises à jour dans les métadonnées de la table.

Les fichiers qui ne figurent plus dans le chemin sont supprimés des métadonnées de la table.

Conditions préalables¶

Avant de poursuivre, assurez-vous de remplir les conditions préalables suivantes :

Cette fonctionnalité est limitée aux comptes Snowflake sur Amazon Web Services (AWS).

Pour effectuer les tâches décrites dans cette rubrique, vous devez utiliser un rôle disposant des privilèges CREATE STAGE et CREATE EXTERNAL TABLE sur un schéma.

De plus, vous devez avoir un accès administratif à AWS. Si vous n’êtes pas un administrateur AWS, demandez à votre administrateur AWS de suivre les étapes requises pour configurer les notifications d’événements AWS :

Snowflake recommande de n’envoyer que des événements pris en charge pour les tables externes afin de réduire les coûts, le bruit des événements et la latence.

Les tables externes ne prennent pas en charge le versionnage du stockage (versionnage S3, versionnage d’objets dans Google Cloud Storage ou versionnage pour Azure Storage).

Limitations de l’actualisation automatique des tables externes via Amazon SQS¶

Clients Virtual Private Snowflake (VPS) et AWS PrivateLink : Amazon SQS n’est actuellement pas pris en charge par AWS en tant que VPCpoint de terminaison. Bien que les services AWS au sein d’un VPC (y compris VPS) puissent communiquer avec SQS, ce trafic ne fait pas partie du VPC et n’est donc pas protégé par le VPC.

Les notifications SQS informent Snowflake lorsque de nouveaux fichiers arrivent dans les compartiments S3 surveillés et sont prêts à être chargés. Les notifications SQS contiennent l’événement S3 et une liste des noms de fichiers. Elles n’incluent pas les données réelles dans les fichiers.

Prise en charge de la plateforme Cloud¶

Le déclenchement des actualisations de métadonnées externes automatiques à l’aide de messages d’événements S3 est pris en charge par les comptes Snowflake hébergés sur AWS uniquement.

Configuration de l’accès sécurisé au stockage Cloud¶

Important

Si vous avez déjà configuré un accès sécurisé au compartiment S3 qui stocke vos fichiers de données, ignorez cette section et passez à Créer une nouvelle notification d’événement S3 ou utiliser une notification existante.

Cette section explique comment utiliser des intégrations de stockage pour permettre à Snowflake de lire et d’écrire des données dans un compartiment Amazon S3 référencé dans une zone de préparation externe (c’est-à-dire S3). Les intégrations sont des objets Snowflake de première classe nommés, qui évitent de transmettre des informations d’identification explicites de fournisseur Cloud, telles que des clés secrètes ou des jetons d’accès. Les objets d’intégration stockent un ID d’utilisateur de gestion des identités et des accès (IAM) AWS. Un administrateur de votre organisation accorde les autorisations utilisateur IAM de l’intégration dans le compte AWS.

Une intégration peut également répertorier des compartiments (et des chemins facultatifs) qui limitent les emplacements que les utilisateurs peuvent spécifier lors de la création de zones de préparation externes utilisant l’intégration.

Note

Pour terminer les instructions de cette section, des autorisations sont nécessaires dans AWS pour créer et gérer des stratégies et des rôles IAM. Si vous n’êtes pas un administrateur AWS, demandez à votre administrateur AWS d’effectuer ces tâches.

Notez qu’actuellement, l’accès au stockage S3 dans les régions gouvernementales à l’aide d’une intégration de stockage est limité aux comptes Snowflake hébergés sur AWS dans la même région gouvernementale. L’accès à votre stockage S3 à partir d’un compte hébergé en dehors de la région gouvernementale à l’aide d’identifiants directs est pris en charge.

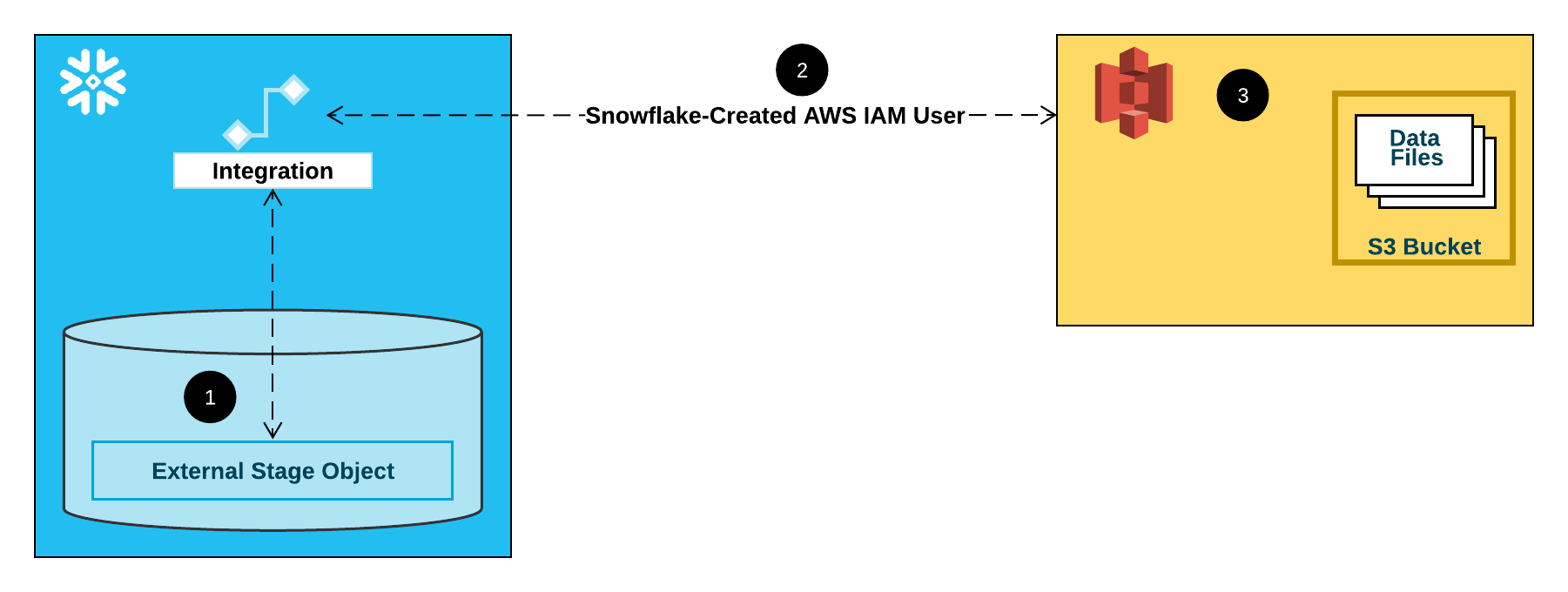

Le diagramme suivant illustre le flux d’intégration d’une zone de préparation S3 :

Une zone de préparation externe (c.-à-d S3) fait référence à un objet d’intégration de stockage dans sa définition.

Snowflake associe automatiquement l’intégration de stockage à un utilisateur IAM S3 créé pour votre compte. Snowflake crée un seul utilisateur IAM référencé par toutes les intégrations de stockage S3 de votre compte Snowflake.

Un administrateur AWS de votre organisation accorde des autorisations à l’utilisateur IAM pour accéder au compartiment référencé dans la définition de la zone de préparation. Notez que de nombreux objets de zones de préparation externes peuvent référencer différents compartiments et chemins et utiliser la même intégration de stockage pour l’authentification.

Lorsqu’un utilisateur charge ou décharge des données depuis ou vers une zone de préparation, Snowflake vérifie les autorisations accordées à l’utilisateur IAM sur le compartiment avant d’autoriser ou de refuser l’accès.

Important

Snowflake vous recommande vivement de configurer l’accès sécurisé afin de ne pas avoir à fournir d’identifiants de connexion IAM lorsque vous accédez à Cloud Storage. Pour plus d’options d’accès au stockage, consultez Configuration de l’accès sécurisé à Amazon S3.

Dans cette section :

Étape 1 : Configurer des autorisations d’accès pour le compartiment S3¶

Conditions de contrôle d’accès AWS¶

Snowflake requiert les autorisations suivantes sur un compartiment S3 et un dossier pour accéder aux fichiers dans le dossier (et tout sous-dossier) :

s3:GetBucketLocations3:GetObjects3:GetObjectVersions3:ListBucket

Comme bonne pratique, Snowflake recommande la création d’une politique IAM pour l’accès de Snowflake au compartiment S3. Vous pouvez alors joindre la politique au rôle, et utiliser les identifiants de sécurité générés par AWS pour que le rôle puisse accéder aux fichiers dans le compartiment.

Créer une politique IAM¶

Suivez les étapes suivantes pour configurer les autorisations d’accès pour que Snowflake puisse accéder à votre compartiment S3 :

Connectez-vous à la console de gestion AWS.

Depuis le tableau de bord d’accueil, recherchez et sélectionnez IAM.

Dans le volet de navigation de gauche, sélectionnez Account settings.

Dans Security Token Service (STS), dans la liste Endpoints, recherchez la région Snowflake dans laquelle se trouve votre compte.

Si STS status est inactif, placez la bascule sur Active.

Dans le volet de navigation de gauche, sélectionnez Policies.

Sélectionnez Create Policy.

Pour Policy editor, sélectionnez JSON.

Pour ajouter un document de politique qui permet à Snowflake d’accéder au compartiment et au dossier S3, copiez et collez le bloc de syntaxe suivant dans l’éditeur de politiques :

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:GetObjectVersion" ], "Resource": "arn:aws:s3:::<bucket>/<prefix>/*" }, { "Effect": "Allow", "Action": [ "s3:ListBucket", "s3:GetBucketLocation" ], "Resource": "arn:aws:s3:::<bucket>", "Condition": { "StringLike": { "s3:prefix": [ "<prefix>/*" ] } } } ] }

Note

Ce document de politique (au format JSON) fournit à Snowflake les autorisations requises pour charger ou décharger des données à l’aide d’un seul chemin de dossier et de compartiment.

Les Amazon Resource Names (ARN) pour les compartiments dans des régions gouvernementales ont un préfixe

arn:aws-us-gov:s3:::.La définition de la condition

"s3:prefix":sur["*"]ou["<chemin>/*"]donne accès à tous les préfixes dans le compartiment spécifié ou le chemin dans le compartiment, respectivement.Les politiques AWS prennent en charge une variété de cas d’utilisation de sécurité différents.

Remplacez le

bucketet leprefixpar votre nom de compartiment actuel et le préfixe du chemin d’accès au dossier.Sélectionnez Next.

Saisissez un Policy name (par exemple,

snowflake_access) et une Description facultative.Sélectionnez Create policy.

Étape 2 : Créer le rôle IAM dans AWS¶

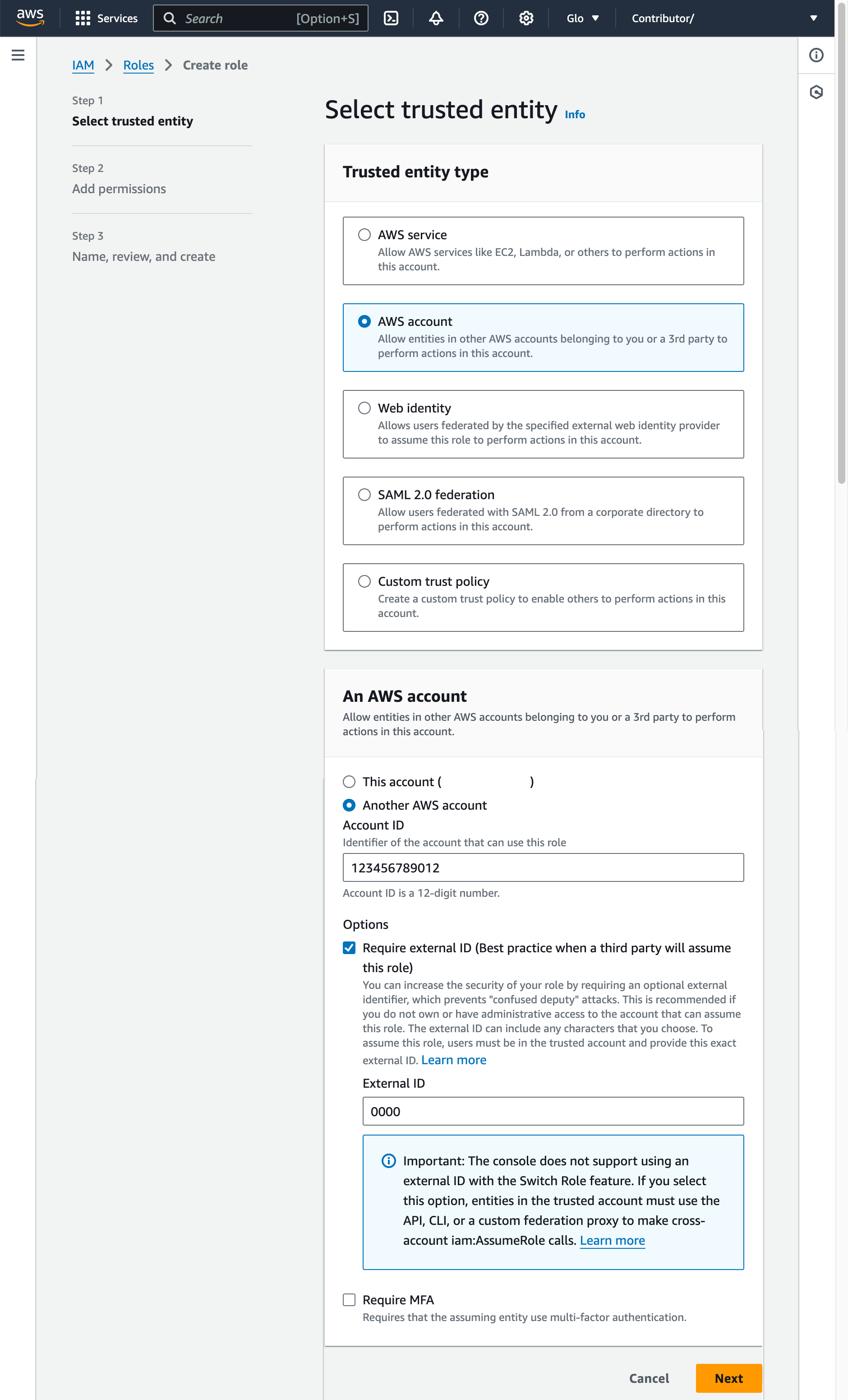

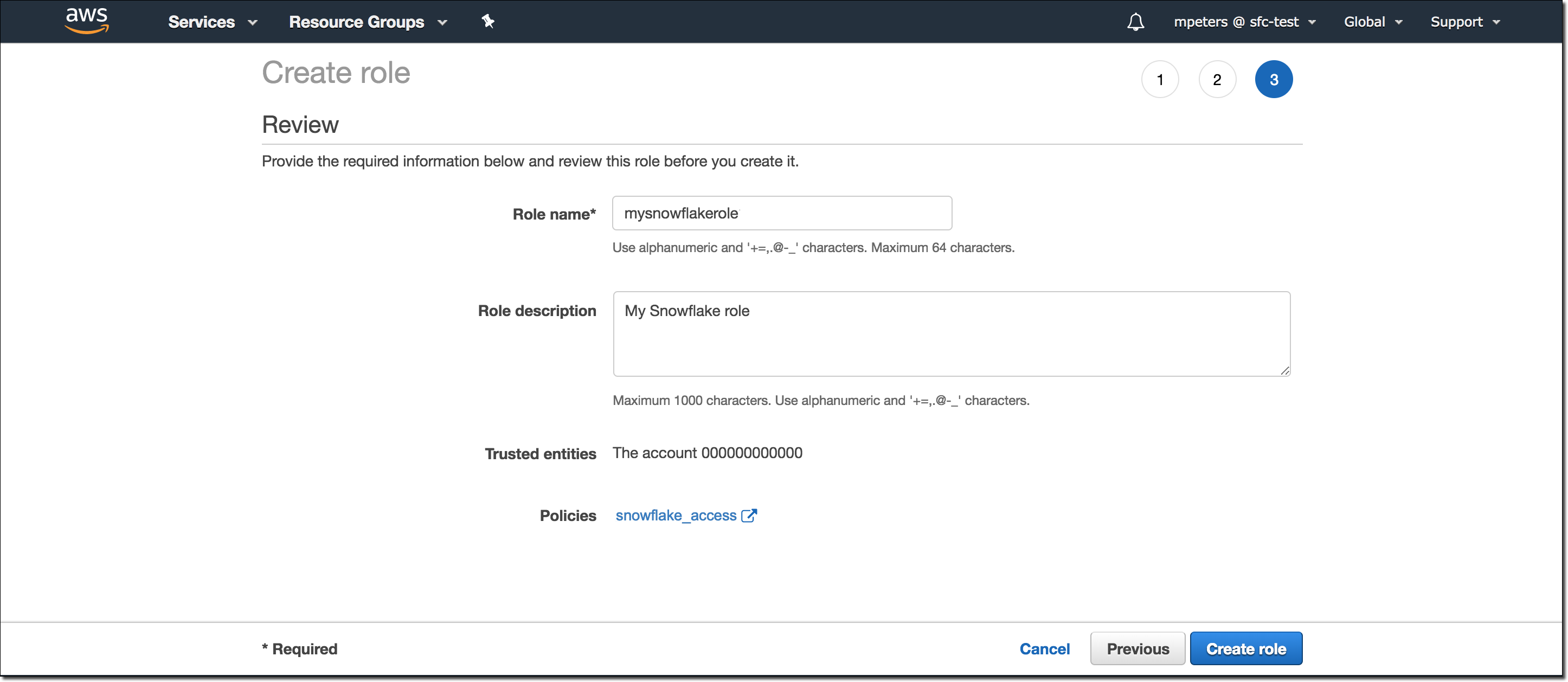

Pour configurer les autorisations d’accès à Snowflake dans la Console de gestion AWS, procédez comme suit :

Dans le volet de navigation gauche du tableau de bord de la gestion des identités et des accès (IAM), sélectionnez Roles.

Sélectionnez Create role.

Sélectionnez AWS account comme type d’entité de confiance.

Sélectionnez Another AWS account

Dans le champ Account ID saisissez votre propre ID de compte AWS temporaire. Plus tard, vous modifierez la relation de confiance et accorderez l’accès à Snowflake.

Sélectionnez l’option Require external ID. Un ID externe est utilisé pour accorder l’accès à vos ressources AWS (telles que des compartiments S3) à un tiers comme Snowflake.

Saisissez un ID de type caractère générique tel que

0000. À une étape ultérieure, vous modifierez la relation de confiance de votre rôle IAM et spécifierez l’ID externe de votre intégration de stockage.Sélectionnez Next.

Sélectionnez la politique que vous avez créée dans Étape 1 : Configuration des autorisations d’accès au compartiment S3 (dans ce sujet).

Sélectionnez Next.

Saisissez un nom et une description pour le rôle, puis sélectionnez Create role.

Vous avez maintenant créé une stratégie IAM pour un compartiment, créé un rôle IAM et associé la stratégie au rôle.

Sur la page de synthèse du rôle, recherchez et enregistrez la valeur Role ARN. Dans l’étape suivante, vous créerez une intégration Snowflake qui fait référence à ce rôle.

Note

Snowflake met en cache les identifiants temporaires pour une période qui ne peut excéder le délai d’expiration de 60 minutes. Si vous révoquez l’accès à partir de Snowflake, les utilisateurs pourraient être en mesure de répertorier les fichiers et d’accéder à des données à partir de l’emplacement de stockage dans le Cloud jusqu’à l’expiration du cache.

Étape 3 : Création d’une intégration de stockage Coud dans Snowflake¶

Créez une intégration de stockage à l’aide de la commande CREATE STORAGE INTEGRATION. Une intégration de stockage est un objet Snowflake qui stocke un utilisateur généré pour la gestion de l’identité et de l’accès (IAM) pour votre stockage Cloud S3, ainsi qu’un ensemble facultatif d’emplacements de stockage autorisés ou bloqués (c’est-à-dire des compartiments). Les administrateurs de fournisseur de Cloud de votre entreprise accordent des autorisations sur les emplacements de stockage à l’utilisateur généré. Cette option permet aux utilisateurs d’éviter de fournir des informations d’identification lors de la création de zones de préparation ou du chargement de données.

Une seule intégration de stockage peut prendre en charge plusieurs zones de préparation externe (c’est-à-dire S3). L’URL dans la définition de zone de préparation doit correspondre aux compartiments S3 (et aux chemins facultatifs) spécifiés pour le paramètre STORAGE_ALLOWED_LOCATIONS.

Note

Seuls les administrateurs de compte (utilisateurs dotés du rôle ACCOUNTADMIN) ou un rôle disposant du privilège global CREATE INTEGRATION peuvent exécuter cette commande SQL.

CREATE STORAGE INTEGRATION <integration_name>

TYPE = EXTERNAL_STAGE

STORAGE_PROVIDER = 'S3'

ENABLED = TRUE

STORAGE_AWS_ROLE_ARN = '<iam_role>'

STORAGE_ALLOWED_LOCATIONS = ('<protocol>://<bucket>/<path>/', '<protocol>://<bucket>/<path>/')

[ STORAGE_BLOCKED_LOCATIONS = ('<protocol>://<bucket>/<path>/', '<protocol>://<bucket>/<path>/') ]

Où :

integration_nameest le nom de la nouvelle intégration.iam_roleest le nom Amazon Resource Name (ARN) du rôle que vous avez créé à Étape 2 : Création du rôle IAM dans AWS (dans ce sujet).protocolest l’un des éléments suivants :s3fait référence au stockage S3 dans les régions AWS publiques hors de Chine.s3chinafait référence au stockage S3 dans les régions AWS publiques en Chine.s3govfait référence au stockage S3 dans les régions gouvernementales.

bucketest le nom d’un compartiment S3 qui stocke vos fichiers de données (par exemple,mybucket). Les paramètres STORAGE_ALLOWED_LOCATIONS requis et STORAGE_BLOCKED_LOCATIONS facultatif limitent ou bloquent l’accès à ces compartiments, respectivement, lors de la création ou de la modification de zones de préparation faisant référence à cette intégration.pathest un chemin facultatif qui peut être utilisé pour fournir un contrôle granulaire sur les objets du compartiment.

L’exemple suivant crée une intégration qui autorise l’accès à tous les compartiments du compte, mais bloque l’accès aux dossiers sensitivedata définis.

Les zones de préparation externes supplémentaires qui utilisent également cette intégration peuvent faire référence aux compartiments et aux chemins autorisés :

CREATE STORAGE INTEGRATION s3_int

TYPE = EXTERNAL_STAGE

STORAGE_PROVIDER = 'S3'

ENABLED = TRUE

STORAGE_AWS_ROLE_ARN = 'arn:aws:iam::001234567890:role/myrole'

STORAGE_ALLOWED_LOCATIONS = ('*')

STORAGE_BLOCKED_LOCATIONS = ('s3://mybucket1/mypath1/sensitivedata/', 's3://mybucket2/mypath2/sensitivedata/');

Note

En option, utilisez le paramètre STORAGE_AWS_EXTERNAL_ID pour spécifier votre propre ID externe. Vous pouvez sélectionner cette option pour utiliser le même ID externe sur plusieurs volumes externes et/ou intégrations de stockage.

Étape 4 : Récupérer l’utilisateur AWSIAM de votre compte Snowflake¶

Pour récupérer l’ARN de l’utilisateur IAM automatiquement créé pour votre compte Snowflake, utilisez DESCRIBE INTEGRATION.

DESC INTEGRATION <integration_name>;

Où :

integration_nameest le nom de l’intégration créée à l”étape 3 : Création d’une intégration Cloud Storage dans Snowflake (ce chapitre).

Par exemple :

DESC INTEGRATION s3_int;

+---------------------------+---------------+--------------------------------------------------------------------------------+------------------+ | property | property_type | property_value | property_default | +---------------------------+---------------+--------------------------------------------------------------------------------+------------------| | ENABLED | Boolean | true | false | | STORAGE_ALLOWED_LOCATIONS | List | s3://mybucket1/mypath1/,s3://mybucket2/mypath2/ | [] | | STORAGE_BLOCKED_LOCATIONS | List | s3://mybucket1/mypath1/sensitivedata/,s3://mybucket2/mypath2/sensitivedata/ | [] | | STORAGE_AWS_IAM_USER_ARN | String | arn:aws:iam::123456789001:user/abc1-b-self1234 | | | STORAGE_AWS_ROLE_ARN | String | arn:aws:iam::001234567890:role/myrole | | | STORAGE_AWS_EXTERNAL_ID | String | MYACCOUNT_SFCRole=2_a123456/s0aBCDEfGHIJklmNoPq= | | +---------------------------+---------------+--------------------------------------------------------------------------------+------------------+

Enregistrez les valeurs des propriétés suivantes :

Propriété

Description

STORAGE_AWS_IAM_USER_ARNUtilisateur IAM AWS créé pour votre compte Snowflake, par exemple,

arn:aws:iam::123456789001:user/abc1-b-self1234. Snowflake provisionne un seul utilisateur IAM pour l’intégralité de votre compte Snowflake. Toutes les intégrations de stockage S3 de votre compte utilisent cet utilisateur IAM.STORAGE_AWS_EXTERNAL_IDID externe que Snowflake utilise pour établir une relation de confiance avec AWS. Si vous n’avez pas spécifié d’ID externe (

STORAGE_AWS_EXTERNAL_ID) lorsque vous avez créé l’intégration de stockage, Snowflake génère un ID à utiliser.Vous fournirez ces valeurs à la section suivante.

Étape 5 : octroyer à l’utilisateur IAM des autorisations pour accéder à des objets de compartiment¶

Les instructions étape par étape suivantes décrivent comment configurer les permissions d’accès IAM pour Snowflake dans votre console de gestion AWS de sorte que vous puissiez utiliser un compartiment S3 pour charger et décharger les données :

Connectez-vous à la console de gestion AWS.

Sélectionnez IAM.

Dans le volet de navigation de gauche, sélectionnez Roles.

Sélectionnez le rôle que vous avez créé dans l’étape 2 : Création du rôle IAM dans AWS (dans ce sujet).

Sélectionnez l’onglet Trust relationships.

Sélectionnez Edit trust policy.

Modifiez le document de politique avec les valeurs de sortie DESCSTORAGEINTEGRATION que vous avez enregistrées dans Étape 4 : Récupération de l’utilisateur AWSIAM de votre compte Snowflake (dans ce sujet) :

Document de politique pour le rôle IAM

{ "Version": "2012-10-17", "Statement": [ { "Sid": "", "Effect": "Allow", "Principal": { "AWS": "<snowflake_user_arn>" }, "Action": "sts:AssumeRole", "Condition": { "StringEquals": { "sts:ExternalId": "<snowflake_external_id>" } } } ] }

Où :

snowflake_user_arnest la valeur STORAGE_AWS_IAM_USER_ARN que vous avez enregistrée.snowflake_external_idest la valeur STORAGE_AWS_EXTERNAL_ID que vous avez enregistrée.Dans cet exemple, la valeur

snowflake_external_idestMYACCOUNT_SFCRole=2_a123456/s0aBCDEfGHIJklmNoPq=.Note

Pour des raisons de sécurité, si vous créez une nouvelle intégration de stockage (ou si vous recréez une intégration de stockage existante à l’aide de la syntaxe CREATE OR REPLACE STORAGE INTEGRATION) sans spécifier d’ID externe, la nouvelle intégration a un ID externe différent et ne peut donc résoudre la relation de confiance, sauf si vous mettez à jour la politique de confiance.

Sélectionnez Update policy pour enregistrer vos modifications.

Note

Snowflake met en cache les identifiants temporaires pour une période qui ne peut excéder le délai d’expiration de 60 minutes. Si vous révoquez l’accès à partir de Snowflake, les utilisateurs pourraient être en mesure de répertorier les fichiers et de charger des données à partir de l’emplacement de stockage dans le Cloud jusqu’à l’expiration du cache.

Note

Vous pouvez utiliser la fonction SYSTEM$VALIDATE_STORAGE_INTEGRATION pour valider la configuration de votre intégration de stockage.

Créer une nouvelle notification d’événement S3 ou utiliser une notification existante¶

Avant de poursuivre, déterminez si une notification d’événement S3 existe pour le chemin cible (ou le préfixe, dans la terminologie AWS) dans votre compartiment S3 où se trouvent vos fichiers de données. Les règles AWS interdisent la création de notifications conflictuelles pour le même chemin.

Vous disposez de deux options pour automatiser l’actualisation des métadonnées de tables externes à l’aide d’Amazon SQS :

- Option 1 : Création d’une nouvelle notification d’événement S3

C’est l’option la plus courante. Créez une notification d’événement pour le chemin cible dans votre compartiment S3. La notification d’événement informe Snowflake via une file d’attente SQS lorsque des fichiers nouveaux, supprimés ou modifiés dans le chemin d’accès nécessitent un rafraîchissement des métadonnées de la table externe.

Important

S’il existe une notification d’événement en conflit pour votre compartiment S3, utilisez l’option 2 à la place.

Pour des instructions étape par étape, consultez Option 1 : Création d’une nouvelle notification d’événement S3.

- Option 2 : Configuration d’Amazon SNS

Si vous disposez d’une notification d’événement existante :** Configurez Amazon Simple Notification Service (SNS) en tant que diffuseur pour partager les notifications d’un chemin donné avec plusieurs points de terminaison (ou « abonnés », par exemple des files d’attente SQS ou des charges de travail AWS Lambda), en incluant la file d’attente SQS de Snowflake pour l’automatisation de l’actualisation des tables externes. Une notification d’événement S3 publiée par SNS informe Snowflake des changements de fichiers dans le chemin via une file d’attente SQS.

Pour des instructions étape par étape, consultez Option 2 : Configuration d’Amazon SNS plus loin dans cette rubrique.

Option 1 : Création d’une nouvelle notification d’événement S3¶

Cette section fournit des instructions étape par étape pour l’option la plus courante pour actualiser automatiquement les métadonnées des tables externes à l’aide de notifications Amazon Simple Queue Service (SQS) pour un compartiment S3. Les étapes vous montrent comment créer une notification d’événement pour le chemin cible (ou préfixe, dans la terminologie AWS) dans votre compartiment S3 dans lequel vos fichiers de données sont stockés.

Important

S’il existe une notification d’événement en conflit pour votre compartiment S3, utilisez plutôt Option 2 : Configuration d’Amazon SNS plus loin dans cette rubrique. Les règles AWS interdisent la création de notifications en conflit pour le même chemin cible.

Étape 1 (facultative) : Créer une zone de préparation¶

Créez une zone de préparation externe qui fait référence à votre compartiment S3 à l’aide de la commande CREATE STAGE. Snowflake lit vos fichiers de données en zone de préparation dans les métadonnées de la table externe. Vous pouvez aussi utiliser une zone de préparation externe.

Note

Pour configurer l’accès sécurisé à l’emplacement de stockage Cloud, consultez Configuration de l’accès sécurisé au stockage Cloud (dans cette rubrique).

Pour faire référence à une intégration de stockage dans l’instruction CREATE STAGE, le rôle doit avoir le privilège USAGE sur l’objet d’intégration de stockage.

L’exemple suivant crée une zone de préparation nommée mystage dans le schéma actif de la session utilisateur. L’URL de stockage Cloud inclut le chemin files. La zone de préparation fait référence à une intégration de stockage nommée my_storage_int.

USE SCHEMA mydb.public; CREATE STAGE mystage URL = 's3://mybucket/files' STORAGE_INTEGRATION = my_storage_int;

Étape 2 : Création d’une table externe¶

Créez une table externe à l’aide de la commande CREATE EXTERNAL TABLE. Par exemple, créez une table externe dans le schéma mydb.public qui lit les données JSON à partir de fichiers mis en zone de préparation.

La référence de la zone de préparation inclut un chemin de dossier nommé path1. La table externe ajoute ce chemin à la définition de la zone de préparation. En d’autres termes, la table externe fait référence aux fichiers de données dans @mystage/files/path1.

Le paramètre AUTO_REFRESH est TRUE par défaut :

CREATE OR REPLACE EXTERNAL TABLE ext_table WITH LOCATION = @mystage/path1/ FILE_FORMAT = (TYPE = JSON);

Étape 3 : Configuration de notifications d’événement¶

Configurez les notifications d’événement pour votre compartiment S3 afin d’avertir Snowflake lorsque des données nouvelles ou mises à jour sont disponibles pour être lues dans les métadonnées de la table externe. La fonctionnalité d’actualisation automatique s’appuie sur les files d’attente SQS pour transmettre les notifications d’événement de S3 à Snowflake.

Pour faciliter l’utilisation, ces files d’attente SQS sont créées et gérées par Snowflake. Le résultat de la commande SHOW EXTERNAL TABLES affiche le nom de ressource Amazon (ARN) de votre file d’attente SQS.

Exécutez la commande SHOW EXTERNALTABLES :

SHOW EXTERNAL TABLES;

Dans la colonne

notification_channel, trouvez l’ARN de la file d’attente SQS pour la table externe, puis copiez le fichier ARN vers un emplacement pratique.Note

Conformément aux directives AWS, Snowflake ne désigne pas plus d’une file d’attente SQS par région S3 AWS. Cette file d’attente SQS peut être partagée entre plusieurs compartiments du même compte AWS. La file d’attente SQS coordonne les notifications de toutes les tables externes lisant des fichiers de données à partir du même compartiment S3. Lorsqu’un fichier de données nouveau ou modifié est téléchargé dans le compartiment, toutes les définitions de table externes correspondant au chemin du répertoire de la zone de préparation lisent les détails du fichier dans leurs métadonnées.

Connectez-vous à la console de gestion AWS.

Configurez une notification d’événement pour votre compartiment S3 à l’aide des instructions fournies dans la `documentation Amazon S3<https://docs.aws.amazon.com/AmazonS3/latest/user-guide/enable-event-notifications.html>`_. Remplissez les champs comme indiqué dans la liste suivante :

Name : nom de la notification d’événement (par exemple,

Auto-ingest Snowflake).Events : sélectionnez les options ObjectCreate (All) et ObjectRemoved.

Send to : sélectionnez SQS Queue dans la liste déroulante.

SQS : sélectionnez Add SQS queue ARN dans la liste déroulante.

SQS queue ARN : collez le nom de la file d’attente SQS à partir de la sortie SHOW EXTERNAL TABLES.

Note

Ces instructions créent une notification d’événement unique qui surveille l’activité de l’ensemble du compartiment S3. C’est l’approche la plus simple. Cette notification traite toutes les tables externes configurées à un niveau plus granulaire dans le répertoire de compartiment S3.

Dans les étapes précédentes, vous pouvez également configurer un ou plusieurs chemins et extensions de fichiers (ou préfixes et suffixes, dans la terminologie AWS) pour filtrer l’activité des événements. Pour obtenir des instructions, voir les informations de filtrage du nom de la clé d’objet dans la rubrique concernée de la documentation `AWS<https://docs.aws.amazon.com/AmazonS3/latest/dev/NotificationHowTo.html>`_. Répétez ces étapes pour chaque chemin ou extension de fichier supplémentaire que vous souhaitez que la notification surveille.

AWS limite le nombre de ces configurations de file d’attente de notification à un maximum de 100 par compartiment S3.

AWS n’autorise pas les configurations de file d’attente qui se chevauchent (entre les notifications d’événement) pour le même compartiment S3. Par exemple, si une notification existante est configurée pour s3://mybucket/files/path1, vous ne pouvez pas en créer une autre à un niveau supérieur, tel que s3://mybucket/files, ou inversement.

Une fois cette étape terminée, la zone de préparation externe avec actualisation automatique est configurée.

Lorsque des fichiers de données nouveaux ou mis à jour sont ajoutés au compartiment S3, la notification d’événement demande à Snowflake de les analyser dans les métadonnées de la table externe.

Étape 4 : Actualisation manuelle des métadonnées de tables externes¶

Actualisez manuellement les métadonnées de tables externes une seule fois à l’aide de ALTER EXTERNAL TABLE avec le paramètre REFRESH, par exemple :

ALTER EXTERNAL TABLE ext_table REFRESH;

Cette étape permet de s’assurer que les métadonnées sont synchronisées avec toutes les modifications apportées à la liste de fichiers depuis l’étape 2. Ensuite, les notifications d’événements S3 déclenchent automatiquement l’actualisation des métadonnées.

Étape 5 : Configuration de la sécurité¶

Pour chaque rôle supplémentaire que vous utiliserez pour interroger la table externe, accordez des privilèges de contrôle d’accès suffisants sur les différents objets (c’est-à-dire les bases de données, les schémas, la zone de préparation et la table) à l’aide de GRANT <privilèges> … TO ROLE :

Objet |

Privilège |

Remarques |

|---|---|---|

Base de données |

USAGE |

|

Schéma |

USAGE |

|

Zone de préparation nommée |

USAGE , READ |

|

Format de fichier nommé |

USAGE |

|

Table externe |

SELECT |

Option 2 : Configuration d’Amazon SNS¶

Cette section fournit des instructions étape par étape sur la façon de déclencher automatiquement l’actualisation des métadonnées de tables externes à l’aide des notifications Amazon SQS (Service de file d’attente simple) pour un compartiment S3. Les étapes vous montrent comment configurer Amazon Simple Notification Service (SNS) en tant que diffuseur pour partager des notifications d’événement pour votre compartiment S3 à plusieurs abonnés (par exemple, des files d’attente SQS ou des charges de travail AWS Lambda), en incluant la file d’attente SQS de Snowflake pour l’automatisation de l’actualisation des tables externes.

Note

Pour que ces instructions fonctionnent, vous devez disposer d’une notification d’événement pour le chemin cible dans votre compartiment S3 où se trouvent vos fichiers de données. S’il n’existe aucune notification d’événement, effectuez l’une des tâches suivantes :

Suivez Option 1 : Création d’une nouvelle notification d’événement S3 (plus tôt dans cette rubrique) à la place.

Créez une notification d’événement pour votre compartiment S3, puis suivez les instructions de cette rubrique. Pour plus d’informations, consultez la `documentation Amazon S3 <https://docs.aws.amazon.com/AmazonS3/latest/user-guide/enable-event-notifications.html> `_.

Conditions préalables : Créer un sujet et un abonnement Amazon SNS¶

Créez un sujet SNS dans votre compte AWS pour gérer tous les messages de l’emplacement de zone de préparation Snowflake sur votre compartiment S3.

Créez un abonnement pour vos destinations cibles afin de recevoir les notifications d’événements S3 (par exemple, d’autres files d’attente SQS ou des charges de travail Lambda AWS) en lien avec ce sujet. SNS publie des notifications d’événement pour votre compartiment à tous les abonnés du sujet.

Pour obtenir des instructions, reportez-vous à la documentation SNS.

Étape 1 : S’abonner à la file d’attente SQS de Snowflake dans le sujet SNS¶

Connectez-vous à la console de gestion AWS.

Dans le tableau de bord d’accueil, sélectionnez Simple Notification Service (SNS).

Cliquez sur Topics dans le volet de navigation de gauche.

Recherchez le sujet de votre compartiment S3. Notez le sujet ARN.

À l’aide d’un client Snowflake, interrogez la fonction système SYSTEM$GET_AWS_SNS_IAM_POLICY avec l’ARN de votre sujet SNS :

select system$get_aws_sns_iam_policy('<sns_topic_arn>');

La fonction renvoie une stratégie IAM accordant à la file d’attente SQS de Snowflake l’autorisation de s’abonner au sujet SNS.

Par exemple :

select system$get_aws_sns_iam_policy('arn:aws:sns:us-west-2:001234567890:s3_mybucket'); +---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------+ | SYSTEM$GET_AWS_SNS_IAM_POLICY('ARN:AWS:SNS:US-WEST-2:001234567890:S3_MYBUCKET') | +---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------+ | {"Version":"2012-10-17","Statement":[{"Sid":"1","Effect":"Allow","Principal":{"AWS":"arn:aws:iam::123456789001:user/vj4g-a-abcd1234"},"Action":["sns:Subscribe"],"Resource":["arn:aws:sns:us-west-2:001234567890:s3_mybucket"]}]} | +---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------+

Revenez à la console de gestion AWS. Cliquez sur Topics dans le volet de navigation de gauche.

Sélectionnez le sujet de votre compartiment S3 et cliquez sur le bouton Edit. La page Edit s’ouvre.

Cliquez sur Access policy - Optional pour développer cette zone de la page.

Fusionnez l’ajout de stratégie IAM des résultats de la fonction SYSTEM$GET_AWS_SNS_IAM_POLICY dans le document JSON.

Par exemple :

Politique IAM originale (abrégée) :

{ "Version":"2008-10-17", "Id":"__default_policy_ID", "Statement":[ { "Sid":"__default_statement_ID", "Effect":"Allow", "Principal":{ "AWS":"*" } .. } ] }

Politique IAM fusionnée :

{ "Version":"2008-10-17", "Id":"__default_policy_ID", "Statement":[ { "Sid":"__default_statement_ID", "Effect":"Allow", "Principal":{ "AWS":"*" } .. }, { "Sid":"1", "Effect":"Allow", "Principal":{ "AWS":"arn:aws:iam::123456789001:user/vj4g-a-abcd1234" }, "Action":[ "sns:Subscribe" ], "Resource":[ "arn:aws:sns:us-west-2:001234567890:s3_mybucket" ] } ] }

Ajoutez une autorisation de politique supplémentaire pour permettre à S3 de publier des notifications d’événement pour le compartiment dans le sujet SNS.

Par exemple (en utilisant le sujet ARN SNS et le compartiment S3 utilisés dans ces instructions) :

{ "Sid":"s3-event-notifier", "Effect":"Allow", "Principal":{ "Service":"s3.amazonaws.com" }, "Action":"SNS:Publish", "Resource":"arn:aws:sns:us-west-2:001234567890:s3_mybucket", "Condition":{ "ArnLike":{ "aws:SourceArn":"arn:aws:s3:*:*:s3_mybucket" } } }

Politique IAM fusionnée :

{ "Version":"2008-10-17", "Id":"__default_policy_ID", "Statement":[ { "Sid":"__default_statement_ID", "Effect":"Allow", "Principal":{ "AWS":"*" } .. }, { "Sid":"1", "Effect":"Allow", "Principal":{ "AWS":"arn:aws:iam::123456789001:user/vj4g-a-abcd1234" }, "Action":[ "sns:Subscribe" ], "Resource":[ "arn:aws:sns:us-west-2:001234567890:s3_mybucket" ] }, { "Sid":"s3-event-notifier", "Effect":"Allow", "Principal":{ "Service":"s3.amazonaws.com" }, "Action":"SNS:Publish", "Resource":"arn:aws:sns:us-west-2:001234567890:s3_mybucket", "Condition":{ "ArnLike":{ "aws:SourceArn":"arn:aws:s3:*:*:s3_mybucket" } } } ] }

Cliquez sur Save changes.

Étape 2 (facultative) : Créer une zone de préparation¶

Créez une zone de préparation externe qui fait référence à votre compartiment S3 à l’aide de la commande CREATE STAGE. Snowflake lit vos fichiers de données en zone de préparation dans les métadonnées de la table externe.

Vous pouvez aussi utiliser une zone de préparation externe.

Note

Pour configurer un accès sécurisé à l’emplacement de stockage Cloud, consultez Configuration de l’accès sécurisé au stockage Cloud (plus tôt dans cette rubrique).

Pour faire référence à une intégration de stockage dans l’instruction CREATE STAGE, le rôle doit avoir le privilège USAGE sur l’objet d’intégration de stockage.

L’exemple suivant crée une zone de préparation nommée mystage dans le schéma actif de la session utilisateur. L’URL de stockage Cloud inclut le chemin files. La zone de préparation fait référence à une intégration de stockage nommée my_storage_int :

USE SCHEMA mydb.public; CREATE STAGE mystage URL = 's3://mybucket/files' STORAGE_INTEGRATION = my_storage_int;

Étape 3 : Création d’une table externe¶

Créez une table externe à l’aide de CREATE EXTERNAL TABLE. Identifiez l’ARN du sujet SNS depuis Conditions préalables : Créez un sujet et un abonnement Amazon SNS :

CREATE EXTERNAL TABLE <table_name>

..

AWS_SNS_TOPIC = '<sns_topic_arn>';

Où :

AWS_SNS_TOPIC = '<sns_topic_arn>'Spécifie l’ARN du sujet SNS de votre compartiment S3. L’instruction CREATE EXTERNAL TABLE souscrit la file d’attente Snowflake SQS au sujet SNS spécifié.

Par exemple, créez une table externe dans le schéma mydb.public qui lit les données JSON à partir de fichiers mis en zone de préparation. La référence de la zone de préparation inclut un chemin de dossier nommé path1. La table externe ajoute ce chemin à la définition de la zone de préparation. En d’autres termes, la table externe fait référence aux fichiers de données dans @mystage/files/path1. Le paramètre AUTO_REFRESH est TRUE par défaut :

CREATE EXTERNAL TABLE ext_table

WITH LOCATION = @mystage/path1/

FILE_FORMAT = (TYPE = JSON)

AWS_SNS_TOPIC = 'arn:aws:sns:us-west-2:001234567890:s3_mybucket';

Pour supprimer ce paramètre d’une table externe, vous devez recréer la table externe en utilisant la syntaxe CREATE OR REPLACE EXTERNAL TABLE.

Étape 4 : Actualisation manuelle des métadonnées de tables externes¶

Actualisez manuellement les métadonnées de tables externes une seule fois à l’aide de ALTER EXTERNAL TABLE avec le paramètre REFRESH, par exemple :

ALTER EXTERNAL TABLE ext_table REFRESH;

Cette étape permet de s’assurer que les métadonnées sont synchronisées avec toutes les modifications apportées à la liste de fichiers depuis l’étape 3. Ensuite, les notifications d’événements S3 déclenchent automatiquement l’actualisation des métadonnées.

Étape 5 : Configuration de la sécurité¶

Pour chaque rôle supplémentaire que vous utiliserez pour interroger la table externe, accordez des privilèges de contrôle d’accès suffisants sur les différents objets (c’est-à-dire les bases de données, les schémas, la zone de préparation et la table) à l’aide de GRANT <privilèges> … TO ROLE :

Objet |

Privilège |

Remarques |

|---|---|---|

Base de données |

USAGE |

|

Schéma |

USAGE |

|

Zone de préparation nommée |

USAGE , READ |

|

Format de fichier nommé |

USAGE |

|

Table externe |

SELECT |