Playground do Cortex¶

O Cortex Playground permite que você compare as conclusões de texto entre os vários modelos de linguagem grandes disponíveis na Cortex AI. É possível testar as respostas do modelo de linguagem entre prompts e configurações do modelo e fazer comparações lado a lado das saídas do modelo. Com alguns cliques, você também pode conectar o modelo a uma tabela Snowflake para fazer experimentos diretamente em seus dados. O Cortex Playground foi criado para ajudá-lo a testar facilmente como diferentes modelos de linguagem desempenham para seu caso de uso antes de decidir qual modelo será implementado na produção.

O Cortex Playground é compatível com todos os modelos disponíveis para a função COMPLETE que estão disponíveis na região de sua conta. Para obter a lista completa de modelos, consulte Disponibilidade de modelos.

Privilégios obrigatórios¶

O Cortex Playground requer a função de banco de dados CORTEX_USER que inclui os privilégios para chamar as funções LLM do Snowflake Cortex. Para obter mais informações, consulte Cortex LLM privileges.

Introdução ao Cortex Playground¶

O Cortex Playground é acessível a partir da Snowflake AI e do ML Studio. É possível acessar o estúdio pelo Snowsight da seguinte forma:

Faça login na Snowsight.

No menu de navegação, selecione AI & ML » Studio. O Cortex Playground aparece entre as outras funções do Studio.

Para abrir o Playground, selecione Try.

Teste seu prompt com um modelo de idioma¶

Use o Cortex Playground para testar prompts em diferentes modelos de linguagem.

Selecione um warehouse. Este warehouse é usado para executar o comando SQL que chama a função COMPLETE.

Selecione um modelo no menu suspenso na parte superior. O menu suspenso inclui apenas os modelos disponíveis na região da conta que está sendo usada.

Digite seu prompt na caixa de prompt e pressione Enter.

A saída do modelo aparece acima da caixa de prompt. É possível selecionar View Code para ver e copiar o comando SQL usado para processar o prompt.

Para tentar um prompt ou modelo diferente, escolha o modelo desejado e digite um novo prompt na caixa de prompt e, em seguida, pressione Enter.

Comparação das saídas do modelo¶

Para comparar a saída de seus prompts entre dois modelos diferentes ou duas configurações diferentes do mesmo modelo, use o recurso Compare.

Comparação de dois modelos¶

Selecione Compare no canto superior direito.

Selecione modelos diferentes para os dois painéis usando o menu suspenso em cada lado.

Abra o painel de configurações selecionando Change settings

ao lado de Compare.

ao lado de Compare.Selecione o botão de alternância Sync para usar as mesmas configurações para os dois modelos.

Digite o prompt e pressione Enter. A saída dos modelos que você selecionou aparece em cada lado.

Comparação das configurações de um modelo¶

Selecione Compare no canto superior direito.

Selecione o mesmo modelo para os dois painéis.

Abra o painel de configurações selecionando Change settings

ao lado de Compare.

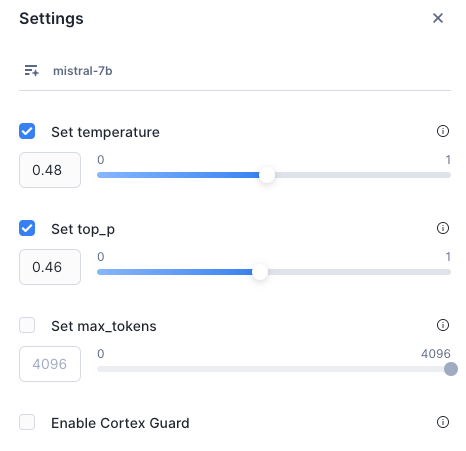

ao lado de Compare.Escolha configurações diferentes para temperature, top_p ou max_tokens em cada guia para comparar como a resposta do modelo de idioma muda com as diferentes configurações do modelo. Para obter mais detalhes sobre esses parâmetros, consulte COMPLETE (SNOWFLAKE.CORTEX).

Você também pode consultar Enable Cortex Guard para implementar proteções que filtram respostas potencialmente inadequadas ou inseguras do modelo de linguagem grande (LLM). Para obter mais detalhes sobre o Cortex Guard, consulte Cortex Guard.

Digite o prompt e pressione Enter. A saída do modelo para cada conjunto de configurações aparece em cada lado.

Conectar-se às tabelas do Snowflake¶

É possível conectar o modelo a uma tabela Snowflake com dados textuais que queira testar com o preenchimento de texto.

Nota

É possível selecionar apenas uma coluna. O Cortex Playground retorna no máximo 100 linhas.

Selecione o botão + Connect your data na caixa de prompt.

Selecione sua fonte de dados Snowflake no menu suspenso.

Selecione a coluna com os dados textuais que deseja testar.

Selecione uma coluna para usar como filtro. É possível usar esta coluna para selecionar um registro de sua fonte de dados.

Selecione Done.

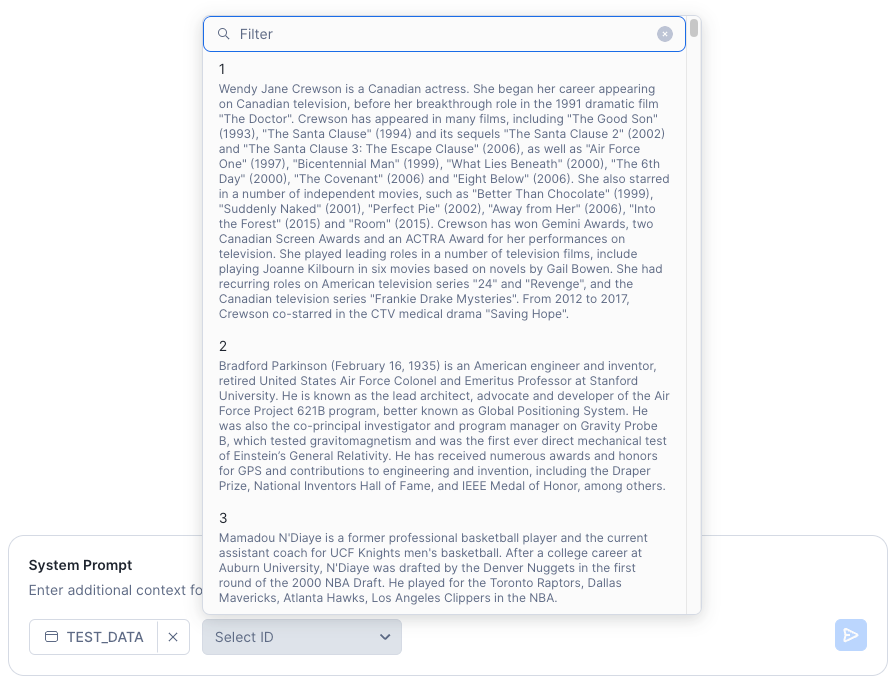

Selecione um registro de sua fonte de dados usando o campo Select <filter column> na caixa de prompt. É possível selecionar um registro rolando a tela ou pesquisando um termo nos dados de texto. Para pesquisar, digite um termo na caixa de pesquisa. O exemplo a seguir mostra uma coluna de filtro nomeada ID. Neste exemplo, você poderia pesquisar um número de ID específico ou inserir uma cadeia de caracteres para corresponder aos dados de texto.

Digite um System Prompt e selecione Enter para ver a resposta do modelo. Um prompt do sistema fornece instruções ao modelo sobre como processar o texto de entrada. Por exemplo, você pode querer que o modelo resuma o texto selecionado ou extraia palavras-chave dele.

Controle de configurações¶

É possível ajustar as configurações do modelo para comparar como a resposta do modelo de idioma muda quando fornecido com diferentes configurações temperature, top_p e max_tokens. Para implementar proteções que filtram respostas potencialmente inadequadas ou inseguras, selecione Enable Cortex Guard no painel de configurações.

É possível ler mais sobre como essas configurações podem afetar as respostas do modelo de linguagem na página Controle de temperatura e tokens.

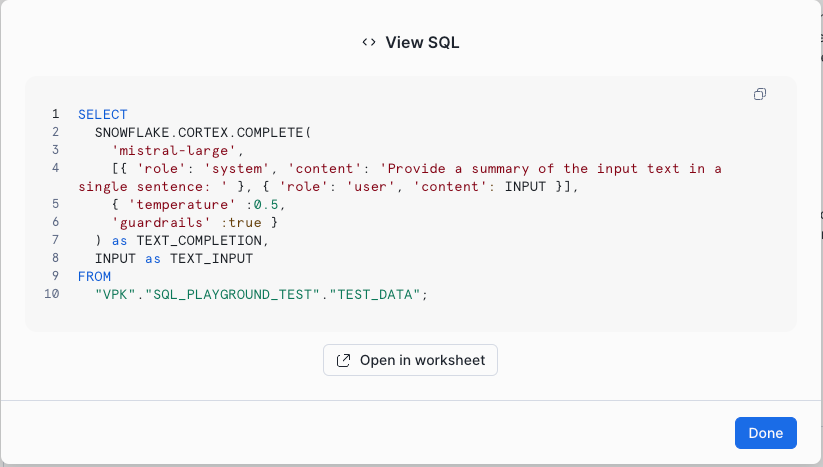

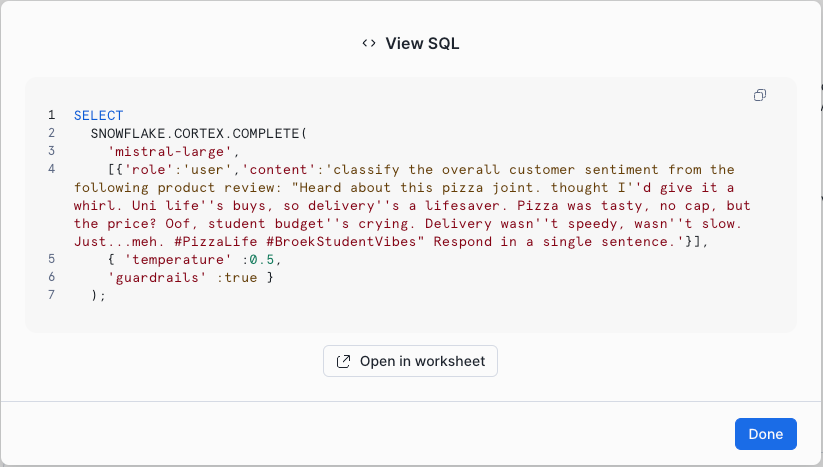

Exportação de uma consulta SQL¶

Para obter uma consulta SQL que inclua as configurações, como a temperatura, que você definiu no Cortex Playground, selecione View Code após qualquer resposta de modelo. O código exibido pode ser executado em uma planilha ou em um notebook, ou automatizado para execução contínua usando fluxos e tarefas. Você também pode usar esse código com uma tabela dinâmica.

Nota

As tabelas dinâmicas não oferecem suporte à atualização incremental com COMPLETE.

As imagens a seguir mostram exemplos da caixa de diálogo View SQL.

Exemplo 1: exportação de código quando você conecta o modelo a uma tabela Snowflake¶

Exemplo 2: exportação de código quando você não conecta o modelo a uma tabela Snowflake¶