Snowpipe Streaming¶

Snowpipe Streaming est le service de Snowflake pour le chargement continu et à faible latence de données en flux directement dans Snowflake. Il permet l’ingestion et l’analyse des données en temps quasi réel, ce qui est crucial pour obtenir des informations en temps opportun et des réponses opérationnelles immédiates. De grands volumes de données provenant de diverses sources de flux sont disponibles pour des requêtes et des analyses en quelques secondes.

Valeur ajoutée de Snowpipe Streaming¶

Disponibilité des données en temps réel : ingère les données au fur et à mesure de leur arrivée, contrairement aux méthodes traditionnelles de chargement par lot, ce qui permet d’afficher des tableaux de bord en direct, d’analyser en temps réel et de détecter les fraudes.

Charges de travail en flux efficaces : utilise les SDKs Snowflake Ingest pour écrire les lignes directement dans les tables, en contournant le stockage Cloud intermédiaire. Cette approche directe réduit la latence et simplifie l’architecture d’ingestion.

Des pipelines de données simplifiés : propose une approche simplifiée pour les pipelines de données en continu à partir de sources telles que les événements d’application, les capteurs IoT, les flux de capture de données modifiées (CDC) et les files d’attente de messages (par exemple, Apache Kafka).

Sans serveur et évolutive : en tant qu’offre sans serveur, elle met automatiquement à l’échelle les ressources de calcul en fonction de la charge d’ingestion, éliminant ainsi la gestion manuelle de l’entrepôt pour les tâches d’ingestion.

Rentable en matière de flux : la facturation est optimisée pour l’ingestion en continu, offrant potentiellement des solutions plus rentables pour les flux de données à haut volume et à faible latence par rapport aux opérations de COPY fréquentes par petits lots.

Avec Snowpipe Streaming, vous pouvez créer des applications de données en temps réel sur le Snowflake Data Cloud, afin de prendre des décisions basées sur les données les plus fraîches disponibles.

Implémentations de Snowpipe Streaming¶

Snowpipe Streaming offre deux implémentations distinctes pour répondre aux différents besoins d’utilisation des données et aux attentes en matière de performance : Snowpipe Streaming, avec une architecture haute performance (avant-première), et Snowpipe Streaming, doté d’une architecture classique :

Snowpipe Streaming avec une architecture haute performance (avant-première)

Snowflake a mis en œuvre cette implémentation de nouvelle génération afin d’améliorer considérablement le débit, d’optimiser les performances de flux et de fournir un modèle de coût prévisible, ouvrant ainsi la voie à des capacités de flux de données avancées.

Caractéristiques clés :

SDK : utilise le nouveau

snowpipe-streamingSDK.Tarification : des tarifs transparents, basés sur le débit (crédits par GB non compressé).

Gestion du flux de données : uilise l’objet PIPE pour gérer le flux de données et permettre des transformations légères au moment de l’ingestion. Les canaux sont ouverts sur cet objet PIPE.

Ingestion : offre une API REST pour l’ingestion directe et légère de données à travers le PIPE.

Validation du schéma : effectuée côté serveur lors de l’ingestion par rapport au schéma défini dans le PIPE.

Performance : conçu pour augmenter considérablement le débit et améliorer l’efficacité des requêtes sur les données ingérées.

Nous vous encourageons à explorer cette architecture avancée, en particulier pour les nouveaux projets de flux.

Snowpipe Streaming avec une architecture classique

Il s’agit de la mise en œuvre originale, généralement disponible, qui fournit une solution fiable pour les pipelines de données établis.

Caractéristiques clés :

SDK : utilise le SDK de Snowflake-ingest-java (toutes les versions jusqu’à 4.x).

Gestion des flux de données : n’utilise pas le concept d’objet PIPE pour l’ingestion de flux. Les canaux sont configurés et ouverts directement par rapport aux tables cibles.

Tarification : basée sur une combinaison de ressources de calcul sans serveur utilisées pour l’ingestion et le nombre de connexions actives des clients.

Le choix de la mise en œuvre¶

Tenez compte de vos besoins immédiats et de votre stratégie de données à long terme lorsque vous choisissez une implémentation :

Nouveaux projets de flux : nous vous recommandons d’évaluer l’architecture haute performance de Snowpipe Streaming (avant-première) pour sa conception tournée vers l’avenir, ses meilleures performances, son évolutivité et la prévisibilité de ses coûts.

Exigences en matière de performances : l’architecture haute performance est conçue pour maximiser le débit et optimiser les performances en temps réel.

Préférence en matière de tarification : l’architecture haute performance propose une tarification claire, basée sur le débit, tandis que l’architecture classique facture en fonction de l’utilisation du calcul sans serveur et des connexions des clients.

Installations existantes : les applications existantes utilisant l’architecture classique peuvent continuer à fonctionner. Pour les futures extensions ou refontes, envisagez de migrer vers l’architecture haute performance ou de l’intégrer.

Définition et gestion des fonctionnalités : l’objet PIPE de l’architecture haute performance introduit des capacités de gestion et de transformation améliorées qui n’existent pas dans l’architecture classique.

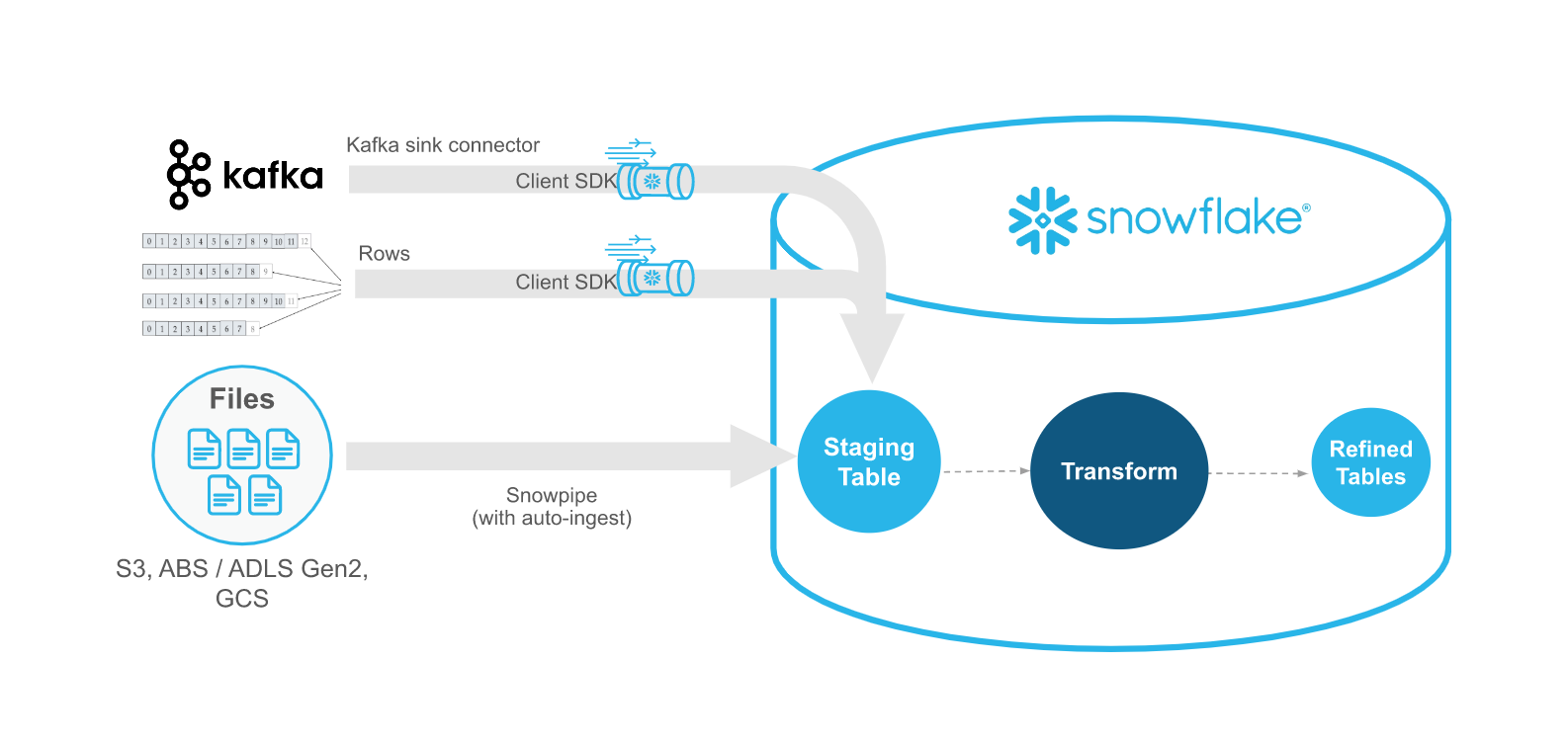

Comparaison de Snowpipe Streaming et de Snowpipe¶

Snowpipe Streaming est destiné à compléter Snowpipe, et non à le remplacer. Utilisez l’API de Snowpipe Streaming dans des scénarios de streaming où les données sont transmises en flux avec des lignes (par exemple, des sujets Apache Kafka) au lieu d’être écrites dans des fichiers. Le API s’intègre dans un flux d’ingestion qui comprend une application Java personnalisée existante qui produit ou reçoit des enregistrements. WIth l’API, vous n’avez pas besoin de créer des fichiers pour charger les données dans les tables de Snowflake. L’API permet le chargement automatique et continu des flux de données dans Snowflake au fur et à mesure que les données sont disponibles.

Le tableau suivant décrit les différences entre Snowpipe Streaming et Snowpipe :

Catégorie |

Snowpipe Streaming |

Snowpipe |

|---|---|---|

Forme des données à charger |

Lignes |

Fichiers. Si votre pipeline de données existant génère des fichiers dans un stockage Blob, nous vous recommandons d’utiliser Snowpipe au lieu du API. |

Exigences relatives aux logiciels tiers |

Code d’application Java personnalisé pour le Snowflake Ingest SDK. |

Aucun(e) |

Commande de données |

Insertions ordonnées dans chaque canal. |

Non pris en charge. Snowpipe peut charger des données à partir de fichiers dans un ordre différent des horodatages de création des fichiers dans le stockage cloud. |

Historique de chargement |

Historique de chargement enregistré dans la vue SNOWPIPE_STREAMING_FILE_MIGRATION_HISTORY (Account Usage). |

Historique de chargement enregistré dans COPY_HISTORY (Account Usage) et la fonction COPY_HISTORY (Information Schema). |

Objet du canal |

L’architecture classique ne nécessite pas d’objet de type « Canal ». L’API écrit les enregistrements directement dans les tables cibles. L’architecture haute performance exige un objet de type « Canal ». |

Nécessite un objet Canal qui met en file d’attente et charge les données des fichiers en zone de préparation dans les tables cibles. |

Exigences du logiciel¶

SDK Java¶

Des SDKs spécifiques à Java facilitent l’interaction avec le service Snowpipe Streaming. Vous pouvez télécharger les SDKs à partir du référentiel central Maven. Les listes suivantes présentent les exigences, qui dépendent de l’architecture Snowpipe Streaming que vous utilisez :

Pour Snowpipe Streaming avec une architecture de haute performance :

SDK : utilisez le nouveau Snowpipe-streaming SDK.

Version Java : l’utilisation de Java 11 ou d’une version ultérieure est exigée.

Pour Snowpipe Streaming Classic :

SDK : utilisez la version 4.X ou ultérieure de snowflake-ingest-sdk.

Version de Java : exige Java 8 ou une version ultérieure.

Prérequis supplémentaires : Java Cryptography Extension (JCE) Unlimited Strength Jurisdiction Policy Files doit être installé pour votre environnement Java 8.

Important

Le SDK fait REST API des appels à Snowflake. Vous devrez peut-être ajuster les règles du pare-feu de votre réseau pour permettre la connectivité.

Application client personnalisée¶

L’API nécessite une interface d’application Java personnalisée capable de récupérer des lignes de données et de gérer les erreurs qui surviennent. Vous devez vous assurer que l’application fonctionne en continu et qu’elle peut se rétablir en cas d’échec. Pour un lot de lignes donné, les API prennent en charge l’équivalent de ON_ERROR = CONTINUE | SKIP_BATCH | ABORT.

CONTINUE: continuer à charger les lignes de données acceptables et renvoyer toutes les erreurs.SKIP_BATCH: ignorer le chargement et renvoyer toutes les erreurs si une erreur est rencontrée dans l’ensemble du lot de lignes.ABORT(paramètre par défaut) : abandonner l’ensemble du lot de lignes et lever une exception à la première erreur rencontrée.

Pour Snowpipe Streaming classic, l’application effectue des validations de schéma en utilisant la réponse des méthodes insertRow (ligne unique) ou insertRows (ensemble de lignes). En ce qui concerne la gestion des erreurs pour l’architecture haute performance, voir Traitement des erreurs.

Canaux¶

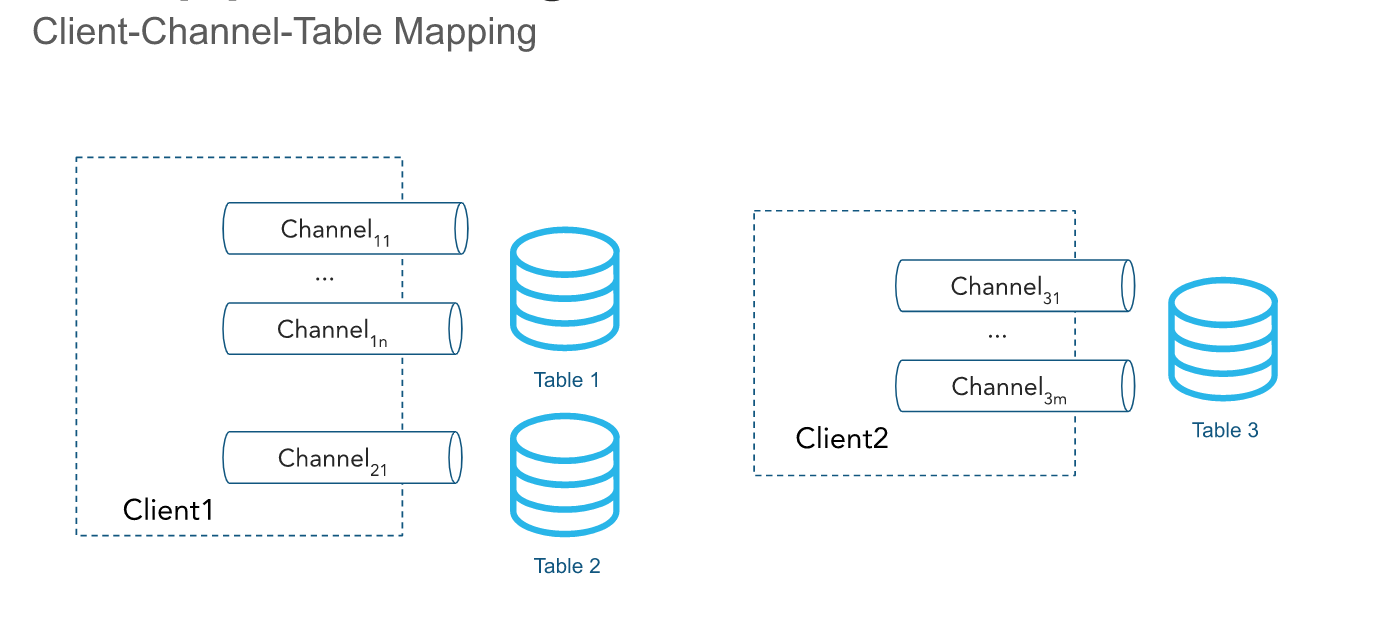

L’API reçoit des lignes par l’intermédiaire d’un ou de plusieurs canaux. Un canal représente une connexion de streaming logique et nommée avec Snowflake pour le chargement de données dans une table. Un seul canal correspond à une seule table dans Snowflake ; toutefois, plusieurs canaux peuvent pointer vers la même table. Le client SDK a la possibilité d’ouvrir plusieurs canaux vers plusieurs tables ; mais le client SDK ne peut pas ouvrir de canaux sur plusieurs comptes. L’ordre des lignes et les jetons de décalage correspondants sont préservés au sein d’un canal, mais pas entre les canaux qui pointent vers la même table.

Les canaux sont conçus pour durer longtemps lorsqu’un client insère activement des données, et ils doivent être réutilisés, car les informations de jeton de décalage sont conservées. Les données à l’intérieur du canal sont automatiquement effacées toutes les secondes, par défaut, et le canal n’a pas besoin d’être fermé. Pour plus d’informations, voir Latence.

Vous pouvez supprimer définitivement des canaux en utilisant DropChannelRequest l’API lorsque vous n’avez plus besoin du canal et des métadonnées de décalage associées. Il existe deux façons de supprimer un canal :

Suppression d’un canal à la fermeture. Les données à l’intérieur du canal sont automatiquement vidées avant la suppression du canal.

Suppression d’un canal à l’aveugle. Cela n’est pas recommandé, car la suppression d’un canal à l’aveugle supprime toutes les données en attente et peut rendre invalides tous les canaux déjà ouverts.

Vous pouvez lancer la commande SHOW CHANNELS pour obtenir la liste des chaînes pour lesquelles vous disposez de privilèges d’accès. Pour plus d’informations, consultez SHOW CHANNELS.

Note

Les canaux inactifs ainsi que leurs jetons de décalage sont automatiquement supprimés après 30 jours.

Jetons de décalage¶

Un jeton de décalage est une chaîne de caractères qu’un client peut inclure dans ses requêtes de méthode de soumission de ligne (par exemple, pour une ou plusieurs lignes) afin de suivre la progression de l’ingestion sur la base par canal. Les méthodes spécifiques utilisées sont insertRow ou insertRows pour l’architecture classique, et appendRow ou appendRows pour l’architecture haute performance. Le jeton est initialisé à la valeur NULL lors de la création du canal et est mis à jour lorsque les lignes avec un jeton de décalage fourni sont validées dans Snowflake par le biais d’un processus asynchrone. Les clients peuvent périodiquement faire des requêtes en utilisant la méthode getLatestCommittedOffsetToken afin d’obtenir le dernier jeton de décalage engagé pour un canal particulier et l’utiliser pour raisonner sur la progression de l’ingestion. Notez que ce jeton n’est pas utilisé par Snowflake pour effectuer la déduplication ; cependant, les clients peuvent utiliser ce jeton pour effectuer la déduplication en utilisant votre code personnalisé.

Lorsqu’un client rouvre un canal, le dernier jeton de décalage persistant est renvoyé. Le client peut réinitialiser sa position dans la source de données en utilisant le jeton pour éviter d’envoyer deux fois les mêmes données. Notez que lorsqu’un événement de réouverture d’un canal se produit, toutes les données mises en mémoire tampon dans Snowflake sont écartées pour éviter de les engager.

Vous pouvez utiliser le dernier jeton de décalage engagé pour effectuer les opérations suivantes :

Suivre la progression de l’ingestion.

Vérifier si un décalage spécifique a été validé en le comparant au dernier jeton de décalage validé.

Avancer le décalage de la source et purger les données qui ont déjà été engagées.

Permettre la déduplication et assurer la livraison des données « exactly-once ».

Par exemple, le connecteur Kafka pourrait lire un jeton de décalage à partir d’un sujet tel que <partition>:<décalage>, ou simplement <décalage> si la partition est encodée dans le nom du canal. Prenons la requête suivante :

Le connecteur Kafka est en ligne et ouvre un canal correspondant à

Partition 1dans le sujet KafkaTavec le nom de canalT:P1.Le connecteur commence à lire les enregistrements de la partition Kafka.

Le connecteur appelle le API, en faisant une demande de méthode

insertRowsavec le décalage associé à l’enregistrement comme jeton de décalage.Par exemple, le jeton de décalage pourrait être

10, faisant référence au dixième enregistrement de la partition Kafka.Le connecteur effectue périodiquement des

getLatestCommittedOffsetTokendemandes de méthode pour déterminer la progression de l’ingestion.

Si le connecteur Kafka tombe en panne, la procédure suivante peut être complétée pour reprendre la lecture des enregistrements à partir du décalage correct pour la partition Kafka :

Le connecteur Kafka revient en ligne et rouvre le canal en utilisant le même nom que précédemment.

Le connecteur appelle le API, en faisant une demande de méthode

getLatestCommittedOffsetTokenpour obtenir le dernier décalage engagé pour la partition.Par exemple, supposons que le dernier jeton de décalage persistant est

20.Le connecteur utilise la lecture Kafka APIs pour réinitialiser un curseur correspondant au décalage plus 1 (

21dans cet exemple).Le connecteur reprend la lecture des enregistrements. Aucune donnée en double n’est récupérée après le repositionnement réussi du curseur de lecture.

Dans un autre exemple, une application lit les journaux d’un répertoire et utilise le client Snowpipe Streaming SDK pour exporter ces journaux vers Snowflake. Vous pouvez construire une application d’exportation de journaux qui fait ce qui suit :

Lister les fichiers dans le répertoire du journal.

Supposons que le framework de journalisation génère des fichiers journaux qui peuvent être ordonnés lexicographiquement et que les nouveaux fichiers journaux sont placés à la fin de cet ordre.

Lit un fichier journal ligne par ligne et appelle les requêtes de la méthode API, effectuant

insertRowsavec un jeton de décalage correspondant au nom du fichier journal et au nombre de lignes ou à la position des octets.Par exemple, un jeton de décalage pourrait être

messages_1.log:20, oùmessages_1.logest le nom du fichier journal et20est le numéro de ligne.

Si l’application tombe en panne ou doit être redémarrée, elle appelle alors le API, en faisant une demande de méthode getLatestCommittedOffsetToken pour récupérer un jeton de décalage qui correspond à au dernier fichier journal et à la dernière ligne exportés. En continuant avec l’exemple, cela pourrait être messages_1.log:20. L’application ouvrirait alors messages_1.log et chercherait la ligne 21 pour éviter que la même ligne de journal soit ingérée deux fois.

Note

Les informations relatives au jeton de décalage peuvent être perdues. Le jeton de décalage est lié à un objet de canal, et un canal est automatiquement effacé si aucune nouvelle ingestion n’est effectuée en utilisant le canal pendant une période de 30 jours. Pour éviter la perte du jeton de décalage, envisagez de maintenir un décalage séparé et de réinitialiser le jeton de décalage du canal si nécessaire.

Rôles de offsetToken et continuationToken¶

offsetToken et continuationToken sont tous deux utilisés pour garantir une livraison unique des données, mais ils répondent à des usages différents et sont gérés par des systèmes différents. La principale distinction réside dans ce qui contrôle la valeur du jeton et dans la portée de son utilisation.

continuationToken(s’applique uniquement à l’architecture hautes performances) :Ce jeton est géré par Snowflake et est essentiel pour maintenir l’état d’une session de streaming unique et continue. Lorsqu’un client envoie des données à l’aide de l’API

Append Rows, Snowflake lui renvoie uncontinuationToken. Le client doit utiliser ce jeton dans sa requête suivante pour s’assurer que les données sont reçues dans le bon ordre et sans interruption. Snowflake utilise le jeton pour détecter et empêcher les doublons de données en cas de nouvelle tentative SDK.offsetToken(s’applique à la fois aux architectures classiques et hautes performances) :Ce jeton est un identificateur défini par l’utilisateur qui permet une livraison unique à partir d’une source externe. Snowflake n’utilise pas ce jeton pour ses propres opérations internes ou pour empêcher la réingestion. Au lieu de cela, Snowflake stocke simplement cette valeur. Il est de la responsabilité du système externe (comme un connecteur Kafka) de lire le jeton de décalage de Snowflake et de l’utiliser pour suivre sa propre progression d’ingestion et éviter d’envoyer des doublons de données si le flux externe doit être rejoué.

Meilleures pratiques en matière de livraison « exactly-once »¶

Il peut être difficile d’assurer une livraison en une seule fois, et il est essentiel de respecter les principes suivants dans votre code personnalisé :

Pour garantir une récupération appropriée en cas d’exceptions, de défaillances ou de pannes, vous devez toujours rouvrir le canal et redémarrer l’ingestion en utilisant le dernier jeton de décalage validé.

Bien que votre application puisse maintenir son propre décalage, il est crucial d’utiliser le dernier jeton de décalage engagé fourni par Snowflake comme source de vérité et de réinitialiser votre propre décalage en conséquence.

Le seul cas où votre propre décalage doit être considéré comme la source de vérité est lorsque le jeton de décalage de Snowflake est défini ou réinitialisé sur une valeur NULL. Un jeton de décalage NULL signifie généralement l’une des choses suivantes :

Il s’agit d’un nouveau canal, aucun jeton de décalage n’a donc été défini.

La table cible a été supprimée et recréée, de sorte que le canal est considéré comme nouveau.

Aucune activité d’ingestion n’ayant eu lieu pendant 30 jours, le canal a été automatiquement nettoyé et les informations relatives au jeton de décalage ont été perdues.

Si nécessaire, vous pouvez périodiquement purger les données source qui ont déjà été validées sur la base du dernier jeton de décalage validé et avancer votre propre décalage.

Si le schéma de la table est modifié lorsque les canaux Snowpipe Streaming sont actifs, le canal doit être rouvert. Le connecteur Snowflake Kafka gère ce scénario automatiquement, mais si vous utilisez le SDK de Snowflake Ingest directement, vous devez rouvrir le canal vous-même.

Pour plus d’informations sur la façon dont le connecteur Kafka avec Snowpipe Streaming réalise la livraison « exactly-once », consultez Sémantique unique et exacte.

Charger des données dans des tables Apache Iceberg™¶

Avec la version 3.0.0 et ultérieures du SDK Snowflake Ingest, Snowpipe Streaming peut ingérer des données dans les tables Apache Iceberg gérées par Snowflake. Le SDK Snowpipe Ingest Java prend en charge le chargement dans les tables Snowflake standard (non-Iceberg) et les tables Iceberg.

Pour plus d’informations, voir Utilisation de Snowpipe Streaming Classic avec les tables Apache Iceberg™.

Latence¶

Snowpipe Streaming efface automatiquement les données des canaux toutes les secondes. Vous n’avez pas besoin de fermer le canal pour que les données soient vidées.

Avec les versions de SDK 2.0.4 et ultérieures de Snowflake Ingest, vous pouvez configurer la latence via l’option MAX_CLIENT_LAG.

Pour les tables Snowflake standard (non-Iceberg), la valeur par défaut de

MAX_CLIENT_LAGest de 1 seconde.Pour les tables Iceberg (prises en charge par la version 3.0.0 et ultérieures du SDK Snowflake Ingest), la valeur par défaut de

MAX_CLIENT_LAGest de 30 secondes.

La latence maximale peut être fixée à 10 minutes. Pour plus d’informations, consultez MAX_CLIENT_LAG et les configurations de latence recommandées pour Snowpipe Streaming.

Notez que le connecteur Kafka pour Snowpipe Streaming a son propre tampon. Une fois que le temps de vidage de tampon Kafka est atteint, les données seront envoyées avec une seconde de latence à Snowflake par le biais de Snowpipe Streaming. Pour plus d’informations, voir temps.vidage.tampon.

Migration vers des fichiers optimisés dans l’architecture classique¶

Le API écrit les lignes des canaux dans les blobs du stockage cloud, qui sont ensuite transférés dans la table cible. Initialement, les données streamées écrites dans une table cible sont stockées dans un format de fichier intermédiaire temporaire. À ce stade, la table est considérée comme une « table mixte « , car les données partitionnées sont stockées dans un mélange de fichiers natifs et intermédiaires. Un processus automatisé en arrière-plan fait migrer les données des fichiers intermédiaires actifs vers des fichiers natifs optimisés pour les requêtes et les opérations DML, selon les besoins.

Réplication dans l’architecture classique¶

Le Streaming Snowpipe prend en charge la réplication et le basculement des tables Snowflake remplies par Snowpipe Streaming et ses décalages de canaux associés d’un compte source vers un compte cible dans différentes régions et sur les plateformes Cloud.

La réplication n’est pas prise en charge pour l’architecture haute performance.

Pour plus d’informations, voir Réplication et Streaming Snowpipe.

Opérations à insertion uniquement¶

L” API est actuellement limité à l’insertion de lignes. Pour modifier, supprimer ou combiner des données, écrivez les enregistrements « bruts « dans une ou plusieurs tables mises en zone de préparation. Fusionnez, joignez ou transformez les données en utilisant des pipelines de données continus pour insérer les données modifiées dans les tableaux de reporting de destination.

Classes et interfaces¶

Pour la documentation sur les classes et les interfaces de l’architecture classique, voir Snowflake Ingest SDK API.

Pour les différences entre les architectures classique et haute performance, voir Différences de l’API.

Types de données Java pris en charge¶

Le tableau suivant résume les types de données Java pris en charge pour l’ingestion dans les colonnes Snowflake :

Type de colonne Snowflake |

Type de données Java autorisées |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Privilèges d’accès requis¶

L’appel de l’API de Snowpipe Streaming nécessite un rôle avec les privilèges suivants :

Objet |

Privilège |

|---|---|

Table |

OWNERSHIP ou au minimum INSERT et EVOLVE SCHEMA (uniquement requis lors de l’utilisation de l’évolution des schémas pour le connecteur Kafka avec Snowpipe Streaming) |

Base de données |

USAGE |

Schéma |

USAGE |

Canal |

OPERATE (nécessaire uniquement pour l’architecture hautes performances) |

Limitations¶

Pour Snowpipe Streaming Classic, tenez compte des limites suivantes :

Snowpipe Streaming Classic ne prend pas en charge les limites de taille maximales augmentées pour les objets de base de données (128 MB pour VARCHAR, VARIANT, ARRAY et OBJECT, et 64 MB pour BINARY, GEOGRAPHY et GEOMETRY) qui font partie du bundle de changements de comportement 2025_03.

Fail-safe ne prend pas en charge les tables qui contiennent des données ingérées par Snowpipe Streaming Classic. Pour de telles tables, vous ne pouvez pas utiliser Fail-safe pour la récupération, car les opérations Fail-safe sur cette table échouent complètement.

Snowpipe Streaming prend uniquement en charge l’utilisation de clés AES 256 bits pour le chiffrement des données.

Si le clustering automatique est également activé sur la même table que celle dans laquelle Snowpipe Streaming insère, les coûts de calcul pour la migration des fichiers peuvent être réduits. Pour plus d’informations, voir Snowpipe Streaming Classic - Meilleures pratiques.

Les objets ou types suivants ne sont pas pris en charge :

Les types de données GEOGRAPHY et GEOMETRY

Colonnes avec classements

Tables TEMPORARY

Le nombre total de canaux par table ne peut pas dépasser 10 000. Nous vous recommandons de réutiliser les canaux si nécessaire. Contactez le support Snowflake si vous devez ouvrir plus de 10 000 canaux par table.

L’architecture à haute performance présente d’autres considérations et limites par rapport à l’architecture classique. Pour plus d’informations, voir les limites de l’architecture haute performance.