Snowpark Migration Accelerator: Die Zusammenfassung der Bewertung verstehen¶

Nachdem Sie eine Bewertung durchgeführt haben, können Sie die ersten Ergebnisse und die Zusammenfassung im Zusammenfassungsbericht der Bewertung einsehen. Um auf diesen Bericht zuzugreifen, klicken Sie auf die Schaltfläche Ergebnisse anzeigen.

Dadurch wird Ihr Bewertungsbericht angezeigt. Beachten Sie, dass dieser Bericht die Informationen aus den Bestandsdateien zusammenfasst, die während der Ausführung von SMA im Ordner Ausgabeberichte erstellt wurden. Für eine umfassende Analyse lesen Sie bitte den Detaillierten Bericht im Ausgabeverzeichnis.

Der Abschnitt „Bewertungsergebnis“ der Anwendung enthält mehrere Komponenten, die im Folgenden näher erläutert werden.

Standardsammenfassung der Bewertung¶

Die Zusammenfassung wird wie unten angezeigt:

In der oberen rechten Ecke des Berichts finden Sie ein Dropdown-Menü mit dem Datum, an dem Ihre Analyse ausgeführt wurde. Wenn Sie den Accelerator mehrmals innerhalb desselben Projekts ausgeführt haben, werden im Dropdown-Menü mehrere Daten angezeigt. Diese Daten beziehen sich nur auf Ausführungen aus Ihrem aktuell geöffneten Projekt.

Snowpark Connect-Bereitschaftsbewertung¶

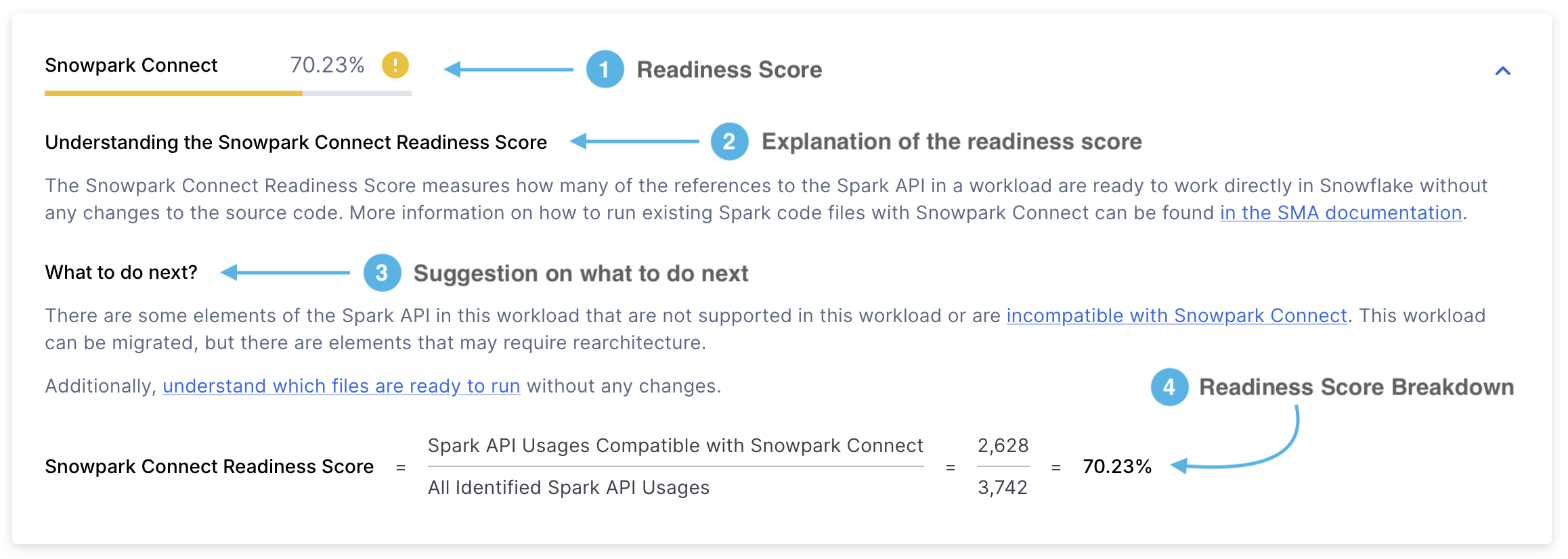

Die Snowpark Connect-Bereitschaftsbewertung sieht ungefähr wie folgt aus:

Bereitschaftsbewertung – Zeigt Ihnen die Bereitschaftsbewertung an, die Sie erhalten haben. Die Snowpark Connect-Bereitschaftsbewertung gibt den Anteil von Spark API-Referenzen an, die von Snowpark Connect unterstützt werden. Diese Punktzahl wird berechnet, indem die Anzahl der unterstützten Spark API-Referenzen durch die gesamten Spark API-Referenzen geteilt wird. Mehr über diese Bewertung erfahren Sie im Abschnitt Snowpark Connect-Bereitschaftsbewertung.

Erläuterung zur Bewertung – Eine Erläuterung, was die Snowpark Connect-Bereitschaftsbewertung ist und wie Sie sie interpretieren können.

Nächste Schritte – Abhängig von der erhaltenen Bereitschaftsbewertung empfiehlt Ihnen der SMA, welche Maßnahmen Sie ergreifen sollten, bevor Sie mit dem nächsten Schritt fortfahren.

Aufschlüsselung der Bewertung – Eine ausführliche Erläuterung, wie die Snowpark Connect-Bereitschaftsbewertung berechnet wurde. In diesem Fall wird die Anzahl der Spark API-Referenzen angezeigt, die von Snowpark Connect unterstützt werden, geteilt durch die Gesamtzahl der Spark API-Referenzen.

Unterstützte Nutzungen bezieht sich auf die Anzahl der Spark API-Referenzen in einem Workload, die von Snowpark Connect unterstützt werden. Im Gegensatz dazu stellen identifizierte Nutzungen die Gesamtzahl der Spark API-Referenzen dar, die innerhalb dieses Workloads gefunden wurden.

Spark API-Bereitschaftsbewertung¶

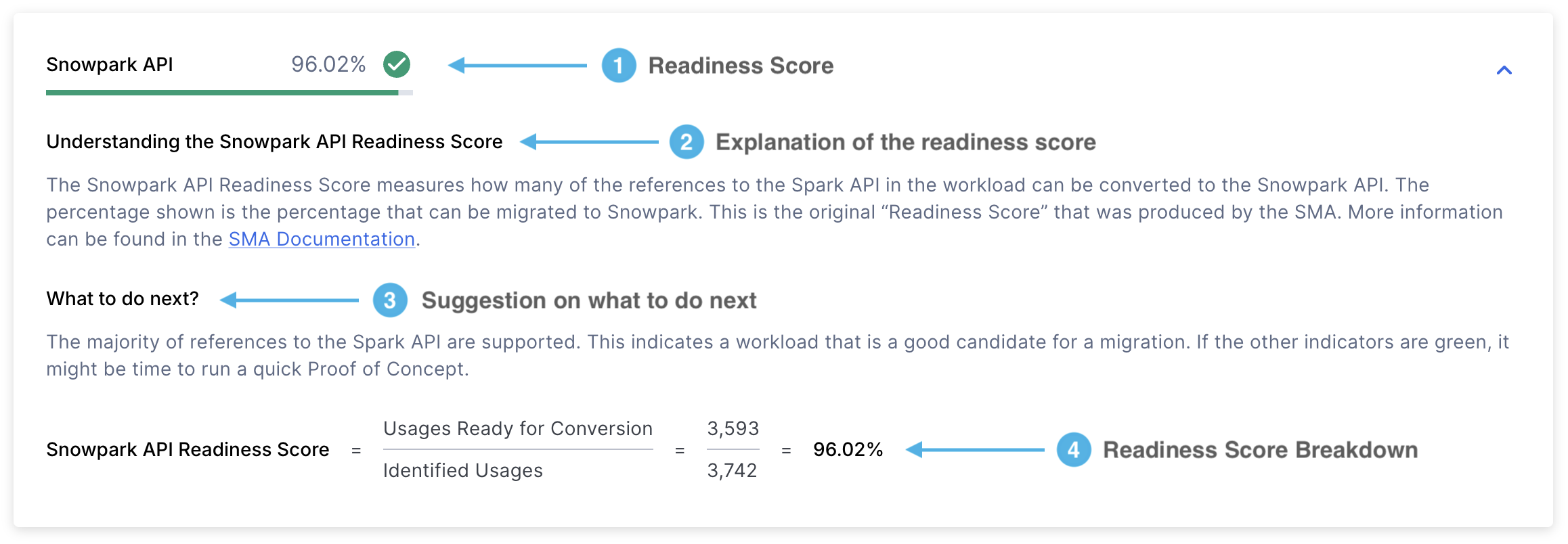

Dieser Bericht enthält mehrere Elemente, wobei die Bereitschaftsbewertung die wichtigste Metrik ist.

Lassen Sie uns jeden Abschnitt im Detail betrachten:

Bereitschaftsbewertung - Die Spark API-Bereitschaftsbewertung ist die wichtigste Metrik, die SMA verwendet, um zu bewerten, wie bereit Ihr Code für die Migration ist. Dieser Wert gibt den Prozentsatz der Spark API-Referenzen an, die in Snowpark API umgewandelt werden können. Diese Bewertung ist zwar nützlich, berücksichtigt aber nur die Referenzen von Spark API und keine Bibliotheken von Drittanbietern oder andere Faktoren. Verwenden Sie es daher als erste Einschätzung und nicht als vollständige Bewertung.

Die Punktzahl wird berechnet, indem die Anzahl der konvertierbaren Spark API-Referenzen durch die Gesamtzahl der in Ihrem Code gefundenen Spark API-Referenzen geteilt wird. Wenn die Punktzahl beispielsweise 3541/3746 anzeigt, bedeutet dies, dass 3541 Referenzen von insgesamt 3746 Referenzen konvertiert werden können. Eine höhere Punktzahl bedeutet eine bessere Kompatibilität mit Snowpark API. Diese Punktzahl finden Sie auf der ersten Seite des detaillierten Berichts.

Erläuterung der Bewertung – Dieser Abschnitt enthält Details darüber, was die Spark API-Bereitschaftsbewertung bedeutet und wie Sie Ihre Ergebnisse interpretieren können.

Nächste Schritte – Abhängig von der erhaltenen Bereitschaftsbewertung empfiehlt Ihnen der SMA, welche Maßnahmen Sie ergreifen sollten, bevor Sie mit dem nächsten Schritt fortfahren.

Aufschlüsselung der Bewertung – In diesem Abschnitt wird gezeigt, wie Ihre Punktzahl anhand von zwei wichtigen Kennzahlen berechnet wurde:

Verwendungen, die für die Konvertierung bereit sind: Die Anzahl der Spark API-Referenzen (Funktionen, Elemente oder Importanweisungen), die in Snowpark konvertiert werden können

Identifizierte Verwendungen: Die Gesamtzahl der Spark API-Referenzen, die in Ihrem Code gefunden wurden

Bereitschaftsbewertung von Bibliotheken von Drittanbietern¶

Die Bereitschaftsbewertung von Drittanbieter-Bibliotheken wird im folgenden Format angezeigt:

Bereitschaftsbewertung - Zeigt Ihre Bereitschaftsbewertung und ihre Kategorie (grün, gelb oder rot) an. Die Bereitschaftsbewertung von Drittanbieter-Bibliotheken zeigt an, wie viel Prozent Ihrer importierten Bibliotheken von Snowflake unterstützt werden. Weitere Einzelheiten finden Sie im Abschnitt Drittanbieter API-Bereitschaftsbewertung.

Nächste Schritte – Abhängig von der erhaltenen Bereitschaftsbewertung empfiehlt Ihnen der SMA, welche Maßnahmen Sie ergreifen sollten, bevor Sie mit dem nächsten Schritt fortfahren.

Erläuterung der Bewertung - Beschreibt, was die Bereitschaftsbewertung von Drittanbieter-Bibliotheken bedeutet und wie Sie diese Ergebnisse interpretieren können.

Aufschlüsselung der Bewertung - Zeigt an, wie Ihre Bereitschaftsbewertung von Drittanbieter-Bibliotheken anhand dieser Formel berechnet wurde: (Anzahl der in Snowpark unterstützten Bibliotheksaufrufe) ÷ (Gesamtzahl der identifizierten Bibliotheksaufrufe)

Wobei:

„In Snowpark unterstützte Bibliotheksaufrufe“ bedeutet: Bibliotheken, die Snowpark verwenden kann

„Identifizierte Bibliotheksaufrufe“ bedeutet: alle Bibliotheksaufrufe von Drittanbietern, die in Ihrem Code gefunden werden, einschließlich Spark- und Nicht-Spark-Bibliotheken, unabhängig davon, ob sie unterstützt werden oder nicht

SQL-Bereitschaftsbewertung¶

Die SQL-Bereitschaftsbewertung wird im folgenden Format angezeigt:

Bereitschaftsbewertung - Zeigt Ihre Bereitschaftsbewertung und ihre Kategorie (grün, gelb oder rot) an. Dieser Wert gibt an, wie viele SQL-Elemente in Ihrem Code erfolgreich in Snowflake SQL umgewandelt werden können. Weitere Einzelheiten finden Sie im Abschnitt SQL Bereitschaftsbewertung.

Nächste Schritte - Basierend auf Ihrer Bereitschaftsbewertung gibt SMA Empfehlungen für Maßnahmen, die Sie ergreifen sollten, bevor Sie fortfahren.

Erläuterung der Bewertung - Bietet eine klare Erläuterung der SQL-Bereitschaftsbewertungen und zeigt, wie Sie Ihre Ergebnisse interpretieren können.

Aufschlüsselung der Bewertung - Zeigt eine detaillierte Berechnung Ihrer SQL-Bereitschaftsbewertung, berechnet als: (Anzahl der unterstützten Elemente) ÷ (Gesamtzahl der Elemente).

Spark API-Verwendungen¶

Gefahr

Der Abschnitt Spark API-Verwendungen ist seit Version 2.0.2 veraltet. Sie können jetzt finden:

Eine Zusammenfassung der Verwendung von Spark API unter der detaillierte Bericht

Eine vollständige Liste aller Spark API-Verwendungsinstanzen unter der Bestand der Spark API-Verwendungen

Der Bericht enthält drei Hauptabschnitte, die als Registerkarten angezeigt werden:

Klassifizierung der Gesamtverwendung

Spark API-Verwendungskategorisierung

Spark API-Verwendungen nach Status

Im Folgenden werden wir jeden Abschnitt im Detail untersuchen.

Klassifizierung der Gesamtverwendung¶

Diese Registerkarte zeigt eine Tabelle mit drei Zeilen, die Folgendes zeigen:

Unterstützte Operationen

Nicht unterstützte Operationen

Gesamtverwendungsstatistik

.png> „Bild“)

Weitere Einzelheiten finden Sie im folgenden Abschnitt:

Anzahl der Verwendungen - Die Gesamtzahl der Referenzen von Spark API-Funktionen in Ihrem Code. Jede Referenz wird entweder als „unterstützt“ oder „nicht unterstützt“ eingestuft, wobei die Gesamtzahl unten angezeigt wird.

Dateien mit mindestens 1 Verwendung - Die Anzahl der Dateien, die mindestens eine Spark API-Referenz enthalten. Wenn diese Zahl geringer ist als die Gesamtzahl Ihrer Dateien, bedeutet dies, dass einige Dateien Spark API überhaupt nicht verwenden.

Prozentualer Anteil aller Dateien - Zeigt an, welcher Anteil Ihrer Dateien Spark API verwendet. Dieser Wert wird berechnet, indem die Anzahl der Dateien mit Spark API durch die Gesamtzahl der Codedateien geteilt und als Prozentsatz ausgedrückt wird.

Spark API-Verwendungskategorisierung¶

Diese Registerkarte zeigt die verschiedenen Arten von Spark-Referenzen an, die in Ihrer Codebasis entdeckt wurden. Sie zeigt die allgemeine Bereitschaftsbewertung an (das ist dieselbe Bewertung, die oben auf der Seite angezeigt wird) und bietet eine detaillierte Aufschlüsselung dieser Bewertungen nach Kategorien.

.png> „Bild“)

Alle verfügbaren Kategorisierungen finden Sie im Abschnitt Spark-Referenzkategorien.

Spark API-Verwendungen nach Status¶

Die letzte Registerkarte zeigt eine kategorische Aufschlüsselung nach Zuordnungsstatus.

.png> „Bild“)

Das Tool SMA verwendet sieben Haupt-Zuordnungsstatus, die angeben, wie gut Spark-Code in Snowpark konvertiert werden kann. Ausführliche Informationen zu diesen Status finden Sie im Abschnitt Spark-Referenzkategorien.

Anrufe importieren¶

Gefahr

Der Abschnitt Importaufrufe wurde seit Version 2.0.2 entfernt. Sie können jetzt finden:

Eine Zusammenfassung der Importanweisungen in der detaillierte Bericht

Eine vollständige Liste aller Importaufrufe unter der Bestand der Importverwendungen

Der Abschnitt „Importaufrufe“ zeigt häufig verwendete externe Bibliotheksimporte an, die Sie in Ihrer Codebasis gefunden haben. Beachten Sie, dass die Importe von Spark API von diesem Abschnitt ausgeschlossen sind, da sie im Abschnitt „Spark API“ separat behandelt werden.

.png> „Bild“)

Diese Tabelle enthält die folgenden Informationen:

Der Bericht zeigt die folgenden Informationen an:

Eine Tabelle mit 5 Zeilen, die Folgendes anzeigen:

Die 3 am häufigsten importierten Python-Bibliotheken

Eine Zeile „Sonstige“, die alle verbleibenden Pakete zusammenfasst

Eine Zeile „Gesamt“, die die Summe aller Importe anzeigt

Eine Spalte „Unterstützt in Snowpark“, die angibt, ob die jeweilige Bibliothek in der Liste der von Snowflake unterstützten Pakete in Snowpark enthalten ist.

Eine Spalte „Importanzahl“, die anzeigt, wie oft jede Bibliothek über alle Dateien hinweg importiert wurde.

Eine Spalte „Dateiabdeckung“, die den Prozentsatz der Dateien anzeigt, die mindestens einen Import jeder Bibliothek enthalten. Beispiel:

Wenn ‚sys‘ 29 Mal in den Importanweisungen angezeigt wird, aber nur in 28,16 % der Dateien verwendet wird, deutet dies darauf hin, dass es in der Regel nur einmal pro Datei importiert wird, in der es verwendet wird.

In der Kategorie „Sonstigeׅ“ könnten 56 Importe in 100 % der Dateien angezeigt werden.

Detaillierte Informationen zum Import pro Datei finden Sie in der ImportUsagesInventory.csv-Datei in den Ausgabeberichte.

Dateizusammenfassung¶

Gefahr

Der Abschnitt Dateizusammenfassung wurde seit Version 2.0.2 entfernt. Sie können jetzt finden:

Eine Zusammenfassung der Dateien und Dateitypen in der detaillierte Bericht

Eine vollständige Liste aller Dateien (sowohl analysierte als auch nicht analysierte) unter der Dateibestand

Der zusammenfassende Bericht enthält mehrere Tabellen mit Metriken, die nach Dateityp und -größe geordnet sind. Diese Metriken geben Aufschluss über das Volumen der Codebasis und helfen, den erforderlichen Aufwand für das Migrationsprojekt abzuschätzen.

Der Snowpark Migration Accelerator analysiert alle Dateien in Ihrer Quellcodebasis, einschließlich der Code- und Nicht-Code-Dateien. Ausführliche Informationen zu den gescannten Dateien finden Sie im Bericht files.csv.

Die Dateizusammenfassung enthält mehrere Abschnitte. Lassen Sie uns jeden Abschnitt im Detail betrachten.

Dateitypzusammenfassung¶

Die Dateitypzusammenfassung zeigt eine Liste aller Dateierweiterungen an, die in Ihrem gescannten Code-Repository gefunden wurden.

.png> „Bild“)

Die aufgeführten Dateierweiterungen zeigen an, welche Arten von Codedateien SMA analysieren kann. Für jede Dateierweiterung finden Sie die folgenden Informationen:

Codezeilen - Die Gesamtzahl der ausführbaren Codezeilen in allen Dateien mit dieser Erweiterung. Kommentare und Leerzeilen werden in dieser Aufzählung nicht mitgezählt.

Anzahl der Dateien - Die Gesamtzahl der gefundenen Dateien mit dieser Erweiterung.

Prozentsatz der gesmanten Dateien - Der prozentuale Anteil der Dateien mit dieser Erweiterung an allen Dateien im Projekt.

Um Ihren Workload zu analysieren, können Sie leicht feststellen, ob er hauptsächlich aus Skriptdateien (wie Python oder R), Notebook-Dateien (wie Jupyter-Notebooks) oder SQL-Dateien besteht. Diese Informationen helfen Ihnen, die wichtigsten Arten von Codedateien in Ihrem Projekt zu bestimmen.

Notebook-Größe nach Sprache¶

Das Tool bewertet die Notebooks in Ihrer Codebasis und weist ihnen eine „T-Shirt“-Größe (S, M, L, XL) zu, basierend auf der Anzahl der enthaltenen Codezeilen. Diese Größen helfen bei der Einschätzung der Komplexität und des Umfangs eines jeden Notebooks.

.png> „Bild“)

Die Größen der Notebooks sind nach der wichtigsten Programmiersprache kategorisiert, die in jedem Notebook verwendet wird.

Notebook-Statistiken nach Sprache¶

Diese Tabelle zeigt die Gesamtzahl der Codezeilen und Zellen in allen Notebooks, geordnet nach Programmiersprache.

.png> „Bild“)

Diese Noteboos ksind nach der primären Programmiersprache geordnet, die darin verwendet wird.

Codedateiinhalt¶

Wenn Sie SMA ausführen, ändert sich der Name der Registerkarte entsprechend Ihrer Ausgangssprache:

Für Python-Quelldateien wird auf der Registerkarte „Python-Dateiinhalt“ angezeigt

Für Scala-Quelldateien wird auf der Registerkarte „Scala-Dateiinhalt“ angezeigt

Diese Zeile zeigt, wie viele Dateien Spark API-Referenzen enthalten. Die Zeile „Spark-Verwendungen“ wird angezeigt:

Die Anzahl der Dateien, die Spark APIs verwenden

Welchen Prozentsatz diese Dateien an den analysierten Dateien der gesamten Codebasis ausmachen

.png> „Bild“)

Mit dieser Metrik können Sie feststellen, wie viel Prozent der Dateien keine Spark API-Referenzen enthalten. Ein niedriger Prozentsatz deutet darauf hin, dass vielen Codedateien Spark-Abhängigkeiten fehlen, was bedeuten könnte, dass der Migrationsaufwand geringer ist als ursprünglich geschätzt.

Codedateigrößen¶

Der Name der Registerkarte „Dateigrößen“ ändert sich je nach Ihrer Ausgangssprache:

Für Python-Quelldateien wird sie als „Python-Dateigrößen“ angezeigt

Für Scala-Quelldateien wird sie als „Scala-Dateigrößen“ angezeigt

Die Codebasis-Dateien sind nach „T-Shirt“-Größen kategorisiert (S, M, L, XL). Jede Größe hat spezifische Kriterien, die in der Spalte „Größe“ beschrieben sind. Die Tabelle zeigt auch, wie viel Prozent aller Python-Dateien in jede Größenkategorie fallen.

.png> „Bild“)

Wenn Sie die Verteilung der Dateigrößen in Ihrer Codebasis verstehen, können Sie die Komplexität der Workload besser einschätzen. Ein hoher Prozentsatz an kleinen Dateien deutet in der Regel auf einfachere, weniger komplexe Workloads hin.

Problemzusammenfassung¶

Die Problemzusammenfassung liefert wichtige Informationen über mögliche Probleme, die beim Scannen des Codes gefunden wurden. Wenn Sie von der Bewertung zur Konvertierung übergehen, sehen Sie eine Liste der EWIs (Fehler, Warnungen und Probleme), die in Ihrer Codebasis entdeckt wurden. Eine ausführliche Erklärung dieser Probleme finden Sie im Abschnitt „Problemanalyse“ in der Dokumentation.

Oben in der Problemzusammenfassung finden Sie eine Tabelle, die einen Überblick über alle identifizierten Probleme bietet.

Die Tabelle enthält zwei Zeilen.

Die „Anzahl der Probleme“ ist die Gesamtzahl aller Problemcodes, die in jeder Kategorie gefunden wurden.

Die „Anzahl der eindeutigen Probleme“ gibt die Anzahl der eindeutigen Fehlercodes an, die in jeder Kategorie gefunden wurden.

Die Probleme sind in drei Hauptkategorien unterteilt:

Warnungen weisen auf mögliche Unterschiede zwischen Quell- und Zielplattform hin, die zwar keine sofortigen Maßnahmen erfordern, aber beim Testen berücksichtigt werden sollten. Dazu könnten leichte Abweichungen im Verhalten für Randfälle oder Benachrichtigungen über Änderungen in der Anzeige im Vergleich zur Ausgangsplattform gehören.

Konvertierungsprobleme heben Elemente hervor, die entweder nicht konvertiert werden konnten oder die eine zusätzliche Konfiguration benötigen, um auf der Zielplattform ordnungsgemäß zu funktionieren.

Parsing-Probleme treten auf, wenn das Tool bestimmte Code-Elemente nicht interpretieren kann. Dies sind kritische Probleme, die sofortige Aufmerksamkeit erfordern und in der Regel durch nicht kompilierbaren Quellcode oder falsche Code-Extraktion verursacht werden. Wenn Sie glauben, dass Ihr Quellcode korrekt ist, aber dennoch Parsing-Fehler erhalten, kann dies an einem nicht erkannten Muster in SMA liegen. In solchen Fällen ist bitte ein Problem zu melden und fügen Sie den problematischen Quellcodeabschnitt bei.

Die Tabelle fasst die Gesamtzahl für jedes Element zusammen.

Unterhalb dieser Tabelle finden Sie eine Liste mit eindeutigen Problemcodes und deren Beschreibungen.

Jeder Problemcodeeintrag bietet:

Den eindeutigen Problembezeichner

Eine Beschreibung des Problems

Die Anzahl der Vorkommen

Der Schweregrad (Warnung, Konvertierungsfehler oder Parsing-Fehler)

Sie können auf einen beliebigen Problemcode klicken, um eine ausführliche Dokumentation anzuzeigen, die Folgendes enthält:

Eine vollständige Beschreibung des Problems

Beispielcode

Empfohlene Lösungen

Wenn Sie z. B. auf den ersten oben gezeigten Problemcode klicken (SPRKPY1002), gelangen Sie zur entsprechenden Dokumentationsseite.

Standardmäßig zeigt die Tabelle nur die 5 wichtigsten Probleme an. Um alle Probleme anzuzeigen, klicken Sie auf die Schaltfläche SHOW ALL ISSUES unterhalb der Tabelle. Sie können auch die Suchleiste oberhalb der Tabelle verwenden, um bestimmte Probleme zu finden.

Die verbleibenden Konvertierungsarbeiten zu verstehen, ist im Bewertungsmodus entscheidend. Detaillierte Informationen zu jedem Problem und seinem Speicherort finden Sie im Problembestand im Ordner Berichte.

Ausführungszusammenfassung¶

Die Ausführungszusammenfassung bietet einen umfassenden Überblick über die jüngsten Analysen des Tools. Der Abschnitt umfasst folgende Themen:

Die Bewertung der Codeanalyse

Benutzerdetails

Die einzigartige Ausführung ID

Versionsinformationen sowohl für SMA als auch für Snowpark API

Speicherorte der Projektordner, die während der [Projekterstellung] angegeben wurden (../project-overview/project-setup.md#creating-a-new-project)

.png> „Bild“)

Anhänge¶

Die Anhänge enthalten zusätzliche Referenzinformationen, die Ihnen helfen können, die vom Programm SMA erzeugte Ausgabe besser zu verstehen.

.png> „Bild“)

Diese Anleitung enthält allgemeine Informationen zur Verwendung des Snowpark Migration Accelerator (SMA). Der Inhalt wird zwar regelmäßig aktualisiert, konzentriert sich aber eher auf die universelle Verwendung von SMA als auf Details zu bestimmten Codebases.

Das ist es, was die meisten Benutzer sehen werden, wenn sie den Snowpark Migration Accelerator (SMA) ausführen. Wenn Sie eine ältere Version verwenden, sehen Sie möglicherweise stattdessen die unten abgebildete verkürzte Zusammenfassung der Bewertung.

Verkürzte Zusammenfassung der Bewertung [Veraltet]¶

Wenn Ihre Bereitschaftsbewertung niedrig ist, könnte Ihre Migrationsübersicht wie folgt aussehen:

.png> „Bild“)

Diese Zusammenfassung enthält die folgenden Informationen:

Ausführungsdatum: Zeigt an, wann Ihre Analyse durchgeführt wurde. Sie können die Ergebnisse einer früheren Ausführung für dieses Projekt anzeigen.

Ergebnis: Zeigt an, ob Ihre Workload für die Migration geeignet ist, basierend auf der Bereitschaftsbewertung. Die Bereitschaftsbewertung ist ein vorläufiges Bewertungsinstrument und garantiert nicht den Erfolg der Migration.

Eingabeordner: Speicherort der Quelldateien, die analysiert wurden.

Ausgabeordner: Speicherort, an dem Analyseberichte und konvertierte Codedateien gespeichert werden.

Dateien gesamt: Anzahl der analysierten Dateien.

Ausführungszeit: Dauer des Analyseprozesses.

Identifizierte Spark-Referenzen: Anzahl der Spark API-Aufrufe, die in Ihrem Code gefunden wurden.

Anzahl der Python (oder Scala)-Dateien: Anzahl der Quellcodedateien in der angegebenen Programmiersprache.

Nächste Schritte¶

Die Anwendung bietet mehrere zusätzliche Features, auf die Sie über die in der folgenden Abbildung gezeigte Weboberfläche zugreifen können.

Bewertung wiederholen - Sie können die Bewertung erneut durchführen, indem Sie auf die Schaltfläche Bewertung wiederholen auf der Seite „Bewertungsergebnisse“ klicken. Dies ist nützlich, wenn Sie Änderungen am Quellcode vornehmen und die aktualisierten Ergebnisse sehen möchten.

Protokollordner anzeigen - Öffnet den Ordner mit den Protokollen der Bewertungsausführung. Diese Textdateien enthalten detaillierte Informationen über den Bewertungsprozess und sind für die Fehlerbehebung bei Fehlschlagen der Bewertung unerlässlich. Wenn Sie technische Unterstützung benötigen, werden Sie möglicherweise aufgefordert, diese Protokolle weiterzugeben.

Berichte anzeigen - Öffnet den Ordner mit den Bewertungsberichten. Dazu gehören der detaillierte Bewertungsbericht, das Spark-Referenzinventar und andere Analysen Ihrer Quellcodebasis. Jeder Berichtstyp wird in dieser Dokumentation ausführlich erläutert.

Weiter zur Konvertierung - Auch wenn dies der nächste logische Schritt zu sein scheint, ist es wichtig, dass Sie die Bewertungsergebnisse gründlich überprüfen, bevor Sie fortfahren. Beachten Sie, dass für die Durchführung einer Konvertierung ein Zugangscode erforderlich ist. Weitere Informationen finden Sie im [Konvertierungsabschnitt in dieser Dokumentation](../conversion/README. md).

Auf den folgenden Seiten finden Sie detaillierte Informationen zu den Berichten, die bei jeder Ausführung des Tools erstellt werden.