Snowpipe Streaming¶

Snowpipe Streamingは、ストリーミングデータを継続的かつ低レイテンシーでSnowflakeに直接読み込むためのSnowflakeのサービスです。ほぼリアルタイムのデータ取り込みと分析が可能になり、タイムリーな洞察と迅速な業務対応が可能になります。多様なストリームソースからの大量のデータを、数秒以内にクエリや分析に利用できるようにします。

Snowpipe Streamingの値¶

リアルタイムのデータ可用性: 従来のバッチ読み込み中とは異なり、データが到着した時点で取り込み、ライブダッシュボード、リアルタイムアナリティクス、不正検出などのユースケースをサポートします。

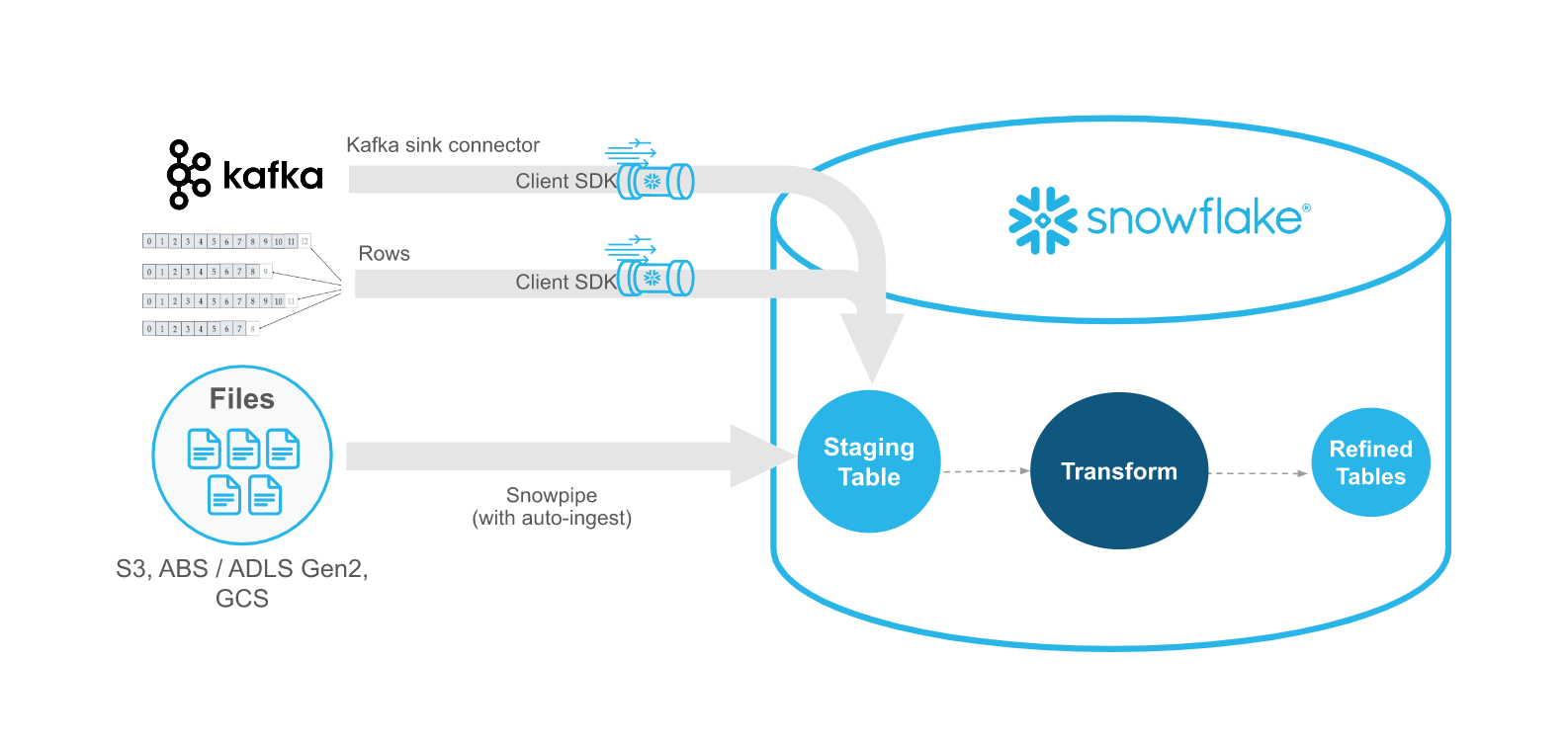

効率的なストリームワークロード:Snowflake Ingest SDKs を活用し、中間クラウドストレージをバイパスして行をテーブルに直接書き込みます。この直接的なアプローチは、レイテンシーを削減し、インジェストアーキテクチャを簡素化します。

データパイプラインの簡素化:アプリケーションイベント、 IoT センサー、Change Data Capture (CDC) ストリーム、メッセージキュー (Apache Kafka など) などのソースからの継続的なデータパイプラインのための合理化されたアプローチを提供します。

サーバーレスでスケーラブル: サーバーレスオファリングとして、インジェストの負荷に応じてコンピュートリソースを自動的にスケーリングするため、インジェストタスクのウェアハウス管理を手動で行う必要がありません。

ストリーミングのコスト効率:請求はストリーミング・インジェスト用に最適化されているため、小容量のバッチ COPY 処理を頻繁に行う場合と比較して、大容量かつ低遅延のデータフィードに対してコスト効率の高いソリューションを提供できる可能性があります。

Snowpipe Streamingを使用すると、Snowflake Data Cloud上でリアルタイムのデータアプリケーションを構築できるため、可用性の高いデータに基づいて意思決定を行うことができます。

Snowpipeストリーミングの実装¶

Snowpipe Streamingは、多様なデータ処理ニーズと期待パフォーマンスに対応するため、2つの異なる実装を提供します。ハイ パフォーマンス アーキテクチャのSnowpipe Streaming(プレビュー)とクラシックアーキテクチャのSnowpipe Streamingです。

ハイ パフォーマンス アーキテクチャによるSnowpipeストリーム(プレビュー)

Snowflakeは、スループットを大幅に向上させ、ストリーミングパフォーマンスを最適化し、予測可能なコストモデルを提供するために、この次世代実装を設計し、高度なデータストリーミング機能のステージを設定しました。

キーの特徴:

SDK: 新しい

snowpipe-streamingSDK を使用してください。価格設定: 透明性のあるスループットベースの価格設定 (非圧縮 GB) あたりのクレジットが特徴です。

データフロー管理: PIPE オブジェクトを使用してデータフローを管理し、インジェスト時に軽量の変換を可能にします。チャンネルはこの PIPE オブジェクトに対して開かれます。

取り込み: PIPE を介した直接的で軽量なデータ取り込みのための REST API を提供します。

スキーマ検証: PIPE で定義されたスキーマに対して、インジェスト時にサーバー側で行われるパフォーマンス。

パフォーマンスインジェストされたデータのスループットを大幅に向上させ、クエリ効率を改善するように設計されています。

特に新しいストリーミング・プロジェクトでは、この先進的なアーキテクチャをぜひお試しください。

-

これは一般的に利用可能なオリジナルの実装で、確立されたデータパイプラインに信頼性の高いソリューションを提供します。

キーの特徴:

SDK:Snowflake-ingest-java SDK (4.x までのすべてのバージョン) を使用します。

データフロー管理: ストリーミングの取り込みに PIPE オブジェクトの概念を使用しません。チャンネルはターゲット・テーブルに対して直接構成され、オープンされます。

価格: インジェストに使用されるサーバーレスコンピュートリソースとアクティブクライアント接続数の組み合わせに基づきます。

インプリメンテーションの選択¶

実装を選択する際には、差し迫ったニーズと長期的なデータ戦略を考慮してください。

新しいストリーミングプロジェクト:Snowpipe Streaming High-Performance Architecture (プレビュー)は、将来を見据えた設計、優れたパフォーマンス、スケーラビリティ、コスト予測可能性を備えているため、評価をお勧めします。

パフォーマンス要件高性能アーキテクチャは、スループットを最大化し、リアルタイムパフォーマンスを最適化するように構築されています。

価格設定の好み: ハイパフォーマンスアーキテクチャはスループットベースの明確な価格設定を提供し、クラシックアーキテクチャはサーバーレスのコンピュート使用量とクライアント接続に基づいて請求します。

既存のセットアップ: クラシック・アーキテクチャを使用している既存のアプリケーションは、引き続き使用できます。将来の拡張や再設計の際には、高性能アーキテクチャへの移行や組み込みをご検討ください。

機能セットと管理:ハイパフォーマンスアーキテクチャの PIPE オブジェクトは、クラシックアーキテクチャにはない強化された管理機能と変換機能を導入しています。

Snowpipe Streaming 対 Snowpipe¶

SnowpipeストリームはSnowpipeを補完するものであり、Snowpipeの代わりではありません。Snowpipe Streaming API は、データをファイルに書き込むのではなく、行(Apache Kafkaトピックなど)でストリームするストリーミングシナリオで使用します。API は、記録を生成または受信する既存のカスタムJavaアプリケーションを含むインジェストワークフローに適合します。WIth API では、Snowflakeのテーブルにデータをロードするためのファイルを作成する必要はありません。API は、データが利用可能になると、Snowflakeにデータのストリームを自動的に継続的に読み込みます。

次のテーブルでは、Snowpipe StreamingとSnowpipeの違いについて説明します。

カテゴリ |

Snowpipe Streaming |

Snowpipe |

|---|---|---|

ロードするデータの形式 |

行 |

ファイル。既存のデータパイプラインがBLOBストレージにファイルを生成する場合は、 API の代わりにSnowpipeを使用することをお勧めします。 |

サードパーティのソフトウェア要件 |

Snowflake Ingest SDK 用のカスタムJavaアプリケーションのコードラッパー。 |

なし |

データの順序 |

各チャネル内の順序付き挿入 |

サポート対象外です。Snowpipeは、クラウドストレージのファイル作成タイムスタンプとは異なる順序でファイルからデータをロードできます。 |

ロード履歴 |

SNOWPIPE_STREAMING_FILE_MIGRATION_HISTORY ビュー (Account Usage) に記録されたロード履歴。 |

COPY_HISTORY (Account Usage) および COPY_HISTORY 関数 (Information Schema) に記録されたロード履歴。 |

パイプオブジェクト |

古典的なアーキテクチャではパイプオブジェクトは必要ありません。API はターゲットテーブルに直接記録を書き込みます。ハイパフォーマンスアーキテクチャにはパイプオブジェクトが必要です。 |

ステージングされたファイルデータをキューに入れ、ターゲットテーブルにロードするパイプオブジェクトが必要です。 |

ソフトウェア要件¶

Java SDK¶

特定の Java SDKs は Snowpipe ストリーミングサービスとのインタラクションを容易にします。Maven Central Repository から SDKs をダウンロードできます。以下のリストは、使用するSnowpipeストリーミングアーキテクチャによって異なる依存関係を示しています。

高性能アーキテクチャのSnowpipeストリーミング用:

SDK: 新しい Snowpipe-streaming SDK を使用してください。

Javaバージョン:Java 11以降が必要です。

Snowpipe Streaming Classicのために:

SDK:Snowflake-ingest-sdk バージョン 4.X 以降を使用してください。

Javaバージョン:Java 8以降が必要です。

追加の前提条件:Java Cryptography Extension (JCE) Unlimited Strength Jurisdiction Policy Files が Java 8 環境にインストールされている必要があります。

重要

SDK は、Snowflakeに対して REST API を呼び出します。接続を許可するには、ネットワークのファイアウォールの規則調整が必要になる場合があります。

カスタムのクライアントアプリケーション¶

API には、データの行をポンピングし、発生したエラーを処理できるカスタムJavaアプリケーション・インターフェイスが必要です。アプリケーションが継続的に実行され、障害から回復できることを保証する必要があります。指定した行のバッチに対して、 API は ON_ERROR = CONTINUE | SKIP_BATCH | ABORT に同等のものをサポートします。

CONTINUE: 許容できるデータ行のロードを続け、すべてのエラーを返します。SKIP_BATCH: バッチ全体の行で何らかのエラーが発生した場合、ロードをスキップしてすべてのエラーを返します。ABORT(デフォルト設定): 行のバッチ全体を中止し、最初のエラーが発生したときに例外をスローします。

Snowpipe Streaming classic の場合、アプリケーションは insertRow (単一行) または insertRows (行セット) メソッドのレスポンスを使用してスキーマ検証を行います。ハイパフォーマンス・アーキテクチャのエラー処理については、 エラー処理 を参照してください。

チャネル¶

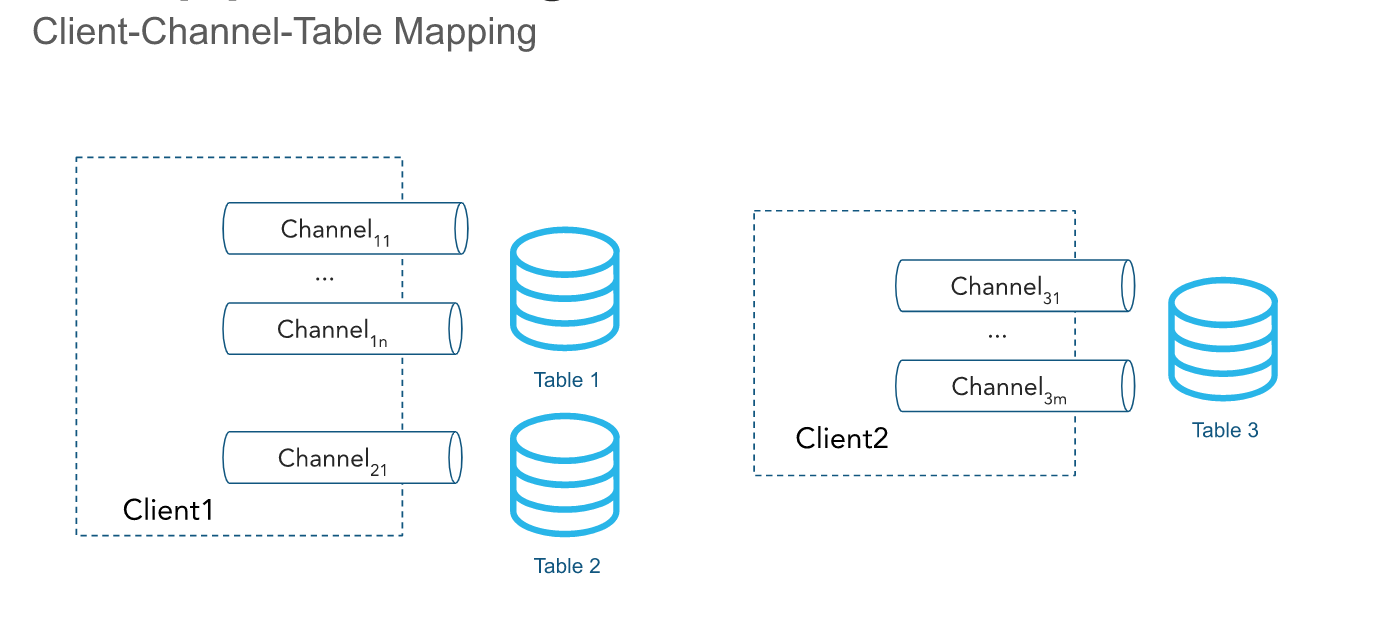

API は、1つ以上の チャンネル を通じて行をインジェストします。チャネルは、データをテーブルにロードするためのSnowflakeへの論理的な名前付きストリーミング接続を表します。単一のチャネルは、Snowflakeの1つのテーブルに必ずマップされます。ただし、同じテーブルを複数のチャネルがポイントすることはできます。クライアント SDK は複数のテーブルに複数のチャンネルを開くことができますが、 SDK はアカウント間でチャンネルを開くことはできません。行の順序とそれに対応するオフセットトークンはチャネル内で保持されますが、同じテーブルをポイントするチャネル間では保持されません。

チャネルは、クライアントが活発にデータを挿入していると長い間維持され、オフセットトークン情報が保持されるため再利用されるべきです。チャネル内のデータはデフォルトで1秒ごとに自動的にフラッシュされ、チャネルを閉じる必要はありません。詳細については、 遅延 をご参照ください。

チャンネルと関連するオフセットメタデータが不要に なった場合、 DropChannelRequest API を使用して、 チャンネルを永久的に削除することができます。チャネルを削除するには2つの方法があります:

クロージングでチャネルを削除する。チャネル内のデータは、チャネルが削除される前に自動的にフラッシュされます。

やみくもにチャネルを削除する。チャネルをドロップすると保留中のデータがすべて破棄され、すでにオープンされているチャネルが無効になる可能性があるため、この方法はお勧めしません。

SHOW CHANNELS コマンドを実行すると、アクセス権限のあるチャンネルをリストできます。詳細については、 SHOW CHANNELS をご参照ください。

注釈

非アクティブなチャネルとそのオフセットトークンは、30日を過ぎると自動的に削除されます。

オフセットトークン¶

オフセットトークン は、クライアントが行サブミッションメソッドリクエストに含めることができる文字列です(例えば、単一または複数の行の場合)。これにより、チャネル単位で取り込みの進捗を追跡することができます。具体的には、クラシック・アーキテクチャでは insertRow または insertRows、ハイパフォーマンス・アーキテクチャでは appendRow または appendRows が使用されます。トークンはチャネルの作成時に NULL に初期化され、提供されたオフセットトークンを持つ行が非同期プロセスを通じてSnowflakeにコミットされるときに更新されます。クライアントは、定期的に getLatestCommittedOffsetToken メソッドリクエストを行い、特定のチャネルの最新のコミット オフセット トークンを取得し、それを使用してインジェストの進捗状況を推論することができます。このトークンは、Snowflake が重複排除を実行するために使用するものでは ありません。ただし、クライアントはカスタムコードを使用して重複排除を実行するためにこのトークンを使用することができます。

クライアントがチャネルを再度開くと、最新の永続化されたオフセットトークンが返されます。クライアントは、トークンを使用してデータソース内の位置をリセットし、同じデータを2回送信することを回避できます。チャネルの再開イベントが発生すると、Snowflakeにバッファーされたデータはコミットを回避するために破棄されることに注意してください。

最新のコミットされたオフセットトークンを使用して、次の一般的な使用例を実行できます。

インジェスチョンの進行状況の追跡

特定のオフセットがコミットされているかどうかを、最後にコミットされたオフセットトークンと比較することによって確認します。

ソースオフセットの提出と、すでにコミットされたデータのパージ

重複排除の有効化と、データを1回だけ配信することの保証

たとえば、Kafkaコネクタはトピックから <パーティション>:<オフセット> などのオフセットトークンを読み取ることができます。または、パーティションがチャネル名にエンコードされている場合は、単に <オフセット> を読み取ることができます。次のシナリオを検討してください。

Kafkaコネクタがオンラインになり、Kafkaトピック

TのPartition 1に対応するチャネルがT:P1というチャネル名で開きます。コネクタは、Kafkaパーティションからの記録の読み取りを開始します。

コネクタは API を呼び出し、記録に関連付けられたオフセットをオフセットトークンとして使用して

insertRowsメソッドリクエストを作成します。たとえば、オフセットトークンは

10で、Kafkaパーティションの10番目の記録を参照します。コネクタは定期的に

getLatestCommittedOffsetTokenメソッドリクエストを実行し、インジェストの進行状況を判断します。

Kafkaコネクタがクラッシュした場合は、次のプロシージャを完了して、Kafkaパーティションの正しいオフセットから記録の読み取りを再開できます。

Kafkaコネクタがオンラインに戻り、以前と同じ名前を使用してチャネルを再度開きます。

コネクタは API を呼び出し、

getLatestCommittedOffsetTokenメソッドリクエストを作成して、パーティションの最新のコミット済みオフセットを取得します。たとえば、最新の永続オフセットトークンが

20であるとします。コネクタは、Kafka読み取り APIs を使用して、オフセット+1 (この例では

21)に対応するカーソルをリセットします。コネクタは記録の読み取りを再開します。読み取りカーソルが正常に再配置されると、重複するデータは取得されません。

別の例では、アプリケーションはディレクトリからログを読み込み、Snowpipe Streaming Client SDK を使用してこれらのログをSnowflakeにエクスポートします。次を実行するログエクスポートアプリケーションをビルドできます。

ログディレクトリ内のファイルをリストする。

ログフレームワークが生成するログファイルは辞書順に並べることができ、新しいログファイルはこの順序の最後に配置されるとします。

ログファイルを1行ずつ読み取り、 API を呼び出して、ログファイル名と行数またはバイト位置に対応するオフセットトークンを使用して

insertRowsメソッドリクエストを作成する。たとえば、オフセットトークンは

messages_1.log:20のようになります。ここで、messages_1.logはログファイルの名前で、20は行番号です。

アプリケーションがクラッシュしたり、再起動が必要になったりすると、 API が呼び出され、最後にエクスポートされたログファイルと行に該当するオフセットトークンを取得する getLatestCommittedOffsetToken メソッドリクエストが作成されます。例を続けると、これは messages_1.log:20 になります。その後、アプリケーションは messages_1.log を開き、行 21 を検索して、同じログ行が2回インジェストされないようにします。

注釈

オフセットトークンの情報が失われる可能性があります。オフセットトークンはチャネルオブジェクトにリンクされており、チャネルを使用して新しいインジェスチョンが30日間実行されない場合、チャネルは自動的にクリアされます。オフセットトークンの損失を防ぐために、別のオフセットを維持し、必要に応じてチャネルのオフセットトークンをリセットすることを検討してください。

offsetToken および continuationToken のロール¶

offsetToken および continuationToken の両方とも1回だけのデータ配信を保証するために使用されますが、これらは異なる目的を果たし、異なるシステムによって管理されます。主な違いは、誰がトークンの値とその使用範囲を管理するかです。

:code:`continuationToken`(高性能アーキテクチャにのみ適用):

このトークンはSnowflakeによって管理され、単一の継続的なストリーミングセッションの状態を維持するために不可欠です。クライアントが

Append RowsAPI を使用してデータを送信する場合、SnowflakeはcontinuationTokenを返します。クライアントは次のリクエストでこのトークンを使用して、データが正しい順序でギャップなく受信されるようにする必要があります。Snowflakeはトークンを使用して、SDK 再試行が発生した場合に重複データを検出し、防ぎます。:code:`offsetToken`(従来のアーキテクチャと高性能アーキテクチャの両方に適用):

このトークンは、外部ソースからの1回限りの配信を可能にするユーザー定義の識別子です。Snowflakeは、このトークンを独自の内部操作や再取り込みの防止に使用することはありません。代わりに、Snowflakeはこの値を単純に保存します。SnowflakeからOffsetTokenを読み取り、それを使用して自身の取り込みの進捗を追跡し、外部ストリームのリプレイが必要な場合に重複データの送信を回避するのは、外部システム(Kafkaコネクタなど)の責任です。

1回限りの配信のベストプラクティス¶

正確に1回限りの配信を実現することは困難な場合があり、カスタムコードでは次の原則に従うことが重要です。

例外、障害、またはクラッシュから確実かつ適切に復旧するには、常にチャネルを再開し、最新のコミットされたオフセットトークンを使用してインジェスチョンを再起動する必要があります。

アプリケーションは独自のオフセットを維持できますが、Snowflakeによって提供される最新のコミットされたオフセットトークンを信頼できる情報源として使用し、それに応じて独自のオフセットをリセットすることが重要です。

独自のオフセットを信頼できる情報源として扱う必要がある唯一の例は、Snowflakeからのオフセットトークンが NULL に設定またはリセットされる場合です。NULL オフセットトークンは通常、次のいずれかを意味します。

これは新しいチャネルであるため、オフセットトークンが設定されていない。

ターゲットテーブルがドロップされて再作成されたため、チャネルが新規とみなされます。

30日間、チャネルを介したインジェスチョンアクティビティがなかったため、チャネルは自動的にクリーンアップされ、オフセットトークン情報は失われました。

必要に応じて、最新のコミットされたオフセットトークンに基づいてすでにコミットされているソースデータを定期的にパージし、独自のオフセットを提出することができます。

Snowpipe Streamingチャネルがアクティブなときにテーブルスキーマが変更された場合、チャネルを再度開く必要があります。 Snowflake Kafkaコネクタはこのシナリオを自動的に処理しますが、Snowflake Ingest SDK を直接使用する場合は、自分でチャネルを再オープンする必要があります。

Snowpipe Streamingを使用したKafkaコネクタが1回限りの配信を実現する方法の詳細については、 必ず1回のセマンティクス をご参照ください。

データを Apache Iceberg™ テーブルにロードする¶

Snowflake Ingest SDK バージョン3.0.0以降では、Snowpipe StreamingはSnowflake管理 Apache Iceberg テーブルにデータをインジェストできます。Snowpipe Streaming Ingest Java SDK は、標準のSnowflakeテーブル(非Iceberg)とIcebergテーブルの両方へのロードをサポートしています。

詳細については、 Snowpipe ストリーミング クラシックを Apache Iceberg™ テーブルで使用します。 をご参照ください。

遅延¶

Snowpipe Streamingは、チャネル内のデータを1秒ごとに自動的にフラッシュします。データをフラッシュするためにチャネルを閉じる必要はありません。

Snowflake Ingest SDK バージョン 2.0.4以降では、オプション MAX_CLIENT_LAG を使用して遅延を設定できます。

標準的なSnowflakeテーブル(Iceberg以外)の場合、デフォルトの

MAX_CLIENT_LAGは1秒です。Icebergテーブル(Snowflake Ingest SDK バージョン3.0.0以降でサポート)の場合、デフォルトの

MAX_CLIENT_LAGは30秒です。

最大遅延時間は10分まで設定できます。 詳細については、 MAX_CLIENT_LAG および Snowpipe Streamingの推奨レイテンシ構成 をご参照ください。

Snowpipe Streaming用のKafkaコネクタには独自のバッファがあることに注意してください。Kafkaバッファのフラッシュ時間に達した後、データはSnowpipe Streamingを通じてSnowflakeに1秒の遅延で送信されます。詳細については、 バッファのフラッシュ時間 をご参照ください。

クラシック・アーキテクチャにおける最適化ファイルへの移行¶

API は、チャネルからの行をクラウドストレージのBLOBに書き込み、ターゲットテーブルにコミットします。最初に、ターゲットテーブルに書き込まれたストリームデータは、仮の中間ファイル形式で格納されます。このステージでは、テーブルは「混合テーブル」と見なされます。これは、ネイティブファイルと中間ファイルが混ざった状態でパーティションされたデータが格納されているためです。自動化されたバックグラウンド・プロセスにより、アクティブな中間ファイルから、必要に応じてクエリや DML の操作に最適化されたネイティブ・ファイルにデータが移行されます。

クラシック・アーキテクチャにおける複製¶

Snowpipe Streamingは、Snowpipe Streamingとそれに関連するチャネルオフセットによって入力されたSnowflakeテーブルの 複製とフェールオーバー を、異なる リージョン のソースアカウントとターゲットアカウント間、また クラウドプラットフォーム 間でサポートしています。

複製はハイ パフォーマンス アーキテクチャではサポートされていません。

詳細については、 複製およびSnowpipe Streaming をご参照ください。

挿入のみの操作¶

API は現在、行の挿入に限られています。データを変更、削除、または結合するには、「生」記録を1つ以上のステージングされたテーブルに書き込みます。継続的なデータパイプライン を使用してデータをマージ、結合、または変換し、変更されたデータを宛先のレポートテーブルに挿入します。

クラスおよびインターフェイス¶

クラシックアーキテクチャのクラスとインターフェイスのドキュメントについては、 Snowflake Ingest SDK API をご参照ください。

クラシック・アーキテクチャとハイパフォーマンス・アーキテクチャの違いについては、 API differences を参照してください。

サポートされているJavaデータ型¶

次のテーブルは、Snowflake列へのインジェスチョンでサポートされているJavaデータ型をまとめたものです。

Snowflake列型 |

許可されたJavaデータ型 |

|---|---|

|

|

|

|

|

|

|

|

|

ブール変換の詳細 をご参照ください。 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

必要なアクセス権限¶

Snowpipe Streaming API を呼び出すには、次の権限を持つロールが必要です。

オブジェクト |

権限 |

|---|---|

テーブル |

OWNERSHIP または INSERT と EVOLVE SCHEMA の最小 (Snowpipe StreamingでKafkaコネクタのスキーマ進化を使用する場合にのみ必要) |

データベース |

USAGE |

スキーマ |

USAGE |

パイプ |

OPERATE(高性能アーキテクチャにのみ必要) |

制限事項¶

Snowpipe Streaming Classicでは、以下の制限にご注意ください:

Snowpipe Streaming Classicは、データベースオブジェクトの最大サイズ制限(VARCHAR、VARIANT、ARRAY および OBJECT の場合は128 MB、BINARY、GEOGRAPHY および GEOMETRY の場合は64 MB)の拡大をサポートしていません。これは:doc:

2025_03動作変更バンドル </release-notes/bcr-bundles/2025_03/bcr-1942>の一部です。Fail-safeはSnowpipe Streaming Classicで取り込まれたデータを含むテーブルをサポートしていません。このようなテーブルでは、Fail-safeをリカバリに使用することはできません。

Snowpipe Streamingは、データ暗号化に256ビット AES キーの使用のみをサポートします。

自動クラスタリング がSnowpipe Streamingが挿入する同じテーブルでも有効になっている場合、ファイル移行のコンピューティングコストが削減される可能性があります。詳細については、 Snowpipe Streaming Classicのベストプラクティス をご参照ください。

以下のオブジェクトやタイプはサポートされていません。

GEOGRAPHY および GEOMETRY データ型

列の照合順序設定

TEMPORARY テーブル

テーブルあたりのチャンネル数の合計は10kを超えることはできません。必要に応じてチャネルを再利用することをお勧めします。1テーブルあたり10kチャネル以上を開く必要がある場合は、 Snowflakeサポート までお問い合わせください。

ハイパフォーマンス・アーキテクチャには、クラシック・アーキテクチャと比較して他にも考慮すべき点や制限があります。詳細情報については、 高性能アーキテクチャの制限 をご覧ください。